rlTable

值表或Q表

描述

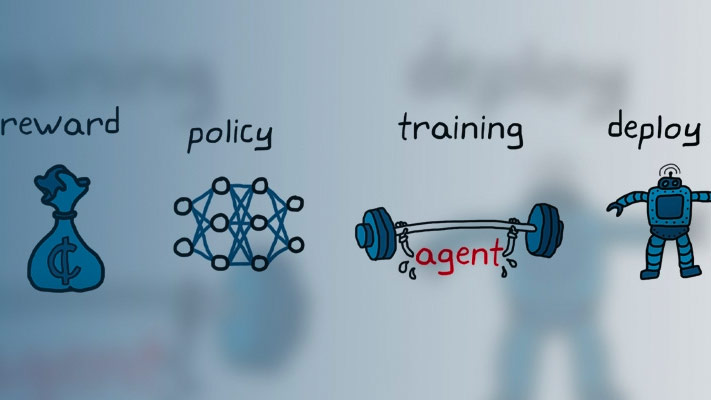

值表和Q表是表示强化学习的评价网络的一种方法。值表存储有限组观察的奖励。Q表存储相应有限观察-动作对的奖励。

方法创建值函数表示形式rlTable对象,使用rlValueRepresentation或rlQValueRepresentation对象。

创建

输入参数

属性

对象的功能

rlValueRepresentation |

强化学习代理的价值函数批评表示 |

rlQValueRepresentation |

强化学习智能体的q值函数批评表示 |

例子

另请参阅

主题

在R2019a中引入