rlRepresentation

(不推荐)用于强化学习代理的模型表示

rlRepresentation不建议使用。使用rlValueRepresentation,rlQValueRepresentation,rlDeterministicActorRepresentation,或rlStochasticActorRepresentation代替。有关更多信息,请参见兼容性的考虑.

语法

描述

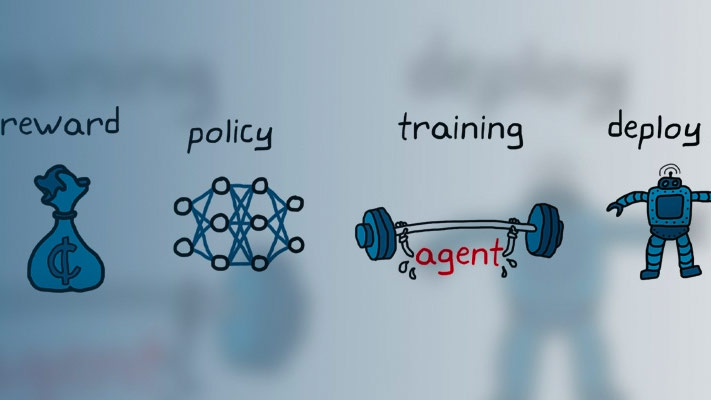

使用rlRepresentation为强化学习代理的行动者或评论家创建函数近似表示。为此,您可以为训练环境指定观察和操作信号,以及影响使用该表示的代理的训练的选项。有关创建表示的详细信息,请参见创建策略和值函数表示.

代表= rlRepresentation (网,obsInfo,actInfo“观察”,obsNames“行动”,actNames)actNames和规范actInfo.使用此语法可以为任何参与者创建表示,或者为同时将观察和操作作为输入的评论家创建表示,例如为的评论家rlDQNAgent或rlDDPGAgent代理。

tableCritic= rlRepresentation (选项卡)选项卡.创建表表示时,在创建时指定观察和操作规范选项卡.

评论家= rlRepresentation (basisFcn,W0,oaInfo)oaInfo,在那里oaInfo={obsInfo, actInfo}.使用此语法可以为评论家创建一个表示,该表示将观察和操作作为输入,例如评论家rlDQNAgent或rlDDPGAgent代理。

代表= rlRepresentation (___,repOpts)rlRepresentationOptions创建选项集repOpts.您可以将此语法用于前面的任何输入-参数组合。

例子

输入参数

输出参数

兼容性的考虑

另请参阅

功能

getActionInfo|getObservationInfo|rlDeterministicActorRepresentation|rlQValueRepresentation|rlRepresentationOptions|rlStochasticActorRepresentation|rlValueRepresentation