火车双边机器人使用加强学习代理行走

这个例子展示了如何使用深度确定性策略梯度(DDPG)代理和双延迟深度确定性策略梯度(TD3)代理训练双足机器人行走,并比较了这些训练过的代理的性能。本例中的机器人使用Simscape™Multibody™建模。

有关这些代理的更多信息,请参见深度确定性政策梯度代理和双延迟深度确定性策略梯度代理。

为了在本例中进行比较,两个agent都是在具有相同模型参数的双足机器人环境中进行训练的。代理还被配置为具有以下公共设置。

两足机器人的初始条件策略

演员和评论家的网络结构,受到了[2]的启发

演员和评论家代表的选项

训练选项(样本时间、折扣因素、小批量大小、经验缓冲长度、探索噪声)

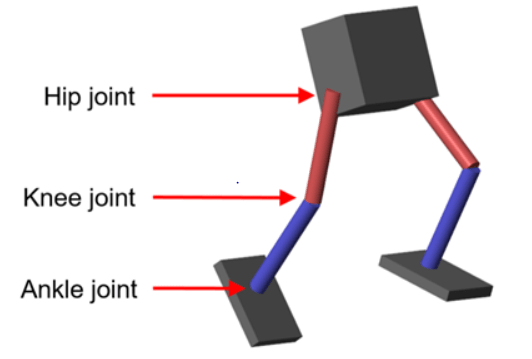

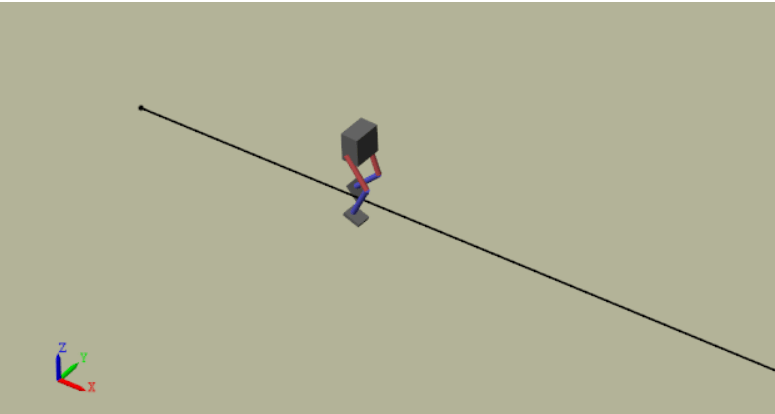

两足机器人模型

本例的强化学习环境是一个两足机器人。训练目标是让机器人用最小的控制努力走直线。

将模型的参数加载到MATLAB®工作区中。

RobotParametersrl.

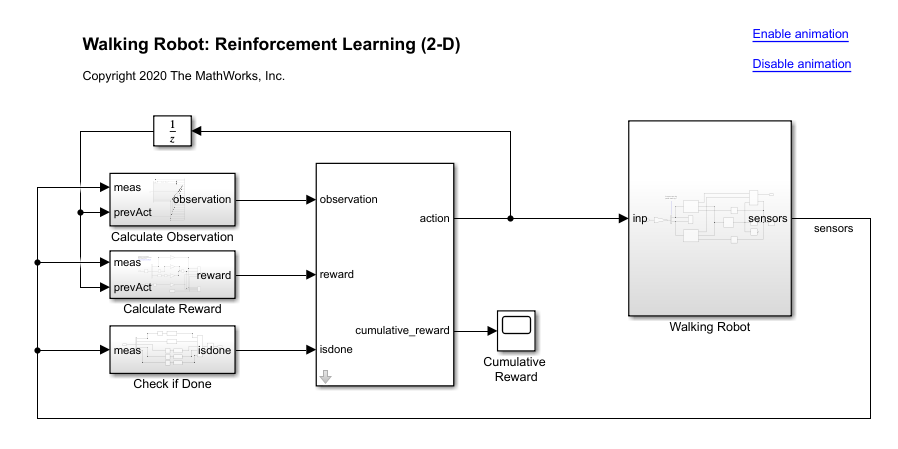

打开Simulin金宝appk模型。

mdl =“rlWalkingBipedRobot”;Open_System(MDL)

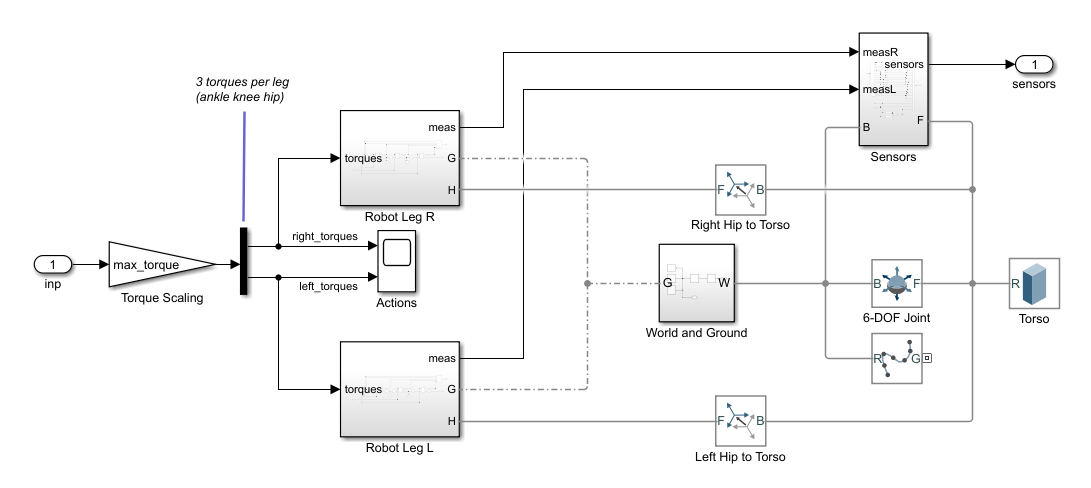

机器人使用Simscape Multibody建模。

对于这个模型:

在中性0 rad位置,两条腿都是直的,脚踝是平的。

脚部接触是使用空间接触力(Simscape多体)Simscape Multibody块。

agent可以通过施加扭矩信号来控制机器人双腿上的3个单独的关节(脚踝、膝盖和臀部)

-3来3.N·m。实际计算的动作信号在-1和1。

环境为代理人提供了29项观察。观察结果是:

Y(横向)和躯干质量中心的Z(垂直)翻译。Z方向中的平移标准化为与其他观察相似的范围。

x(前进),y(横向)和z(垂直)平移速度。

躯干的偏航、俯仰和滚转角度。

摇摆,沥青和滚动角速度的偏航。

两腿上3个关节(脚踝,膝盖,臀部)的角度位置和速度。

前一个时间步长的动作值。

如果发生以下任一条件,则会终止。

机器人躯干质心在Z方向(下降)小于0.1 m或在Y方向(横向运动)大于1 m。

辊,俯仰或偏航的绝对值大于0.7854 rad。

以下是奖励功能 ,它在每次都提供的,它受到了[1]的启发。此奖励功能鼓励代理通过提供积极的前瞻性速度来向前迈进。它还鼓励代理人通过提供不断的奖励来避免派生终止( )。奖励功能中的其他术语是对横向和纵向翻译的重大变化以及对过度控制努力的使用的惩罚。

在这里:

为机器人在X方向(向目标前进)的平移速度。

是机器人从目标直线轨迹的横向平移位移。

为机器人质心的标准化竖直平移位移。

是关节的扭矩我从上一步一步。

是环境的采样时间。

是环境的最终仿真时间。

创建环境接口

创建观察规范。

numobs = 29;ObsInfo = rlnumericspec([numobs 1]);ObsInfo.name =.“观察”;

创建动作规范。

numAct = 6;actInfo = rlNumericSpec([numAct 1],“LowerLimit”,-1,“UpperLimit”1);actInfo。Name ='foot_torque';

为行走机器人模型创建环境界面。

blk = [mdl,' / RL代理'];env = rl金宝appSimulinkEnv (mdl,黑色,obsInfo actInfo);env。ResetFcn = @(in) walkerResetFcn(in,upper_leg_length/100,lower_leg_length/100,h/100);

选择并创建培训代理

这个示例提供了使用DDPG或TD3代理来训练机器人的选项。要使用选择的代理模拟机器人,请设置鼓励相应的国旗。

Agentselection =.“TD3”;转变鼓励情况下“DDPG”代理= createdDpgagent(numobs,obsinfo,numact,actinfo,ts);情况下“TD3”代理= createTD3Agent (numObs obsInfo、numAct actInfo, Ts);除此以外DISP('为AgentSelection输入DDPG或TD3 ')结束

的createdDpgagent.和createTD3Agent辅助函数执行以下操作。

创建演员和评论家网络。

为参与者和评论家表示指定选项。

使用已创建的网络和指定的选项创建参与者和评论家表示。

配置特定于代理的选项。

创建代理。

DDPG代理

DDPG代理近似于使用批评价值函数表示,给定的长期奖励和操作。DDPG代理决定通过使用演员表示来考虑观察的行动。此示例的演员和批评网络是由[2]的启发。

有关创建DDPG代理的详细信息,请参阅createdDpgagent.helper函数。有关配置DDPG代理选项的信息,请参见rlDDPGAgentOptions。

有关创建深度神经网络值函数表示的更多信息,请参阅创建策略和值函数表示。有关为DDPG代理创建神经网络的示例,请参阅训练DDPG代理控制双集成商系统。

TD3代理

TD3代理使用2个评论值函数表示来近似给定的观察和行动的长期奖励。TD3代理决定使用参与者表示对给定的观察采取何种操作。该代理使用的行动者和批评网络的结构与DDPG代理使用的相同。

DDPG代理可能会高估Q值。由于这个Q值随后被用于更新代理的策略(参与者),因此产生的策略可能不是最优的,累积的训练错误可能导致不同的行为。TD3算法是DDPG的扩展,通过防止Q值[3]的高估使其更加鲁棒。

两个批评网络- TD3代理独立学习两个批评网络,并使用最小值函数估计更新参与者(策略)。这样做可以防止在后续步骤中积累错误和高估Q值。

添加目标策略噪声 - 剪辑噪声被添加到目标动作,以平滑Q函数值在类似的动作上。这样做可以防止学习错误的嘈杂值估计的尖锐峰值。

延迟策略和目标更新 - 对于TD3代理,建议延迟演员网络更新,因为它允许更多时间为Q函数减少错误(在更新策略之前减少错误(更接近所需的目标)。这样做可以防止价值估算的方差并导致更高的质量策略更新。

有关创建TD3代理的详细信息,请参阅createTD3Agenthelper函数。有关配置TD3代理选项的信息,请参阅rlTD3AgentOptions。

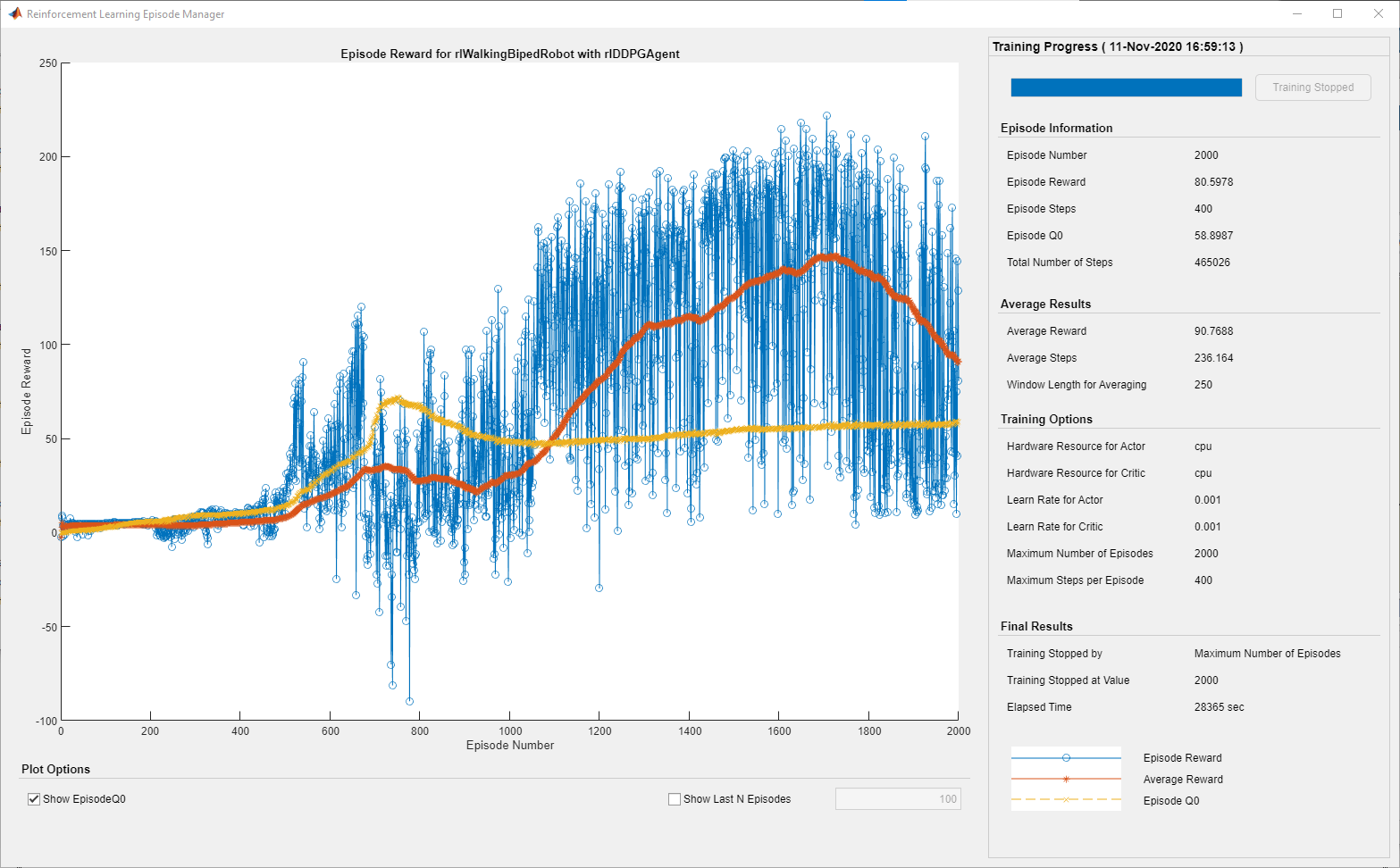

指定培训选项和火车代理

对于此示例,DDPG和TD3代理的培训选项是相同的。这些选项基于以下要求。

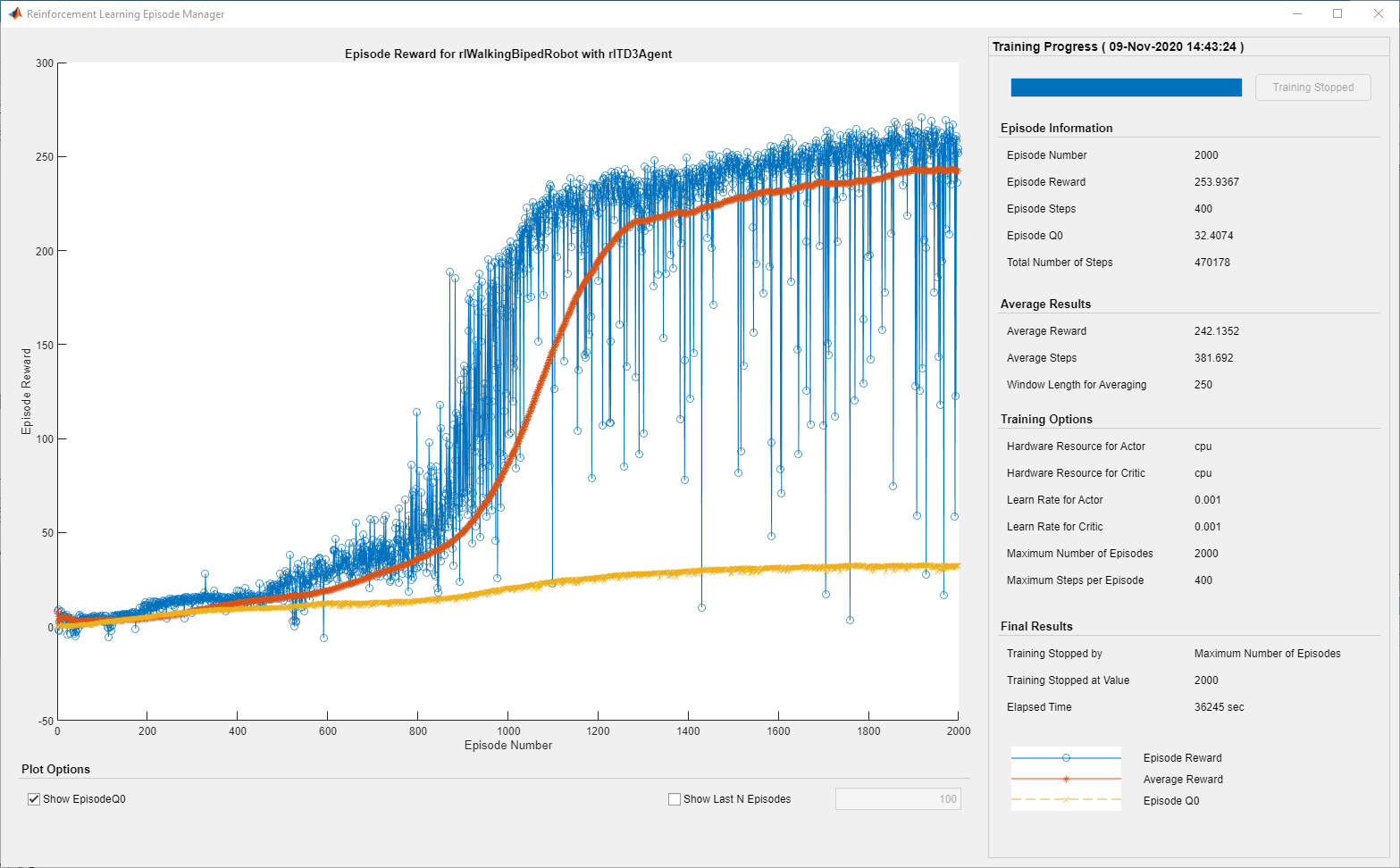

每次训练最多持续2000集

maxsteps.时间的步骤。在“章节管理器”对话框中显示培训进度(设置

情节选项),并禁用命令行显示(设置verb选项)。仅当达到最大集数时终止训练(

maxEpisodes)。这样做允许在整个训练会话中比较多个代理的学习曲线。

有关更多信息和其他选项,请参见rltringOptions.。

maxepisodes = 2000;maxsteps =地板(TF / TS);训练= rltrainingOptions(…'maxepisodes'maxEpisodes,…'maxstepperepisode',maxsteps,…“ScoreAveragingWindowLength”, 250,…“详细”,错误的,…“阴谋”,“训练进步”,…“StopTrainingCriteria”,“EpisodeCount”,…'stoptriningvalue'maxEpisodes,…“SaveAgentCriteria”,“EpisodeCount”,…“SaveAgentValue”,maxepisodes);

要并行地训练代理,请指定以下训练选项。并行训练需要并行计算工具箱™。如果没有安装并行计算工具箱软件,请设置UseParallel来假。

设置

UseParallel选择T.街。以并行异步方式训练代理。

每32步之后,让每个工作者向主机发送经验。DDPG和TD3代理要求工作人员将经验发送给主机。

训练.Useplate = true;训练.ParlellelizationOptions.Mode =.“异步”;trainOpts.ParallelizationOptions.StepsUntilDataIsSent = 32;trainOpts.ParallelizationOptions.DataToSendFromWorkers =“经验”;

使用该代理商培训火车功能。此过程是计算密集的,需要几个小时才能为每个代理完成。要在运行此示例的同时节省时间,请通过设置加载预制代理doTraining来假。训练代理人,套装doTraining来真的。由于并行训练的随机性,您可以从下面的图中期待不同的训练结果。预先训练的特工使用四名工作人员进行平行训练。

dotraining = false;如果doTraining%训练特工。Trainstats =火车(代理,env,训练);其他的%加载所选代理类型的预训练代理。如果Strcmp(Agentselection,“DDPG”)负载('rlwalkingbipedrebotddpg.mat',“代理”)其他的负载(“rlWalkingBipedRobotTD3.mat”,“代理”)结束结束

对于前面的示例训练曲线,DDPG和TD3代理的每个训练步骤的平均时间分别为0.11和0.12秒。TD3 Agent每步需要更多的培训时间,因为它更新了与用于DDPG的单个评论家相比的两个批评网络。

模拟训练有素的特工

修复随机发生器种子以进行再现性。

rng (0)

为了验证训练agent的性能,在双足机器人环境中进行仿真。有关代理模拟的更多信息,请参见RlsimulationOptions.和sim卡。

simoptions = rlsimulation选项('maxsteps',maxsteps);体验= SIM(ENV,Agent,SimOptions);

比较代理表现

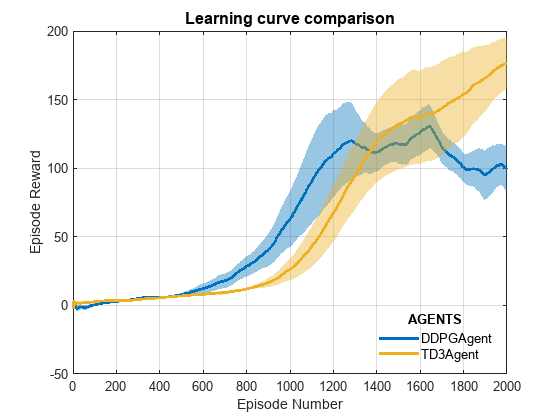

对于以下代理比较,每次使用不同的随机种子训练每次尝试五次。由于随机探测噪声和并行训练中的随机性,每个运行的学习曲线都不同。由于多次运行的代理训练需要几天时间来完成,因此这种比较使用预寄存代理。

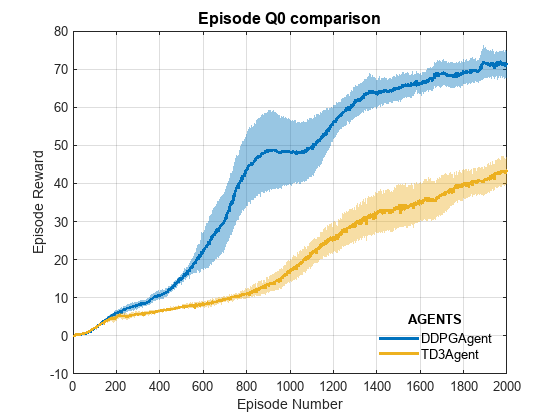

对于DDPG和TD3制剂,绘制情节奖励(顶部情节)和情节Q0值(底部情节)的平均值和标准差。章节Q0值是在每一章节开始时,根据对环境的初步观察对贴现的长期奖励的评论家估计。对于一个精心设计的评论家来说,情节Q0的价值接近于真正的贴现的长期回报。

comparePerformance (“DDPGAgent”,“TD3Agent”)

基于这一点学习曲线比较剧情:

DDPG似乎可以更快地接收学习(平均围绕第600次),但达到本地最小值。TD3开始较慢,但最终实现比DDPG更高的奖励,因为它避免了Q值的高估。

与DDPG相比,TD3制剂的学习曲线有稳步改善,说明其稳定性有所提高。

基于这一点集Q0比较剧情:

对于TD3代理,评论家估计的贴现长期报酬(2000集)比DDPG代理低。这是因为TD3算法在更新目标时采用了保守的方法,使用了两个Q函数的最小值。由于对目标的更新延迟,这种行为得到了进一步增强。

尽管对这2000例病例的TD3估计较低,但与DDPG不同,TD3制剂在病例Q0值方面显示出稳定的增加。

在这个例子中,训练在2000集就停止了。对于一个较大的训练周期,TD3代理随着其估计的稳步增加显示出向真正贴现的长期回报收敛的潜力。

有关如何培训DDPG代理在Simscape™MultiBody™中进行建模的人形机器人的另一个示例训练一个人形步行者(Simscape多体)。关于如何训练DDPG代理让四足机器人行走的例子使用DDPG代理的四足机器人机器人。

参考

[1] Heess,Nicolas,Dhruva TB,Srinivasan Sriram,Jay Lemmon,Josh Merel,Greg Wayne,Yuval Tassa,等。'富裕环境中运动行为的出现'。ArXiv: 1707.02286 (Cs),2017年7月10日。https://arxiv.org/abs/1707.02286。

[2] Lillicrap, Timothy P., Jonathan J. Hunt, Alexander Pritzel, Nicolas Heess, Tom Erez, Yuval Tassa, David Silver,和Daan Wierstra。“深度强化学习的连续控制”。ArXiv: 1509.02971 (Cs,统计)2019年7月5日。https://arxiv.org/abs/1509.02971。

Fujimoto, Scott, Herke van Hoof和David Meger。行动者-评论家方法中的寻址函数近似误差。arxiv:1802.09477 [CS,Stat], 2018年10月22日。https://arxiv.org/abs/1802.09477。