主要内容

政策和价值函数

定义策略和值函数表示,例如深神经网络和Q表

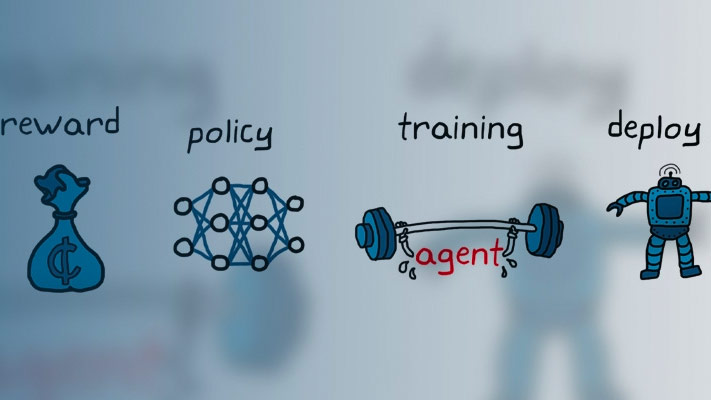

强化学习策略是一种映射,可以根据环境的观察选择要采取的操作。在培训期间,代理商调整其政策表示的参数,以最大限度地提高长期奖励。

强化学习工具箱™软件为演员和批评者提供的对象提供了对象。actor表示选择最佳采取行动的策略。批评者表示估计当前策略值的值函数。根据您的应用程序和选定的代理,您可以使用深神经网络,线性基本功能或查找表定义策略和值函数。有关更多信息,请参阅创建策略和值函数表示。