このページの翻訳は最新ではありません。ここをクリックして、英語の最新版を参照してください。

自動並列サポートを使用したクラウドでのネットワークの学習

この例では、並列学習用の MATLAB の自動サポートを使用して畳み込みニューラル ネットワークに学習させる方法を説明します。多くの場合、深層学習における学習には数時間または数日かかります。並列計算を使用すると、複数のグラフィックス処理装置 (GPU) をローカルで、またはクラウドのクラスターで使用して、学習を高速化できます。複数の GPU があるマシンにアクセスできる場合は、データのローカル コピーに対してこの例を完了させることができます。より多くのリソースを使用する必要がある場合は、深層学習における学習をクラウドにスケールアップできます。並列学習のオプションの詳細は、並列およびクラウドでの深層学習のスケールアップを参照してください。この例では、MATLAB の自動並列サポートを使用して、クラウドのクラスターで深層学習ネットワークに学習させる手順について順を追って説明します。

要件

例を実行する前に、クラスターを構成し、データをクラウドにアップロードする必要があります。MATLAB では、MATLAB デスクトップから直接、クラウドにクラスターを作成できます。[ホーム]タブの[並列]メニューで、[クラスターの作成と管理]を選択します。クラスター プロファイル マネージャーで、[クラウド クラスターの作成]をクリックします。または、MathWorks Cloud Center を使用して計算クラスターを作成し、そのクラスターにアクセスすることもできます。詳細については、Getting Started with Cloud Centerを参照してください。その後、データを Amazon S3 バケットにアップロードして、MATLAB から直接アクセスします。この例では、Amazon S3 に既に格納されている CIFAR-10 データセットのコピーを使用します。手順については、クラウドへの深層学習データのアップロードを参照してください。

並列プールの設定

クラスターの並列プールを起動して、ワーカー数をクラスターの GPU 数に設定します。GPU より多くのワーカーを指定した場合、残りのワーカーはアイドル状態になります。この例では、使用するクラスターが既定のクラスター プロファイルとして設定されていると仮定します。MATLAB の[ホーム]タブの[並列]、[既定のクラスターの選択]で、既定のクラスター プロファイルを確認します。

numberOfWorkers = 8; parpool(numberOfWorkers);

Starting parallel pool (parpool) using the 'MyClusterInTheCloud' profile ... connected to 8 workers.

クラウドからのデータセットの読み込み

imageDatastoreを使用して、学習データセットとテスト データセットをクラウドから読み込みます。この例では、Amazon S3 に格納されている CIFAR-10 データセットのコピーを使用します。ワーカーがクラウドのデータストアに確実にアクセスできるように、AWS 資格情報の環境変数が正しく設定されていることを確認してください。クラウドへの深層学習データのアップロードを参照してください。

imdsTrain = imageDatastore('s3://cifar10cloud/cifar10/train',...'IncludeSubfolders',true,...'LabelSource','foldernames'); imdsTest = imageDatastore('s3://cifar10cloud/cifar10/test',...'IncludeSubfolders',true,...'LabelSource','foldernames');

augmentedImageDatastoreオブジェクトを作成し、拡張イメージ データを使用してネットワークに学習させます。ランダムな平行移動と水平方向の反転を使用します。データ拡張は、ネットワークで過適合が発生したり、学習イメージの正確な詳細が記憶されたりすることを防止するのに役立ちます。

imageSize = [32 32 3]; pixelRange = [-4 4]; imageAugmenter = imageDataAugmenter(...'RandXReflection',true,...'RandXTranslation',pixelRange,...'RandYTranslation',pixelRange); augmentedImdsTrain = augmentedImageDatastore(imageSize,imdsTrain,...'DataAugmentation',imageAugmenter,...'OutputSizeMode','randcrop');

ネットワーク アーキテクチャと学習オプションの定義

CIFAR-10 データセット用のネットワーク アーキテクチャを定義します。コードを簡略化するために、入力を畳み込む畳み込みブロックを使用します。プーリング層は空間次元をダウンサンプリングします。

blockDepth = 4;% blockDepth controls the depth of a convolutional blocknetWidth = 32;% netWidth controls the number of filters in a convolutional blocklayers = [ imageInputLayer(imageSize) convolutionalBlock(netWidth,blockDepth) maxPooling2dLayer(2,'Stride',2) convolutionalBlock(2*netWidth,blockDepth) maxPooling2dLayer(2,'Stride',2) convolutionalBlock(4*netWidth,blockDepth) averagePooling2dLayer(8) fullyConnectedLayer(10) softmaxLayer classificationLayer ];

学習オプションを定義します。実行環境をparallelに設定して、現在のクラスターを使用してネットワークの並列学習を行います。複数の GPU を使用する場合、利用可能な計算リソースを増やします。GPU の数でミニバッチ サイズをスケールアップし、各 GPU での作業負荷を一定に維持します。ミニバッチ サイズに応じて学習率をスケーリングします。学習率のスケジュールを使用して、学習の進行に応じて学習率を下げます。学習の進行状況プロットをオンにして、学習中に、可視化されたフィードバックを取得します。

miniBatchSize = 256 * numberOfWorkers; initialLearnRate = 1e-1 * miniBatchSize/256; options = trainingOptions('sgdm',...'ExecutionEnvironment','parallel',...% Turn on automatic parallel support.'InitialLearnRate',initialLearnRate,...% Set the initial learning rate.'MiniBatchSize',miniBatchSize,...% Set the MiniBatchSize.'Verbose',false,...% Do not send command line output.“阴谋”,'training-progress',...% Turn on the training progress plot.'L2Regularization',1e-10,...“MaxEpochs”,50,...'Shuffle','every-epoch',...'ValidationData',imdsTest,...'ValidationFrequency',floor(numel(imdsTrain.Files)/miniBatchSize),...'LearnRateSchedule','piecewise',...'LearnRateDropFactor',0.1,...'LearnRateDropPeriod',45);

ネットワークの学習と分類での使用

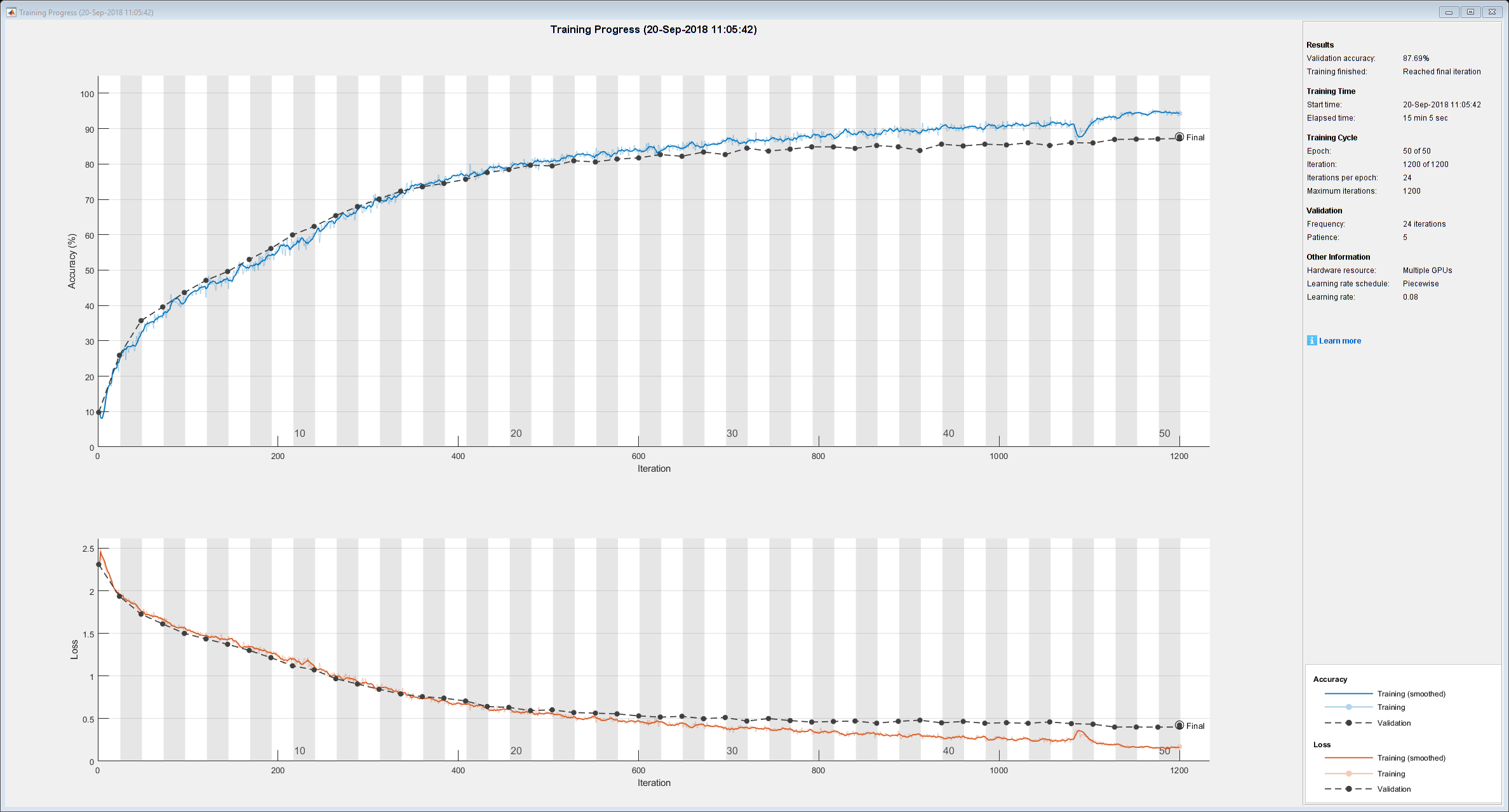

クラスターでネットワークに学習させます。学習中に進行状況のプロットが表示されます。

net = trainNetwork(augmentedImdsTrain,layers,options)

net = SeriesNetwork with properties: Layers: [43×1 nnet.cnn.layer.Layer]

学習済みネットワークを使用してローカル マシン上でテスト イメージを分類し、ネットワークの精度を判断します。次に、予測ラベルを実際のラベルと比較します。

YPredicted = classify(net,imdsTest); accuracy = sum(YPredicted == imdsTest.Labels)/numel(imdsTest.Labels)

補助関数の定義

ネットワーク アーキテクチャで畳み込みブロックを作成する関数を定義します。

functionlayers = convolutionalBlock(numFilters,numConvLayers) layers = [ convolution2dLayer(3,numFilters,'Padding','same') batchNormalizationLayer reluLayer ]; layers = repmat(layers,numConvLayers,1);end

参考

trainNetwork|trainingOptions|imageDatastore