主要内容

rlDQNAgent

深度q -网络强化学习代理

描述

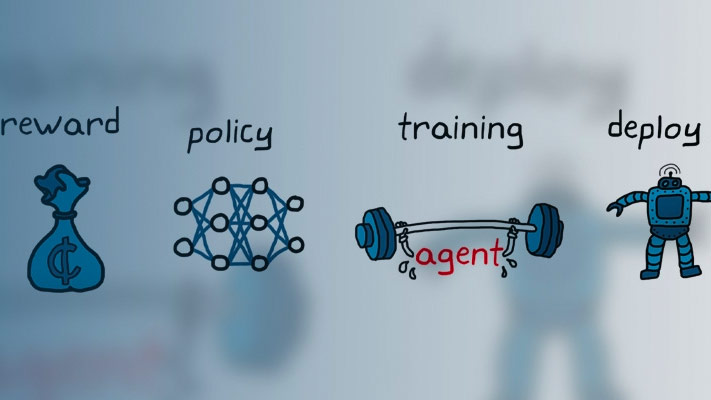

深度q -网络(deep Q-network, DQN)算法是一种无模型、在线、非策略强化学习方法。DQN代理是一种基于价值的强化学习代理,它训练评论家来估计回报或未来的奖励。DQN是q学习的一种变体,它只在离散的动作空间中起作用。

创建

语法

描述

根据观察和行动规格创建代理

代理= rlDQNAgent (observationInfo,actionInfo)observationInfo以及动作规范actionInfo.

代理= rlDQNAgent (observationInfo,actionInfo,initOpts)initOpts对象。有关初始化选项的详细信息,请参见rlAgentInitializationOptions.

从评论家表示创建代理

代理= rlDQNAgent (评论家)

指定代理选项

代理= rlDQNAgent (评论家,agentOptions)AgentOptions属性agentOptions输入参数。在前面语法中的任何输入参数后使用此语法。

输入参数

属性

对象的功能

例子

在R2019a中引入