rlPPOAgent

近端策略优化强化学习代理

描述

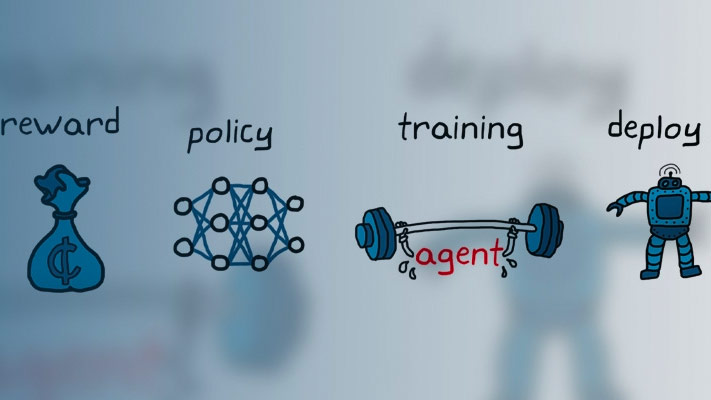

近端策略优化(Proximal policy optimization, PPO)是一种无模型、在线、策略上、策略梯度强化学习方法。该算法在通过环境相互作用采样数据和使用随机梯度下降优化剪辑代理目标函数之间进行交替。动作空间可以是离散的,也可以是连续的。

创建

语法

描述

根据观察和行动规格创建代理

代理= rlPPOAgent (observationInfo,actionInfo)observationInfo以及动作规范actionInfo.

代理= rlPPOAgent (observationInfo,actionInfo,initOpts)initOpts对象。行动者-评论家代理不支持循环神经网络。金宝app有关初始化选项的详细信息,请参见rlAgentInitializationOptions.

指定代理选项

代理= rlPPOAgent (___,agentOptions)agentOptions输入参数。在前面语法中的任何输入参数之后使用此语法。

输入参数

属性

对象的功能

例子

提示

对于连续操作空间,此代理不强制操作规范设置的约束。在这种情况下,必须在环境中强制执行操作空间约束。

对于PPO智能体,调优行为体网络的学习率是必要的,而对于TRPO智能体,则不需要调优。

另请参阅

rlAgentInitializationOptions|rlPPOAgentOptions|rlStochasticActorRepresentation|rlValueRepresentation|深度网络设计器