强化学习工具箱

使用强化学习设计和培训政策

Reinforcement Learning Toolbox™提供了一个应用程序、函数和Simulink金宝app®block用于使用强化学习算法的训练策略,包括DQN、PPO、SAC和DDPG。您可以使用这些策略为复杂的应用程序(如资源分配、机器人和自治系统)实现控制器和决策算法。

这个工具箱允许您使用深度神经网络或查询表来表示策略和值函数,并通过与MATLAB中建模的环境进行交互来训练它们®或仿真金宝app软件。您可以评估工具箱中提供的单或多智能体强化学习算法,或开发自己的算法。您可以试验超参数设置,监控训练进度,并通过应用程序交互或编程模拟训练过的代理。为了提高训练性能,模拟可以在多个cpu、gpu、计算机集群和云上并行运行(使用并行计算工具箱™和MATLAB并行服务器™)。

通过ONNX™模型格式,现有的策略可以从深度学习框架导入,如TensorFlow™Keras和PyTorch(使用深度学习工具箱™)。你可以生成优化的C, c++和CUDA®代码在微控制器和gpu上部署经过培训的政策。工具箱包括参考示例,以帮助您开始。

开始:

Simulink中的单agent和多agent强化学习金宝app

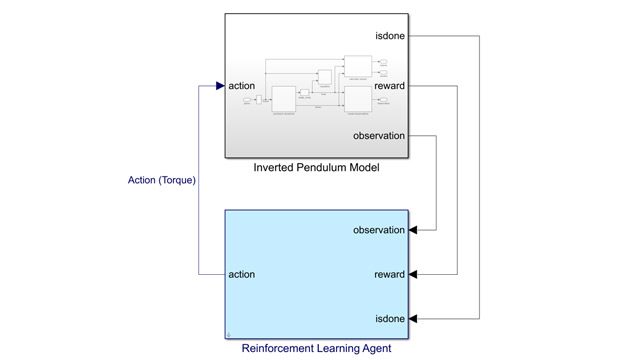

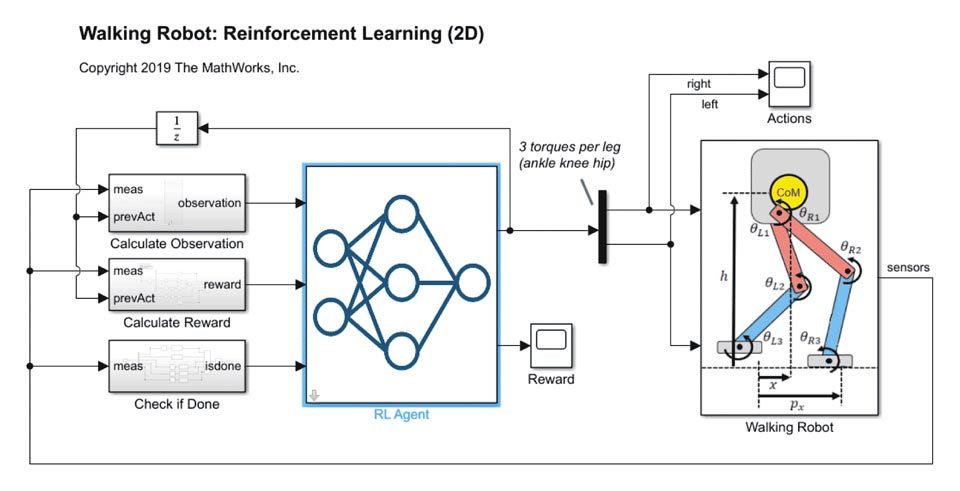

在Simulink中用RL代理块创建和训练强化学习代理。金宝app在Simulink中使用RL Agent块的多个实例同时训练多个Agent (multi-agent reinforcement learning)。金宝app

金宝appSimulink和Simscape环境

使用Si金宝appmulink和Simscape™创建环境的模型。在模型中指定观察、行动和奖励信号。

MATLAB环境中

使用MATLAB函数和类来建模环境。在MATLAB文件中指定观察,行动和奖励变量。

分布式计算和多核加速

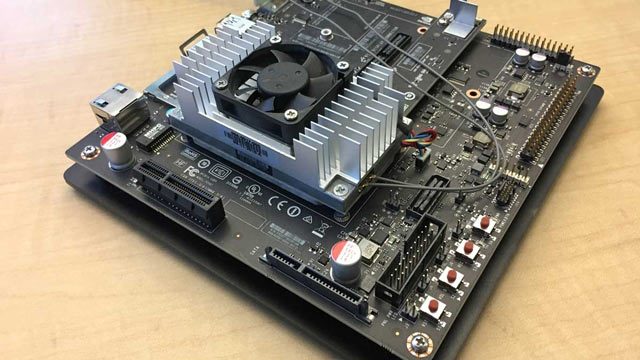

通过在多核计算机、云资源或计算集群上运行并行模拟来加速训练并行计算工具箱和MATLAB并行服务器.

GPU加速

使用高性能NVIDIA加速深度神经网络训练和推理®gpu。使用MATLAB并行计算工具箱以及大多数支持cuda的NVIDIA gpu计算能力3.0及以上.

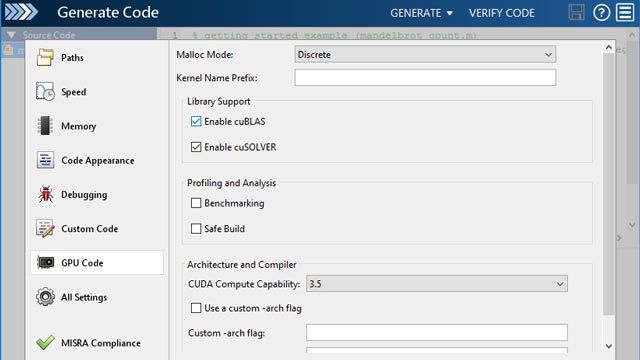

代码生成

使用GPU编码器™从代表训练过的策略的MATLAB代码生成优化的CUDA代码。使用MATLAB编码器™生成C/ c++代码来部署策略。

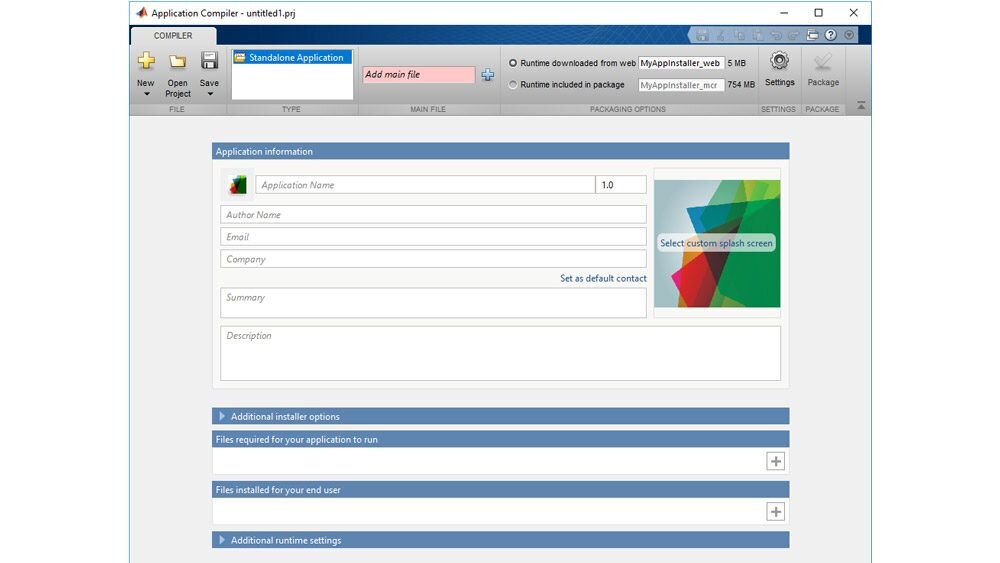

MATLAB编译器支持金宝app

使用MATLAB编译器™和MATLAB编译器SDK™将经过培训的策略部署为独立应用程序、C/ c++共享库、Microsoft®net程序集,Java®Python类,®包。

开始

了解如何为一些问题开发强化学习策略,如倒转一个简单的钟摆,导航一个网格世界,平衡一个车杆系统,以及解决一般的马尔可夫决策过程。

自动驾驶

为自动驾驶应用设计强化学习策略,如自适应巡航控制、车道保持辅助和自动停车。

产品资源:

强化学习视频系列

观看这个系列的视频来学习更多关于强化学习的知识。