主要内容

rlValueRepresentation

强化学习主体的价值函数批判表示

描述

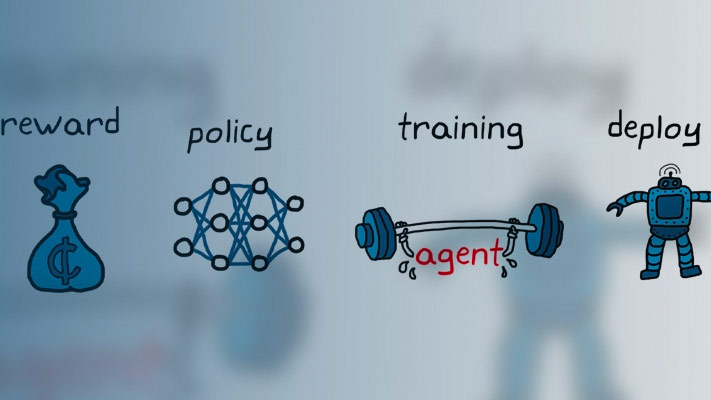

该对象实现了一个值函数近似剂,以在加强学习代理中用作批评者。值函数是将观察到标量值映射的函数。输出代表代理从给定观察开始时的预期总长期奖励,并采取最佳动作。因此,价值函数批评只需要观察(但不是动作)作为输入。创建一个rlValueRepresentation批评家,使用它创建依赖于值函数批评家的代理,例如rlACAgent,rlPGAgent,或RLP发泡剂。有关此工作流的示例,请参阅创建演员和批评者表示.有关创建表示的更多信息,请参见创建策略和价值功能表示.

创建

语法

描述

评论家=rlValueRepresentation(___,选项)评论家使用附加选项集选项,这是一个rlRepresentationOptions对象。该语法设置选项性质评论家到选项输入参数。您可以将此语法与前面的任何输入参数组合一起使用。

输入参数

属性

例子

在R2020a中引入