rlsarsaagent.

Sarsa加强学习代理

描述

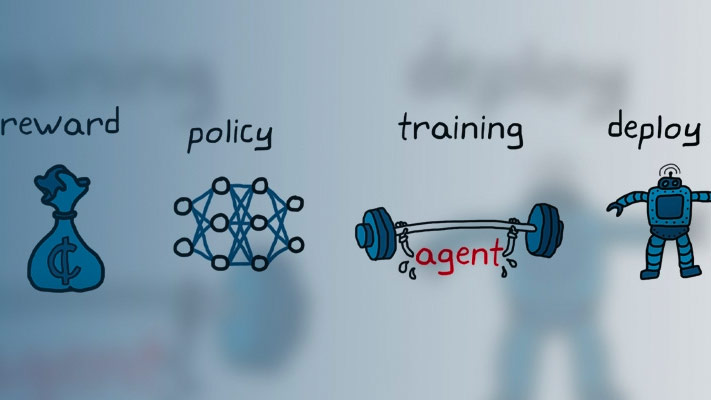

Sarsa算法是一种无模型,在线,策略的on-prodice强化学习方法。萨拉代表是一家基于价值的强化学习代理,批评了批评奖励或未来奖励。

有关Sarsa代理商的更多信息,请参阅萨拉代表。

有关不同类型的强化学习代理商的更多信息,请参阅加固学习代理人。

创建

输入参数

特性

对象功能

火车 |

在指定环境中列车加固学习代理 |

SIM |

Simulate trained reinforcement learning agents within specified environment |

努力 |

从代理商或演员代表获取行动给定环境观察 |

工作者 |

获取钢筋学习代理人的演员代表 |

setActor. |

Set actor representation of reinforcement learning agent |

克里克里条件 |

从加强学习代理获得批评批评意见 |

setcritic. |

设定批评钢筋学习代理人的代表 |

生成policyfunction. |

Create function that evaluates trained policy of reinforcement learning agent |

例子

在R2019A引入