主要内容

rlMDPEnv

为强化学习创建马尔可夫决策过程环境

描述

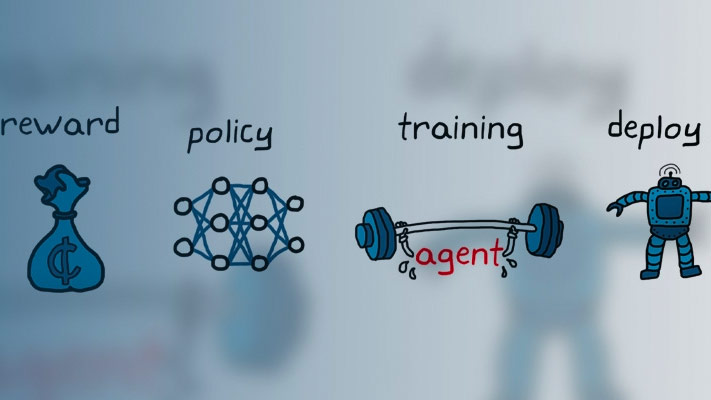

马尔可夫决策过程(MDP)是离散时间随机控制过程。它提供了一种用于在结果部分随机且部分在决策者的控制下的情况下建模决策的数学框架。MDP可用于研究使用加强学习解决的优化问题。用rlMDPEnv在Matlab中创建Markov决策过程中的强化学习®。

特性

对象功能

getActionInfo. |

从强化学习环境或代理获取行动数据规范 |

getObservationInfo |

从强化学习环境或agent获取观测数据规范 |

SIM |

在指定的环境中模拟训练过的强化学习代理 |

火车 |

在指定环境中列车加固学习代理 |

验证环境 |

验证定制增强学习环境 |

例子

在R2019A引入