이 번역 페이지는 최신 내용을 담고 있지 않습니다. 최신 내용을 영문으로 보려면 여기를 클릭하십시오.

장단기기억신경망GydF4y2Ba

이 항목에서는 장단기 기억(LSTM) 신경망을 사용하여 분류 및 회귀 작업에 대해 시퀀스 및 시계열 데이터로 작업하는 방법을 설명합니다. LSTM 신경망을 사용하여 시퀀스 데이터를 분류하는 방법을 보여주는 예제는딥러닝을 사용한 시퀀스 분류항목을 참조하십시오.

lstm신경망은데이터의스텝간장기종속성을학습수수있는(rnn)의의입니다입니다입니다입니다。GydF4y2Ba

LSTM신경망아키텍처GydF4y2Ba

lstm신경망핵심구성는시퀀스입력입력과과과계층계층입니다입니다。GydF4y2Ba시퀀스 입력 계층은 신경망에 시퀀스 또는 시계열 데이터를 입력합니다.LSTM계층GydF4y2Ba은시퀀스시간간의장기을합니다합니다합니다。GydF4y2Ba

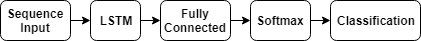

다음 도식은 분류를 위한 간단한 LSTM 신경망의 아키텍처를 보여줍니다. 이 신경망은 시퀀스 입력 계층으로 시작하고, 그 뒤에 LSTM 계층이 옵니다. 클래스 레이블을 예측하기 위해, 신경망의 끝부분에는 완전 연결 계층, 소프트맥스 계층, 분류 출력 계층이 옵니다.

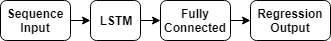

lastm신경망신경망신경망신경망의아키텍처를줍니다줍니다줍니다줍니다줍니다줍니다줍니다줍니다이신경망은계층으로하고하고하고,lstm계층옵니다옵니다옵니다。신경망의에는연결계층과출력이옵니다옵니다옵니다。GydF4y2Ba

다음 도식은 비디오 분류를 위한 신경망의 아키텍처를 보여줍니다. 신경망에 영상 시퀀스를 입력하려면 시퀀스 입력 계층을 사용하십시오. 특징 추출을 위해 컨벌루션 계층을 사용하려면, 즉 비디오의 각 프레임에 독립적으로 컨벌루션 연산을 적용하려면, 시퀀스 접기 계층 뒤에 컨벌루션 계층을 사용하고, 그 뒤에 시퀀스 펼치기 계층을 사용하십시오. 벡터로 구성된 시퀀스에서 학습하도록 LSTM 계층을 사용하려면 평탄화 계층 뒤에 LSTM 계층과 출력 계층을 사용하십시오.

분류 LSTM 신경망

sequence-to-label 분류를 위한 LSTM 신경망을 만들려면 시퀀스 입력 계층, LSTM 계층, 완전 연결 계층, 소프트맥스 계층, 분류 출력 계층을 포함하는 계층 배열을 만듭니다.

시퀀스 입력 계층의 크기를 입력 데이터의 특징 개수로 설정합니다. 완전 연결 계층의 크기를 클래스 개수로 설정합니다. 시퀀스 길이는 지정할 필요가 없습니다.

LSTM계층의 경우, 은닉 유닛의 개수와 출력 모드'最后的'GydF4y2Ba를지정합니다.

数字= 12;numHiddenUnits = 100; numClasses = 9; layers = [。。。GydF4y2BasequenceInputlayer(numfeatures)lstmlayer(numhiddenunits,GydF4y2Ba'OutputMode',,,,GydF4y2Ba'最后的'GydF4y2Ba)完整连接的layerer(numClasses)softmaxlayer classificationlayer];GydF4y2Ba

序列到标签的lastm신경망신경망신경망새데이터하는방법을보여는는는는는GydF4y2Ba딥러닝을 사용한 시퀀스 분류항목을 참조하십시오.

sequence-to-sequence분류를위한LSTM신경망을만들려면层层序e-to-label 분류와 동일한 아키텍처를 사용하되 LSTM 계층의 출력 모드를'序列'GydF4y2Ba로 설정합니다.

数字= 12;numHiddenUnits = 100; numClasses = 9; layers = [。。。GydF4y2BasequenceInputlayer(numfeatures)lstmlayer(numhiddenunits,GydF4y2Ba'OutputMode',,,,GydF4y2Ba'序列'GydF4y2Ba)完整连接的layerer(numClasses)softmaxlayer classificationlayer];GydF4y2Ba

lstm신경망GydF4y2Ba

序列到ONE的lastm신경망신경망을시퀀스,lstm계층,lstm계층,완전연결,회귀계층,회귀회귀계층을포함하는계층을만듭니다만듭니다만듭니다。GydF4y2Ba

시퀀스 입력 계층의 크기를 입력 데이터의 특징 개수로 설정합니다. 완전 연결 계층의 크기를 응답 변수의 개수로 설정합니다. 시퀀스 길이는 지정할 필요가 없습니다.

LSTM계층의 경우, 은닉 유닛의 개수와 출력 모드'最后的'GydF4y2Ba를지정합니다.

数字= 12;numhidendunits = 125;numRespons = 1;层= [GydF4y2Ba。。。GydF4y2BasequenceInputlayer(numfeatures)lstmlayer(numhiddenunits,GydF4y2Ba'OutputMode',,,,GydF4y2Ba'最后的'GydF4y2Ba)完整连接的layerer(numRespons)回归层];GydF4y2Ba

序列到序列的lstm신경망신경망을을만들려면만들려면만들려면만들려면만들려면회귀회귀한아키텍처를를하되하되하되하되하되하되하되계층계층를를GydF4y2Ba'序列'GydF4y2Ba로 설정합니다.

数字= 12;numhidendunits = 125;numRespons = 1;层= [GydF4y2Ba。。。GydF4y2BasequenceInputlayer(numfeatures)lstmlayer(numhiddenunits,GydF4y2Ba'OutputMode',,,,GydF4y2Ba'序列'GydF4y2Ba)完整连接的layerer(numRespons)回归层];GydF4y2Ba

sequence-to-sequence 회귀를 위한 LSTM 신경망을 훈련시키고 새 데이터에 대해 예측하는 방법을 보여주는 예제는딥러닝을 사용한 sequence-to-sequence 회귀항목을 참조하십시오.

비디오분류신경망GydF4y2Ba

비디오 데이터나 의료 영상과 같이 영상으로 구성된 시퀀스를 포함하는 데이터를 위한 딥러닝 신경망을 만들려면 시퀀스 입력 계층을 사용하여 영상 시퀀스 입력값을 지정합니다.

특징 추출을 위해 컨벌루션 계층을 사용하려면, 즉 비디오의 각 프레임에 독립적으로 컨벌루션 연산을 적용하려면, 시퀀스 접기 계층 뒤에 컨벌루션 계층을 사용하고, 그 뒤에 시퀀스 펼치기 계층을 사용하십시오. 벡터로 구성된 시퀀스에서 학습하도록 LSTM 계층을 사용하려면 평탄화 계층 뒤에 LSTM 계층과 출력 계층을 사용하십시오.

一世nputSize = [28 28 1]; filterSize = 5; numFilters = 20; numHiddenUnits = 200; numClasses = 10; layers = [。。。GydF4y2BasequenceInputlayer(Inputsize,GydF4y2Ba'姓名'GydF4y2Ba,,,,GydF4y2Ba'输入'GydF4y2Ba)序列折叠layerer((GydF4y2Ba'姓名'GydF4y2Ba,,,,GydF4y2Ba'折叠'GydF4y2Ba)Convolution2dLayer(filterSize,numFilters,'姓名'GydF4y2Ba,,,,GydF4y2Ba'conv')batchNormalizationLayer('姓名'GydF4y2Ba,,,,GydF4y2Ba'bn')relulayer(GydF4y2Ba'姓名'GydF4y2Ba,,,,GydF4y2Ba'relu')sequenceunfoldinglayer((GydF4y2Ba'姓名'GydF4y2Ba,,,,GydF4y2Ba'展开'GydF4y2Ba)flattenlayer((GydF4y2Ba'姓名'GydF4y2Ba,,,,GydF4y2Ba“扁平”GydF4y2Ba)lstmLayer(numHiddenUnits,'OutputMode',,,,GydF4y2Ba'最后的'GydF4y2Ba,,,,GydF4y2Ba'姓名'GydF4y2Ba,,,,GydF4y2Ba'lstm')完整连接的layerer(numClasses,GydF4y2Ba'姓名'GydF4y2Ba,,,,GydF4y2Ba'FC'GydF4y2Ba)SoftMaxlayer(GydF4y2Ba'姓名'GydF4y2Ba,,,,GydF4y2Ba'softmax')分类器(GydF4y2Ba'姓名'GydF4y2Ba,,,,GydF4y2Ba'classification');GydF4y2Ba

계층을 계층 그래프로 변환하고, 시퀀스 접기 계층의MinibatchSizeGydF4y2Ba출력값을 시퀀스 펼치기 계층의 대응되는 입력값에 연결합니다.

lgraph = layerGraph(layers); lgraph = connectLayers(lgraph,'折/minibatchsize'GydF4y2Ba,,,,GydF4y2Ba'unfold/miniBatchSize');GydF4y2Ba

딥러닝신경망비디오를훈련시키는방법보여주는예제는GydF4y2Ba딥러닝을 사용하여 비디오 분류하기항목을 참조하십시오.

lstm신경망GydF4y2Ba

lstm계층앞출력모드가GydF4y2Ba'序列'GydF4y2Ba인 LSTM 계층을 추가로 삽입하여 LSTM 신경망의 심도를 높일 수 있습니다. 과적합을 방지하기 위해 LSTM 계층 뒤에 드롭아웃 계층을 삽입할 수 있습니다.

序列到标签분류신경망경우,lstm계층계층모드가모드가모드가GydF4y2Ba'最后的'GydF4y2Ba가 되어야 합니다.

数字= 12;numHiddenUnits1 = 125; numHiddenUnits2 = 100; numClasses = 9; layers = [。。。GydF4y2BasequenceInputLayer(numFeatures) lstmLayer(numHiddenUnits1,'OutputMode',,,,GydF4y2Ba'序列'GydF4y2Ba)dropoutlayer(0.2)lstmlayer(numhiddenunits2,GydF4y2Ba'OutputMode',,,,GydF4y2Ba'最后的'GydF4y2Ba)dropoutlayer(0.2)plullconnectedlayer(numClasses)softmaxlayer classificationlayer];GydF4y2Ba

序列到序列분류신경망경우,lstm계층계층모드가모드가GydF4y2Ba'序列'GydF4y2Ba가 되어야 합니다.

数字= 12;numHiddenUnits1 = 125; numHiddenUnits2 = 100; numClasses = 9; layers = [。。。GydF4y2BasequenceInputLayer(numFeatures) lstmLayer(numHiddenUnits1,'OutputMode',,,,GydF4y2Ba'序列'GydF4y2Ba)dropoutlayer(0.2)lstmlayer(numhiddenunits2,GydF4y2Ba'OutputMode',,,,GydF4y2Ba'序列'GydF4y2Ba)dropoutlayer(0.2)plullconnectedlayer(numClasses)softmaxlayer classificationlayer];GydF4y2Ba

계층

| 계층 | 설명 |

|---|---|

| 시퀀스입력신경망시퀀스데이터입력합니다합니다。GydF4y2Ba | |

| lstm계층시계열및데이터시간간의종속성합니다합니다합니다합니다。GydF4y2Ba | |

| BiLSTM(양방향 장단기 기억) 계층은 시계열 또는 시퀀스 데이터의 시간 스텝 간의 양방향 장기 종속성을 학습합니다. 이러한 종속성은 신경망이 각 시간 스텝에서 전체 시계열로부터 학습하도록 하려는 경우에 유용할 수 있습니다. | |

| gru계층시계열시퀀스에서시간간종속성을합니다합니다합니다。GydF4y2Ba | |

| 1차원 컨벌루션 계층은 1차원 입력값에 슬라이딩 컨벌루션 필터를 적용합니다. | |

| 1차원 최댓값 풀링 계층은 입력값을 1차원 풀링 영역으로 나누어 다운샘플링을 수행한 다음 각 영역의 최댓값 계산을 수행합니다. | |

| 1차원 평균값 풀링 계층은 입력값을 1차원 풀링 영역으로 나누어 다운샘플링을 수행한 다음 각 영역의 평균값 계산을 수행합니다. | |

| 1차원 전역 최댓값 풀링 계층은 입력값의 시간 또는 공간 차원의 최댓값을 출력하여 다운샘플링을 수행합니다. | |

| 시퀀스접기영상배치영상영상합니다합니다합니다。영상시퀀스스텝대해적으로연산수행하려는경우시퀀스접기계층을하십시오하십시오하십시오。GydF4y2Ba | |

| 시퀀스 펼치기 계층은 시퀀스 접기 후에 입력 데이터의 시퀀스 구조를 복원합니다. | |

| 평탄화 계층은 입력값의 공간 차원을 채널 차원으로 축소합니다. | |

|

단어임베딩단어인덱스벡터로합니다합니다합니다。GydF4y2Ba |

분류,예측예측전망GydF4y2Ba

새로운 데이터를 분류하거나 데이터에 대해 예측을 수행하려면Classify와predict를사용하십시오.

LSTM 신경망은 각 예측 사이의 신경망 상태를 기억할 수 있습니다. 신경망 상태는 전체 시계열을 미리 갖고 있지 않거나 긴 시계열에 대해 여러 예측을 수행하려는 경우에 유용합니다.

시계열의을예측분류하고신경망를하려면하려면하려면GydF4y2BapredictAndUpdateState와ClassifyAndUpdateState를사용하십시오. 각 예측 사이의 신경망 상태를 재설정하려면resetState를사용하십시오.

시퀀스의의스텝전망하는방법보여주는예제는GydF4y2Ba딥러닝을사용시계열전망GydF4y2Ba항목을 참조하십시오.

시퀀스,자르기자르기분할GydF4y2Ba

lstm신경망은한길이갖는입력를합니다합니다합니다。신경망에통과각미니배치모든시퀀스지정된길이를갖도록시퀀스시퀀스가가,잘리거나,잘리거나,분할。GydF4y2Ba训练GydF4y2Ba의序列长度GydF4y2Ba및GydF4y2BaSequencePaddingValue이름-값 쌍 인수를 사용하여 시퀀스 길이와 시퀀스를 채우는 데 사용되는 값을 지정할 수 있습니다.

신경망을 훈련시킨 후에는Classify,,,,GydF4y2Bapredict,,,,GydF4y2BaClassifyAndUpdateState,,,,GydF4y2BapredictAndUpdateState및GydF4y2Baactivations함수를때한미니배치와옵션을사용하십시오하십시오。GydF4y2Ba

시퀀스를길이로하기GydF4y2Ba

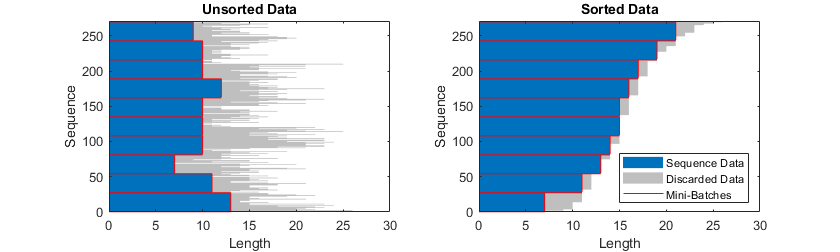

시퀀스를를사용되는양이나데이터를시퀀스길이를를기준으로데이터데이터를보십시오보십시오보십시오。시퀀스길이기준으로를정렬하려면먼저GydF4y2BaCellfun을사용하여시퀀스에GydF4y2Basize(X,2)를적용하여 각 시퀀스의 열 개수를 가져옵니다. 그런 다음种类GydF4y2Ba를사용를정렬하고하고하고하고하고출력을사용원래원래시퀀스를합니다합니다합니다합니다。GydF4y2Ba

sequenceLengths = CellFun(@(x)大小(x,2),xtrain);[sequenceLengthsSorted,idx] = sort(sequenceLengths);Xtrain = Xtrain(idx);GydF4y2Ba

다음 그림은 정렬된 데이터와 정렬되지 않은 데이터의 시퀀스 길이를 막대 차트로 보여줍니다.

시퀀스 채우기

시퀀스 길이를'longest'로지정배치모든시퀀스미니배치있는가장긴시퀀스와동일한길이길이를를갖도록소프트웨어소프트웨어가시퀀스를를채웁니다채웁니다채웁니다。이는디폴트입니다。GydF4y2Ba

다음 그림은“序列长度”GydF4y2Ba를GydF4y2Ba'longest'로설정효과보여줍니다。GydF4y2Ba

시퀀스자르기GydF4y2Ba

시퀀스 길이를'shortest'로지정배치모든시퀀스미니배치있는가장짧은시퀀스와동일한길이길이를를갖도록소프트웨어소프트웨어가시퀀스를를자릅니다자릅니다자릅니다。시퀀스의데이터버려집니다버려집니다。GydF4y2Ba

다음 그림은“序列长度”GydF4y2Ba를GydF4y2Ba'shortest'로설정효과보여줍니다。GydF4y2Ba

시퀀스 분할하기

시퀀스 길이를 정수 값으로 설정하면 소프트웨어가 미니 배치의 모든 시퀀스를 미니 배치에 있는 가장 긴 시퀀스 길이보다 큰, 지정된 길이의 가장 가까운 배수로 채웁니다. 그런 다음 소프트웨어가 각 시퀀스를 지정된 길이의 더 작은 시퀀스로 분할합니다. 분할이 이루어지면 소프트웨어가 미니 배치를 추가로 만듭니다.

전체 시퀀스가 메모리에 맞지 않으면 이 옵션을 사용하십시오. 또는训练GydF4y2Ba의'MiniBatchSize'옵션을더으로하여미니배치당개수줄여보십시오보십시오보십시오。GydF4y2Ba

시퀀스 길이를 양의 정수로 지정하면 소프트웨어가 이 작은 크기의 시퀀스를 연속적인 반복을 통해 처리합니다. 신경망은 분할된 시퀀스 사이에서 신경망 상태를 업데이트합니다.

다음 그림은“序列长度”GydF4y2Ba5로설정효과줍니다줍니다줍니다。GydF4y2Ba

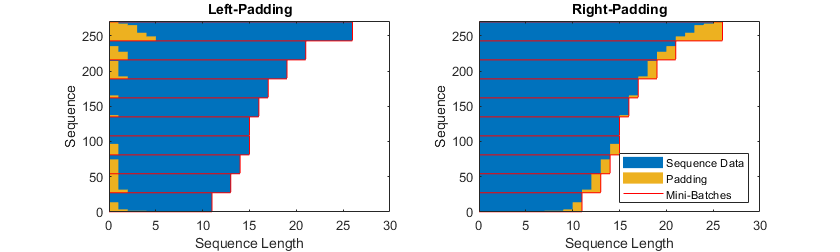

채우기 방향 지정하기

채우기와위치는훈련,분류및정확도영향줄있습니다있습니다있습니다。GydF4y2Ba训练GydF4y2Ba의'SequencePaddingDirection'옵션을'剩下'GydF4y2Ba또는'right'로 설정해 보고 무엇이 데이터에 가장 적합한지 살펴보십시오.

lstm계층시퀀스데이터한번하나시간스텝씩하기때문에계층GydF4y2BaOutputModeGydF4y2Ba속성이GydF4y2Ba'最后的'GydF4y2Ba인경우스텝의채우기가출력에적영향을줄수있습니다있습니다。시퀀스데이터왼쪽에서채우거나자르려면GydF4y2Ba'SequencePaddingDirection'옵션을'剩下'GydF4y2Ba로 설정하십시오.

序列到序列신경망경우(각lstm계층의GydF4y2BaOutputModeGydF4y2Ba속성이GydF4y2Ba'序列'GydF4y2Ba인 경우), 첫 시간 스텝들에서의 채우기가 앞쪽에 있는 시간 스텝들의 예측에 부정적인 영향을 줄 수 있습니다. 시퀀스 데이터를 오른쪽에서 채우거나 자르려면'SequencePaddingDirection'옵션을'right'로 설정하십시오.

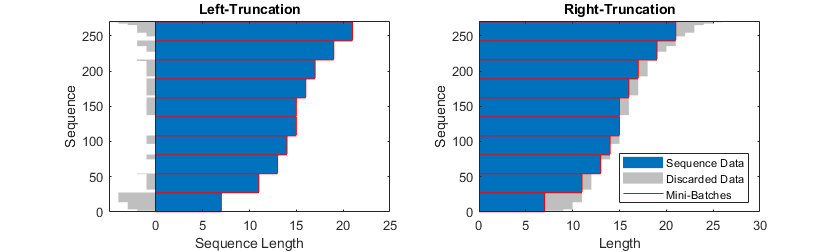

다음그림데이터각각왼쪽오른쪽에서경우를줍니다줍니다줍니다。GydF4y2Ba

다음그림데이터각각왼쪽오른쪽에서경우를줍니다줍니다줍니다。GydF4y2Ba

시퀀스 데이터 정규화하기

0이 중심이 되는 정규화를 사용하여 훈련 시점에 자동으로 훈련 데이터의 중심을 조정하려면sequenceInputLayer의正常化GydF4y2Ba옵션을'zerocenter'로 설정하십시오. 또는 먼저 모든 시퀀스의 특징별 평균값과 표준편차를 계산하여 시퀀스 데이터를 정규화할 수도 있습니다. 그런 다음 각 훈련 관측값에서 평균값을 빼고 표준편차로 나눕니다.

mu = mean([XTrain{:}],2); sigma = std([XTrain{:}],0,2); XTrain = cellfun(@(X) (X-mu)./sigma,XTrain,'UniformOutput',,,,False);

메모리에수없는큰데이터GydF4y2Ba

데이터가메모리담을수데이터배치때때연산을수행수행하려면하려면시퀀스시퀀스시퀀스시퀀스시퀀스시퀀스시퀀스시퀀스시퀀스시퀀스시계열시계열시계열시계열시계열시계열시계열및및신호신호신호신호데이터데이터를를위한위한위한위한위한데이터저데이터저데이터저GydF4y2Ba

자세한내용은GydF4y2Ba메모리에담을없는시퀀스데이터를하여신경망훈련시키기GydF4y2Ba및GydF4y2Ba使用深度学习对失调的文本数据进行分类GydF4y2Ba항목을 참조하십시오.

시각화GydF4y2Ba

activations함수를사용하여 활성화를 추출하여, LSTM 신경망이 시퀀스 데이터와 시계열 데이터에서 학습한 특징을 검사하고 시각화합니다. 자세한 내용은LSTM 신경망의 활성화 시각화항목을 참조하십시오.

LSTM계층아키텍처GydF4y2Ba

다음도식가가인(채널)c개시계열x x lstm계층계층계층통과하는흐름줍니다줍니다줍니다줍니다줍니다줍니다。이도식에서GydF4y2Ba 와 는 각각 시간 스텝 t에서의 출력값(은닉상태GydF4y2Ba라고도함)과GydF4y2Ba셀상태GydF4y2Ba를나타냅니다。GydF4y2Ba

첫번째LSTM블록은신경망의초기상태와시퀀스의첫번째시간스텝을사용하여첫번째 출력값과 업데이트된 셀 상태를 계산합니다. 시간 스텝 t에서, 이 블록은 신경망 의현재시퀀스다음시간스텝을출력값과업데이트된상태GydF4y2Ba 를계산합니다。GydF4y2Ba

계층의상태는GydF4y2Ba은닉상태GydF4y2Ba((GydF4y2Ba출력상태GydF4y2Ba)와셀상태GydF4y2Ba로 구성됩니다. 시간 스텝 t에서의 은닉 상태는 이 시간 스텝에 대한 LSTM 계층의 출력값을 포함합니다. 셀 상태는 이전 시간 스텝에서 학습한 정보를 포함합니다. 이 계층은 각 시간 스텝에서 셀 상태에 정보를 추가하거나 셀 상태로부터 정보를 제거합니다. 계층은게이트를사용하여 이러한 업데이트를 제어합니다.

다음구성계층셀상태와상태제어합니다합니다합니다。GydF4y2Ba

| 구성요소GydF4y2Ba | 목적 |

|---|---|

| 입력게이트((一世)GydF4y2Ba | 셀상태업데이트수준제어GydF4y2Ba |

| 망각 게이트(f) | 셀(망각)의의제어GydF4y2Ba |

| 셀(g)GydF4y2Ba | 셀상태에 정보 추가 |

| 출력 게이트(o) | 은닉상태에 추가되는 셀 상태의 수준 제어 |

다음도식스텝스텝에서데이터을줍니다줍니다줍니다。이도식가셀와은닉상태망각,업데이트,출력출력방식방식을보여줍니다。GydF4y2Ba

LSTM계층의 학습 가능한 가중치는 입력 가중치 W(输入重量GydF4y2Ba),,,,순환 가중치 R(重量级重量GydF4y2Ba),,,,편향 b(Bias)입니다。w,r,b,b는각각구성요소입력결합,순환가중치,편향결합,편향결합。이러한행렬은같이됩니다됩니다。GydF4y2Ba

여기서一世,,,,F,,,,G,,,,o는 입력 게이트, 망각 게이트, 셀 후보, 출력 게이트를 나타냅니다.

the스텝의는다음과표현됩니다됩니다됩니다됩니다됩니다。GydF4y2Ba

여기서GydF4y2Ba 는 아다마르 곱(벡터의 요소별 곱셈)을 나타냅니다.

the스텝의는다음과표현됩니다됩니다됩니다됩니다됩니다。GydF4y2Ba

여기서GydF4y2Ba

는 상태 활성화 함수를 나타냅니다.lstmLayer함수는 기본적으로 쌍곡탄젠트 함수(tanh)를 사용하여 상태 활성화 함수를 계산합니다.

다음 수식은 시간 스텝 t에서의 구성요소를 설명합니다.

| 구성요소GydF4y2Ba | 식 |

|---|---|

| 입력게이트GydF4y2Ba | |

| 망각 게이트 | |

| 셀 후보 | |

| 출력 게이트 |

위 식에서

는게이트화를나타냅니다。GydF4y2BalstmLayer함수는 기본적으로

으로표현함수사용하여게이트화를계산합니다합니다。GydF4y2Ba

참고문헌GydF4y2Ba

[1] Hochreiter,S。和J. Schmidhuber。“长期记忆。”神经计算。卷。9,第8期,1997年,第1735–1780页。GydF4y2Ba

참고 항목

sequenceInputLayer|GydF4y2BalstmLayer|GydF4y2Bab一世lstmLayer|GydF4y2BaGrulayerGydF4y2Ba|GydF4y2BaClassifyAndUpdateState|GydF4y2BapredictAndUpdateState|GydF4y2BaresetState|GydF4y2Ba序列折叠layererGydF4y2Ba|GydF4y2BasequenceunfoldinglayerGydF4y2Ba|GydF4y2BaflattenlayerGydF4y2Ba|GydF4y2BawordEmbeddingLayer((Text Analytics Toolbox)|GydF4y2Baactivations