이 번역 페이지는 최신 내용을 담고 있지 않습니다. 최신 내용을 영문으로 보려면 여기를 클릭하십시오.

RL Agent

강화 학습 에이전트

- 라이브러리:

Reinforcement Learning Toolbox

설명

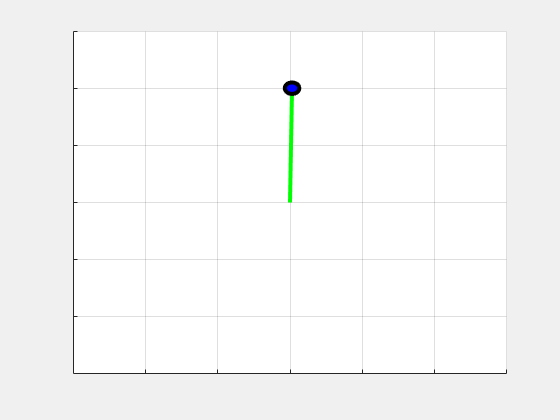

RL Agent블록을 사용하여 Simulink®에서 강화 학습 에이전트를 시뮬레이션하고 훈련시킵니다. 이 블록을 MATLAB®작업 공간에 저장된 에이전트와 연결하거나,rlACAgent객체 또는rlDDPGAgent객체 같은 에이전트 객체로 데이터 사전에 연결합니다. 이 블록이 관측값과 계산된 보상을 받을 수 있도록 연결합니다. 예를 들어,rlSimplePendulumModel모델의 블록 다이어그램이 다음과 같다고 가정하겠습니다.

RL Agent블록의observation입력 포트는 진자의 순시각(instantaneous angle)과 각속도에서 도출되는 신호를 받습니다.reward포트는 이 두 개의 동일한 값과 적용된 행동으로부터 계산된 보상을 받습니다. 사용자는 관측값과 보상 계산을 해당 시스템에 적합하게 구성합니다.

이 블록은 에이전트를 사용하여 사용자가 제공하는 관측값과 보상에 기반한 행동을 생성합니다.action출력 포트를 사용자의 시스템에 들어가는 입력으로 적절하게 연결합니다. 예를 들어,rlSimplePendulumModel에서action포트는 진자 시스템에 적용되는 토크입니다. 이 모델에 대한 자세한 내용은Train DQN Agent to Swing Up and Balance Pendulum항목을참조하십시오。

Simulink에서 강화 학습 에이전트를 훈련시키려면 Simulink 모델에서 환경을 생성하십시오. 그 다음, 에이전트를 만들고 구성하여 이 환경에 대해 훈련시킵니다. 자세한 내용은Simulink 강화 학습 환경 만들기항목을참조하십시오。해당 환경을 사용하여train을 호출하면train은 모델을 시뮬레이션하고 이 블록과 연결된 에이전트를 업데이트합니다.