参见6.4 (Sarsa: On-Policy TD Control),《强化学习:简介》,RS Sutton, AG Barto, MIT出版社

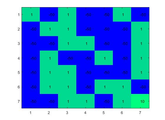

在这个演示中,两个不同的迷宫被强化学习技术解决了,SARSA。

状态-行动-奖励-状态-行动(SARSA)是一种学习马尔可夫决策过程策略的算法,用于强化学习。

SARSA,行动价值功能的更新:

Q (S t {}, {t}): = Q ({t}, {t}) +α* [R {t + 1} +γ∗Q (S t + 1 {}, {t + 1})−Q ({t}, {t}))

学习速率(α)

学习率决定了新获取的信息对旧信息的覆盖程度。因子为0会使agent不学习任何东西,而因子为1会使agent只考虑最近的信息。

贴现因子(γ)

贴现因素决定了未来回报的重要性。当因子为0时,agent只考虑当前的奖励就会成为“机会主义者”,而当因子接近1时,agent就会追求长期的高回报。如果折扣因子满足或超过1,Q值可能会发散。

注:收敛性是在特定的例子上测试的,一般收敛性是不确定的。

引用作为

Bhartendu(2021)。撒尔沙强化学习(//www.tatmou.com/matlabcentral/fileexchange/63089-sarsa-reinforcement-learning), MATLAB中央文件交换。检索.