主要内容

rlACAgentOptions

AC代理选项

描述

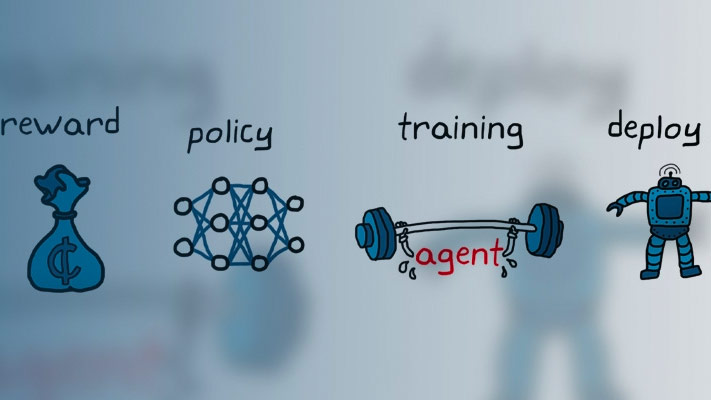

使用一个rlACAgentOptions对象指定用于创建actor-critic (AC)代理的选项。要创建演员-评论家代理,请使用rlACAgent

有关更多信息,请参见Actor-Critic代理.

有关不同类型的强化学习代理的更多信息,请参见强化学习代理.

创建

属性

对象的功能

rlACAgent |

行动者-批评家强化学习代理 |

例子

兼容性的考虑

另请参阅

介绍了R2019a