主要内容

rlSACAgent

软演员-评论家强化学习代理

描述

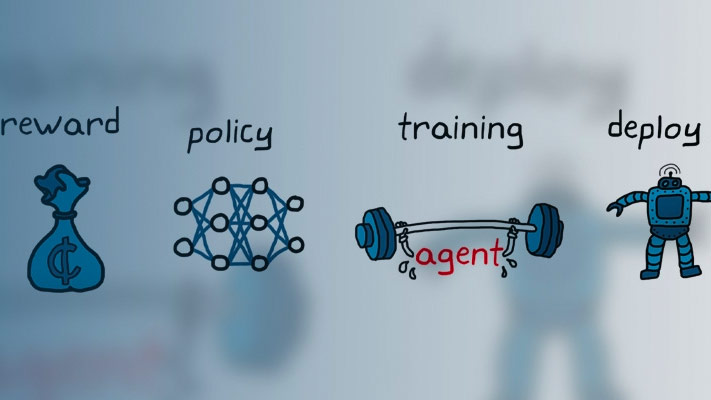

软行为者-批评(SAC)算法是一种无模型、在线、非政策的行为者-批评强化学习方法。SAC算法计算一个最优策略,使长期预期回报和策略的熵最大化。政策熵是给定状态下政策不确定性的度量。更高的熵值促进更多的探索。奖励和熵的最大化平衡了对环境的探索和开发。动作空间只能是连续的。

有关更多信息,请参见软Actor-Critic代理.

有关不同类型的强化学习代理的更多信息,请参见强化学习代理.

创建

语法

描述

从观察和操作规范中创建代理

代理= rlSACAgent (observationInfo,actionInfo)observationInfo和行为规范actionInfo.

代理= rlSACAgent (observationInfo,actionInfo,initOptions)initOptions).

指定代理选项

代理= rlSACAgent (___,agentOptions)

输入参数

属性

对象的功能

例子

另请参阅

rlAgentInitializationOptions|rlSACAgentOptions|rlStochasticActorRepresentation|rlValueRepresentation|深层网络设计师

介绍了R2020b