rlQValueRepresentation

强化学习agent的Q值函数批评表示

描述

该对象实现了一个q值函数近似器,用于强化学习代理内的批评。q值函数是一个函数,它将观察-动作对映射到一个标量值,该标量值表示agent从给定的观察开始并执行给定的动作时所期望积累的总长期回报。因此,q值函数评论家需要观察和行动作为输入。在创建rlQValueRepresentation批评家,使用它创建依赖于Q值函数批评家的代理,例如rlQAgent,rlDQNAgent,萨金特,rlDDPGAgent,或rlTD3Agent.有关创建表示的更多信息,请参见创建策略和价值功能表示.

创建

语法

描述

标量输出q值批评家

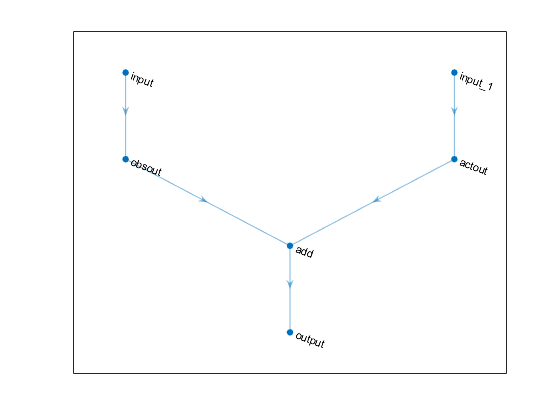

评论家= rlQValueRepresentation (净,observationInfo,actionInfo“观察”,obsName“行动”,演员名)评论家.净是作为近似器使用的深度神经网络,并且必须既有观测值和动作作为输入,又有单个标量输出。该语法设置ObservationInfo和ActionInfo的属性评论家分别输入observationInfo和actionInfo,包括观察和行动规范。obsName的输入层的名称净与观察规范相关的。动作名称演员名必须是输入层的名称净与操作规范关联的。

评论家= rlQValueRepresentation (选项卡,observationInfo,actionInfo)评论家具有离散的行动和观察空间从q值表选项卡.选项卡是一个rlTable对象,该对象包含一个表,其中包含尽可能多的行和尽可能多的列和可能的操作。该语法设置ObservationInfo和ActionInfo的属性评论家分别输入observationInfo和actionInfo,这一定是rlFiniteSetSpec分别包含离散观察和行动空间的规范的对象。

评论家= rlQValueRepresentation ({basisFcn,W0},observationInfo,actionInfo)评论家使用自定义基函数作为底层逼近器。第一个输入参数是一个包含两个元素的单元格,其中第一个元素包含句柄basisFcn到自定义基函数,第二个元素包含初始权值向量W0.在这里,基本函数必须既有观测值又有作为输入的动作W0必须是一个列向量。该语法设置ObservationInfo和ActionInfo的属性评论家分别输入observationInfo和actionInfo.

多输出离散动作空间q值批评家

评论家= rlQValueRepresentation (净,observationInfo,actionInfo“观察”,obsName)评论家对于离散的动作空间.净是用作近似器的深度神经网络,必须仅将观测值作为输入,且单个输出层具有尽可能多的元素(尽可能多的离散动作)。此语法设置ObservationInfo和ActionInfo的属性评论家分别输入observationInfo和actionInfo,包括观察和行动规范。在这里,actionInfo必须是一个rlFiniteSetSpec对象,该对象包含离散动作空间的规范。观察的名字obsName的输入层的名称净.

评论家= rlQValueRepresentation ({basisFcn,W0},observationInfo,actionInfo)评论家对于离散的动作空间使用自定义基函数作为底层逼近器。第一个输入参数是一个包含两个元素的单元格,其中第一个元素包含句柄basisFcn为自定义基函数,第二个元素包含初始权矩阵W0.这里的基函数必须只有观测值作为输入W0必须有尽可能多的列可能的行动的数量。该语法设置ObservationInfo和ActionInfo的属性评论家分别输入observationInfo和actionInfo.

选项

评论家= rlQValueRepresentation (___,选项)评论家使用附加选项集选项,这是一个rlRepresentationOptions对象。该语法设置选项性质评论家到选项输入参数。您可以将此语法与前面的任何输入参数组合一起使用。

输入参数

属性

目标函数

rlDDPGAgent |

深度确定性策略梯度强化学习主体 |

rlTD3Agent |

双延迟深度确定性策略梯度强化学习主体 |

rlDQNAgent |

深度Q网络强化学习agent |

rlQAgent |

Q-学习强化学习agent |

萨金特 |

强化学习代理 |

rlSACAgent |

软演员-评论家强化学习代理 |

getValue |

获得估计值函数表示 |

getMaxQValue |

得到了离散作用空间下q值函数表示的最大状态值函数估计 |