主要内容

rltable.

值表或Q表

描述

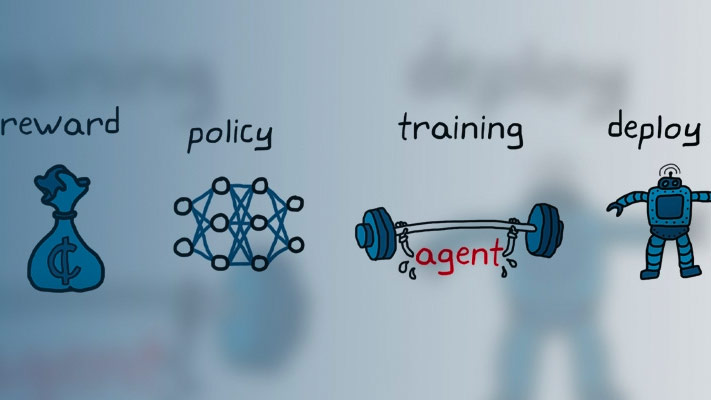

价值表和Q表是代表批评批评资料的一种方法来代表加强学习。价值表存储奖励为有限一套观察。Q表存储相应的有限观察操作对的奖励。

使用a创建值函数表示rltable.对象,使用一个rlvaluerepresentation或rlqvalueerepresentation对象。

创建

输入参数

特性

对象功能

rlvaluerepresentation |

增强学习代理的价值函数评论家代表 |

rlqvalueerepresentation |

Q-Value Function评论家为加固学习代理商表示 |

例子

也可以看看

话题

在R2019A引入