深度学习系统中的偏见

关于电影《编码偏见》的讨论

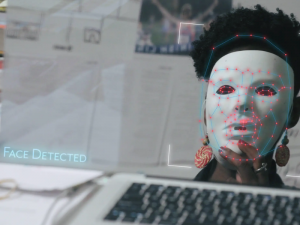

本文来自Heather Gorr (@heather.codes的文章中,她回顾了自己观看《Coded Bias》的经历,并呼吁读者采取行动。《编码偏见》最近被提名为评论家选择奖最佳科学纪录片,并将于2021年4月5日在Netflix播出人工智能可能是错的。我们知道这一点,有些人可能太清楚了!但有时,错误的分类实际上会影响一个人的生活。我们说的不是猫狗之间的误会,也不是不幸的Netflix推荐。一个求职者可能会被错误地忽视一份工作,或者一个无辜的人被指控犯罪。这些都是贯穿整部电影的一些例子和主题编码的偏见,一部广受好评的纪录片,重点介绍了快乐Buolamwini人工智能系统中的偏见,包括面部识别和文本,以及这种偏见的影响。在她的案例中,她正在研究的面部识别系统并没有认出她,直到她戴上了白色面具。

MathWorks最近举办了一场公开放映,并与电影制作人Shalini Kantayya进行了问答,作为我们的一部分NeurIPS聚会(是的,一家软件公司举办了圣丹斯电影放映!)来自世界各地的数百人加入我们,了解这一重要话题并参与讨论。在这篇文章中,我们将总结电影中的观点,讨论偏见,以及对深度学习社区(和社会)的影响。我们还将提供有关如何提供帮助和了解更多信息的资源。

在我们的虚拟NeurIPs聚会期间观看电影“编码偏见”(从希瑟的桌子上)

什么是“偏见”?

也许你听过数学上的偏见社会学或广义上的偏见。它们的定义非常相似。例如,术语“信号偏差或者浮点偏差用来描述增加一个偏移量(比如一个常数值)。换句话说,数学偏差是从中立位置开始的位移,就像一般的意思。

那么,这部电影的背景是什么?两者都有。乔伊发现,用于训练面部识别模型的数据集主要由白人男性组成。当她扩大研究范围,调查更多的商业系统时,数据集由80%的浅肤色人群组成。这些算法对肤色较深的女性面孔进行了错误分类,错误率高达37%。而浅肤色男性的错误率不超过1%。[1] |

|

让我们仔细想想:不平衡的数据有偏见的这个算法。有了更多的数据,它被训练成更准确地对白人面孔进行分类(与黑人面孔的比例不成比例)。此外,这些算法被用于执法和其他已经对黑色面孔有偏见的系统,当算法本身有偏见时,进一步复杂化。

不仅仅是图像,其他类型的数据也会导致偏见。例如,许多文本和NLP模型也使用大型数据集,这些数据集已被发现类似地表现出基于收集数据的人口的偏见。[2]

|

《编码偏见》强调了许多有害后果的例子,尤其是在民权方面。人工智能系统主要用于警察部门、求职网站和金融系统。美国至少有一半的州允许警察搜索驾照照片数据库,以寻找匹配的照片。然而,无辜的人被逮捕,他们的生活永远改变了。这部电影讨论了无数错误逮捕的例子。一个突出的例子是一个14岁的男孩,因为假匹配被警察拦下并搜查。 |

我们可以继续,但我们知道还有希望!基于Joy的研究和倡导,包括创立算法正义联盟在美国,几家大型科技公司停止向执法部门出售工具,美国一些州也停止了面部识别项目。

我们学到了什么?

这部电影给我们上了很多课,尤其是对我们这些在深度学习领域工作的人来说。重要的一点是要考虑训练数据!迁移学习是一种非常流行的方法,它采用了研究人员预先训练好的模型。但在使用训练数据之前,我们应该包括对它们的调查,特别是根据您正在构建的系统类型。

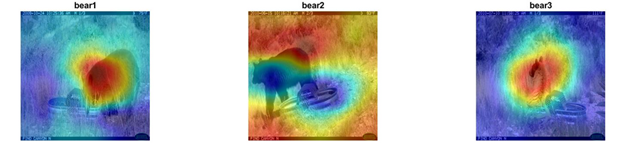

此外,社会上还有关于可解释性模型构建的透明度更高。当然,这方面的算法通常不会考虑人类/社会偏见,但它们可能有助于识别数据和结果中的问题、模式和趋势。例如,LIME、Grad-CAM和Occlusion Sensitivity等算法可以让你深入了解深度学习网络,以及为什么网络选择了特定的选项。例如,下面的图片(来自最近的帖子上深度学习可视化),显示了来自Grad-CAM(梯度加权类激活映射)的结果,突出显示了对分类影响更强的图像部分。

Grad-CAM识别影响分类的图像部分的结果。

但我们也必须退一步,像人类一样思考(让机器负责任!)我们可以更多地了解模型是如何训练的,使用了哪些数据集,并在我们自己的研究中传达这些东西。并且更加了解算法是如何在现实生活中使用的,以及您的工作的含义。

我们能做什么?

这部电影在结尾充满希望地呼吁我们每个人都能做些什么来帮助别人。从本质上讲,主题是意识、教育和行动。教育对我们来说很重要,因为你们中的许多人刚刚开始学习深度学习和人工智能。既然你看到了这篇文章的结尾,那么当你回到自己的生活时,你就会意识到并掌握了一些背景知识。这是第一步!

|

要做得更多,我们可以通过下面的链接了解并采取行动。

|

参考文献

[1]“性别阴影:商业性别分类的交叉准确性差异”,Joy Buolamwini和Timnit Gebru,机器学习研究学报,2018年2月http://proceedings.mlr.press/v81/buolamwini18a/buolamwini18a.pdf [2]艾米丽·m·本德,蒂姆尼特·格布鲁,安吉丽娜·麦克米兰-梅杰和什玛格利特·施米切尔。2021。关于随机鹦鹉的危险:语言模型会太大吗?在公平、问责和透明会议(FAccT '21)上,2021年3月3日至10日,加拿大虚拟活动。ACM,纽约,纽约,美国,14页。https://doi.org/10.1145/3442188.3445922https://faculty.washington.edu/ebender/papers/Stochastic_Parrots.pdf [3]编码偏见教育讨论指南https://static1.squarespace.com/static/5eb23eee707c5356dea97eaa/t/5ffe4ff872238a5c80e4020b/1610502147093/CODED_Educational_Guide_Final.pdf [4]//www.tatmou.com/discovery/interpretability.html [5]https://blogs.mathworks.com/deep-learning/2019/06/20/explainable-ai/- 类别:

- 深度学习

克利夫角:克利夫莫勒的数学和计算

克利夫角:克利夫莫勒的数学和计算 MATLAB博客

MATLAB博客 用MATLAB进行图像处理

用MATLAB进行图像处理 Simulin金宝appk上的Guy

Simulin金宝appk上的Guy 人工智能

人工智能 开发区域

开发区域 Stuart的MATLAB视频

Stuart的MATLAB视频 头条新闻背后

头条新闻背后 本周文件交换选择

本周文件交换选择 汉斯谈物联网

汉斯谈物联网 学生休息室

学生休息室 MATLAB社区

MATLAB社区 Matlabユザコミュニティ

Matlabユザコミュニティ 创业公司、加速器和企业家

创业公司、加速器和企业家 自治系统

自治系统

评论

如欲留言,请点击在这里登录您的MathWorks帐户或创建一个新帐户。