fitPosterior

拟合支持向量机分类器的后验概率金宝app

语法

描述

ScoreSVMModel= fitPosterior (SVMModel)ScoreSVMModel包含两类学习的最优得分-后验概率变换函数。有关详细信息,请参见算法.

[另外,返回最优的得分后验概率转换函数参数。ScoreSVMModel,ScoreTransform) = fitPosterior (SVMModel)

[使用由一个或多个名称-值对参数指定的附加选项。例如,您可以指定折叠的数量或坚守样品的比例。ScoreSVMModel,ScoreTransform) = fitPosterior (SVMModel,名称,值)

例子

输入参数

输出参数

更多关于

提示

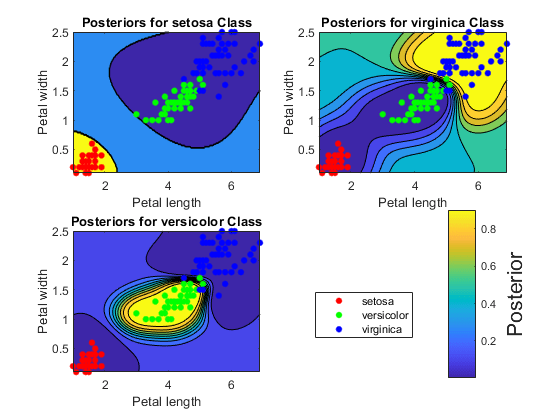

这个过程描述了一种预测正类后验概率的方法。

通过传递数据来训练SVM分类器

fitcsvm.结果是一个训练的SVM分类器,如SVMModel,用来存储数据。软件设置分数变换函数属性(SVMModel。ScoreTransformation)没有一个.通过训练的SVM分类器

SVMModel来fitSVMPosterior或fitPosterior.结果,如:ScoreSVMModel,与训练的SVM分类器相同SVMModel,除了软件集ScoreSVMModel。ScoreTransformation的最优积分变换函数。通过预测器数据矩阵和包含最优分数变换函数的训练SVM分类器(

ScoreSVMModel)预测.的第二个输出参数中的第二列预测存储预测器数据矩阵每一行对应的正类后验概率。如果你跳过第二步,那么

预测返回正的类别得分,而不是正的类别后验概率。

在拟合后验概率之后,您可以生成C/ c++代码来预测新数据的标签。生成C/ c++代码需要<年代pan class="entity">MATLAB<年代up>®编码器™.有关详细信息,请参见代码生成简介.

算法

该软件利用支持向量机分类器拟合出合适的得分-后验概率转换函数SVMModel通过使用存储的预测数据进行10倍交叉验证(SVMModel。X)和类标签(SVMModel。Y)[1].变换函数计算观察被归入正类的后验概率(SVMModel.Classnames (2)).

如果您重新估计得分后验概率转换函数,也就是说,如果您将一个SVM分类器传递给fitPosterior或fitSVMPosterior和它的ScoreTransform属性是不没有一个,则软件:

显示一个警告

将原来的转换函数重置为

“没有”在估计新的情况之前

选择功能

你也可以用fitSVMPosterior.这个函数类似于fitPosterior,但它更广泛,因为它接受更广泛的SVM分类器类型。

参考文献

[1] Platt, J.“支持向量机的概率输出和与正则似然方法的比较。”金宝app大裕度分类器的进展.麻省理工学院出版社,2000年,61-74页。

另请参阅

ClassificationSVM|<年代pan itemscope itemtype="//www.tatmou.com/help/schema/MathWorksDocPage/SeeAlso" itemprop="seealso">预测|<年代pan itemscope itemtype="//www.tatmou.com/help/schema/MathWorksDocPage/SeeAlso" itemprop="seealso">fitSVMPosterior|<年代pan itemscope itemtype="//www.tatmou.com/help/schema/MathWorksDocPage/SeeAlso" itemprop="seealso">fitcsvm