主要内容

检测

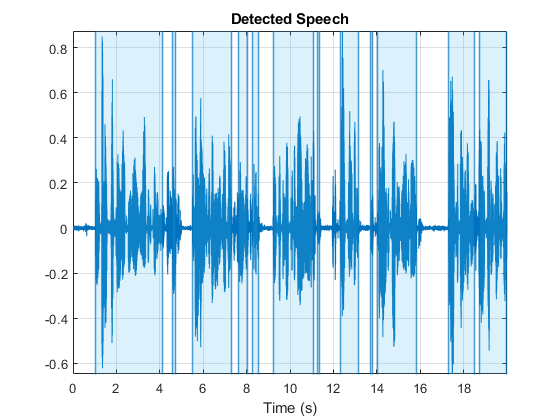

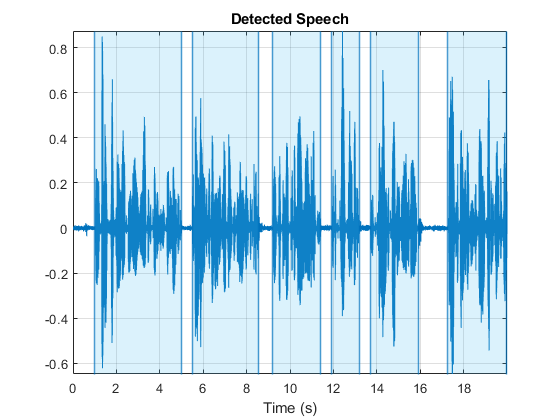

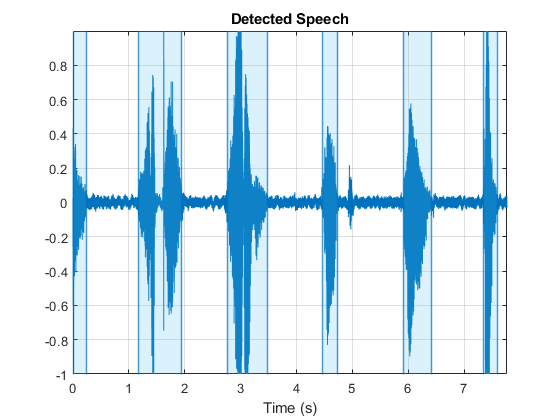

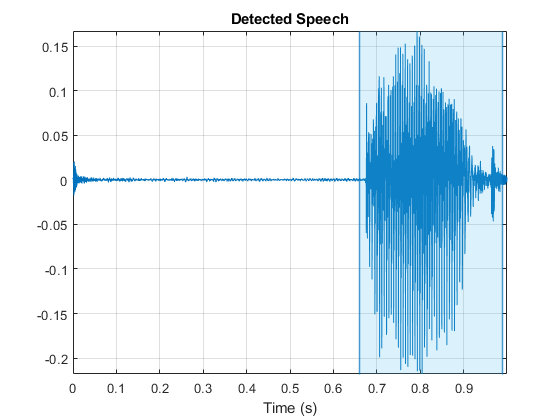

检测音频信号中的语音边界

句法

描述

例子

输入参数

输出参数

算法

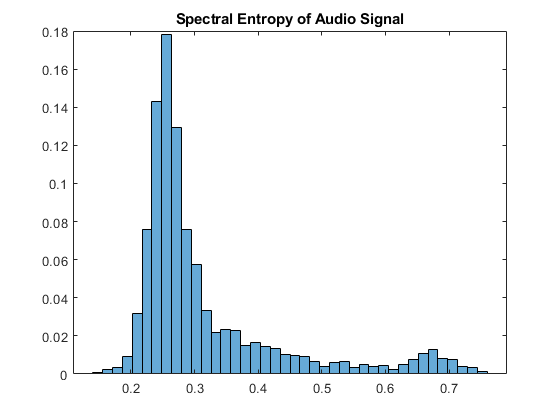

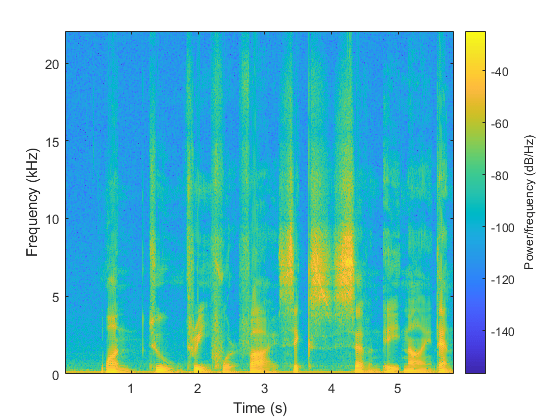

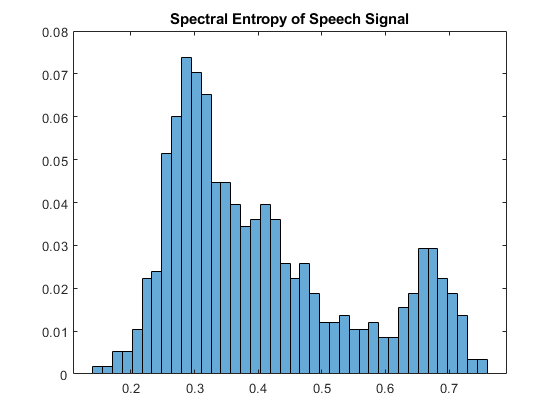

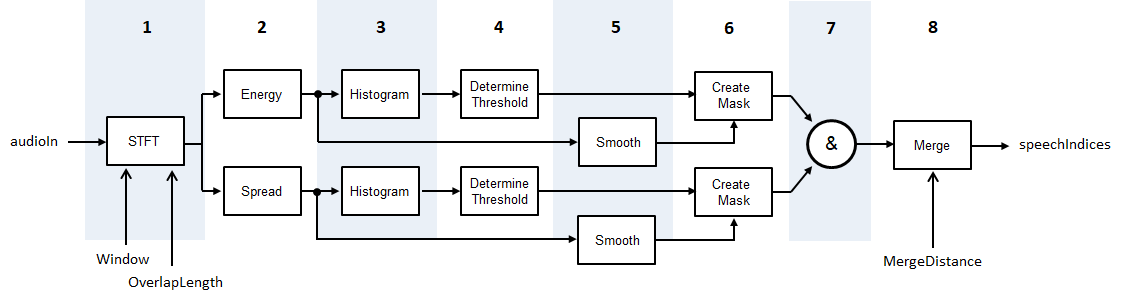

这检测算法基于[1],虽然修改使得阈值的统计数据是短期能量和光谱传播,而不是短期能量和光谱质心。图和步骤提供了算法的高级概述。有关详细信息,请参阅[1]。

使用指定的音频信号将音频信号转换为时频表示

窗户和overtaplenth。为每个帧计算短期能量和光谱扩展。根据条件计算光谱差距

光谱覆盖。为短期能量和光谱传播分布而创建直方图。

对于每个直方图,根据阈值 , 在哪里m1和m2是第一和第二局最大的最大值。W.设定为

5.。通过连续的五元素移动中值过滤器通过连续的五元件,横跨频谱扩散和短期能量都是平滑的。

通过将短期能量和光谱传播与各自的阈值进行比较来创建掩模。要将帧声明为包含语音,则必须高于其阈值。

掩模组合。对于被宣布为语音的帧,短期能量和光谱扩展必须高于它们各自的阈值。

由于它们之间的距离小于

合作。

参考

[1] Giannakopoulos,Theodoros。“2009年雅典大学在Matlab实施的沉默去除和演讲信号分割的方法。

扩展能力

在R2020A中介绍