主要内容

设计层 - 反复性神经网络

要引入的下一个动态网络是层复制网络(LRN)。埃尔曼介绍了这个网络的早期简化版本[elma90.]。在LRN中,除了最后一层之外,存在一个反馈循环,围绕每层延迟,除了最后一层。原始Elman网络只有两层,并使用了一个田樱隐藏层的传递函数和a普林林输出层的传递函数。原始ELMAN网络使用近似验证到BackProjagation算法。这layrecnet.命令概括了ELMAN网络具有任意数量的层,并在每层中具有任意传输函数。工具箱使用讨论的基于梯度的算法的精确版本列出LRN多层浅神经网络和背部训练。下图说明了两个层LRN。

LRN配置在许多过滤和建模应用程序中使用。要显示其操作,此示例使用讨论的“音素”检测问题设计时间序列分布式延迟神经网络。以下是加载数据并创建和培训网络的代码:

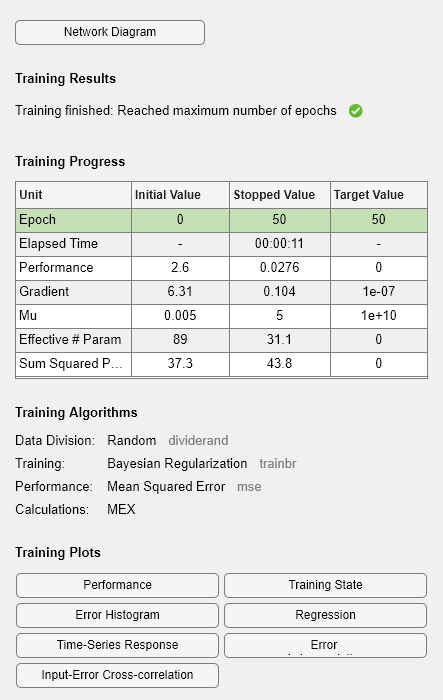

加载音素p = con2seq(y);t = con2seq(t);lrn_net = layrecnet(1,8);lrn_net.trainfcn =.'trainbr';lrn_net.trainparam.show = 5;lrn_net.trainparam.echs = 50;lrn_net =火车(lrn_net,p,t);

培训后,您可以使用以下代码绘制响应:

y = lrn_net(p);绘图(Cell2mat(Y))

绘图显示网络能够检测“音素”。响应与使用TDNN获得的响应非常相似。

每次训练神经网络时,都会导致不同的解决方案,因为不同的初始权重和偏置值以及数据的不同分区训练,验证和测试集。结果,在同一问题上训练的不同神经网络可以为相同的输入提供不同的输出。为了确保已经发现了良好准确性的神经网络,重新恢复了几次。

如果需要更高的精度,则存在几种用于改善初始解决方案的技术。金宝搏官方网站有关更多信息,请参阅提高浅层神经网络泛化,避免过度装备。