主要内容

立体声视频深度估计

这个例子展示了如何在用校准的立体相机拍摄的视频中检测人,并确定他们与相机的距离。

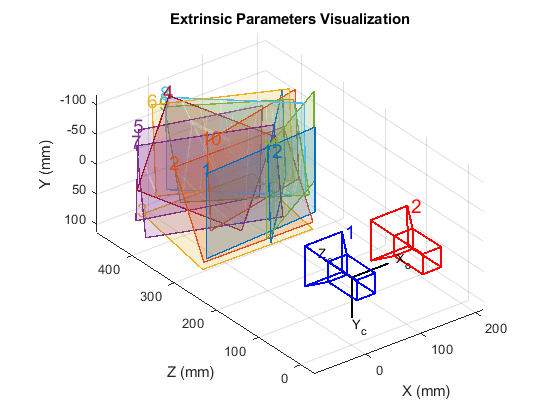

加载立体相机的参数

加载stereoParameters对象,这是校准相机使用或stereoCameraCalibrator应用程序或estimateCameraParameters函数。

加载stereparameters对象。负载(“handshakeStereoParams.mat”);视觉化摄像机外物。showExtrinsics (stereoParams);

创建视频文件阅读器和视频播放器

创建用于读取和显示视频的系统对象。

videoFileLeft =“handshake_left.avi”;videoFileRight =“handshake_right.avi”;readerLeft = VideoReader (videoFileLeft);readerRight = VideoReader (videoFileRight);球员=愿景。放像机(“位置”560年[20200740]);

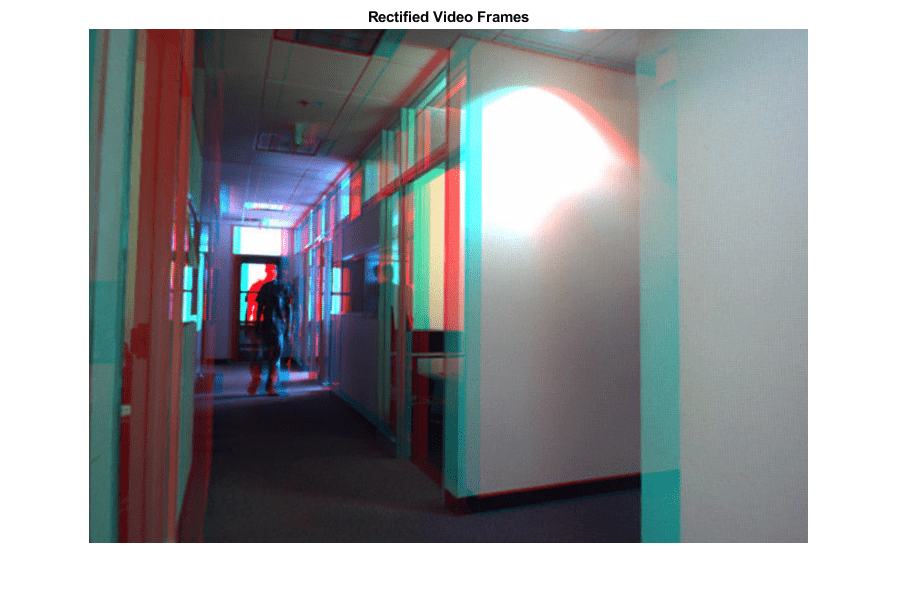

读取和修复视频帧

为了计算视差和重建三维场景,必须对左右摄像机的帧进行校正。校正后的图像具有水平极线,并行对齐。通过将匹配点的搜索空间缩小到一维,简化了视差的计算。矫正后的图像也可以组合成一个浮雕,可以使用立体红青色眼镜观看,以获得三维效果。

frameLeft = readFrame (readerLeft);frameRight = readFrame (readerRight);[frameLeftRect, frameRightRect] =...rectifyStereoImages (frameLeft frameRight stereoParams);图;imshow (stereoAnaglyph (frameLeftRect frameRightRect));标题(纠正视频帧的);

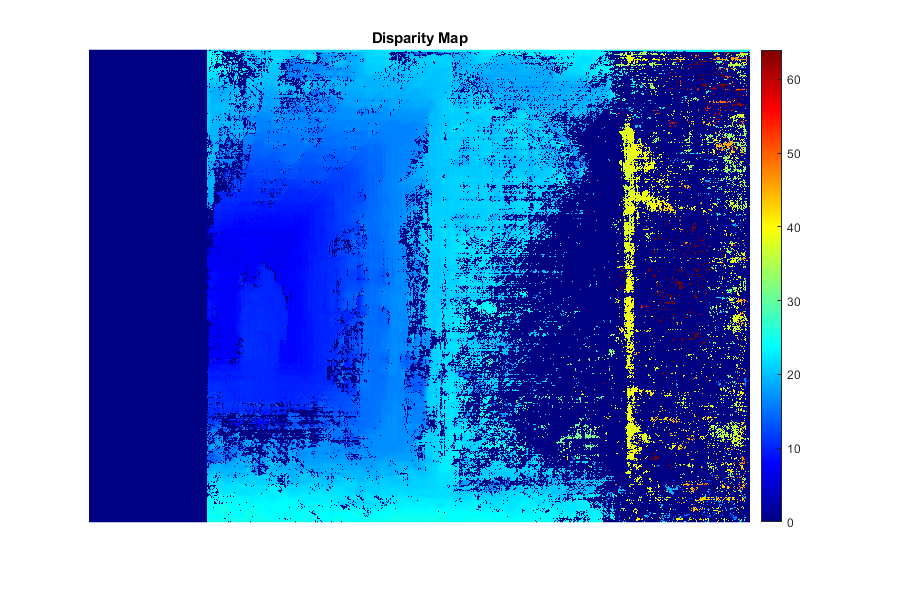

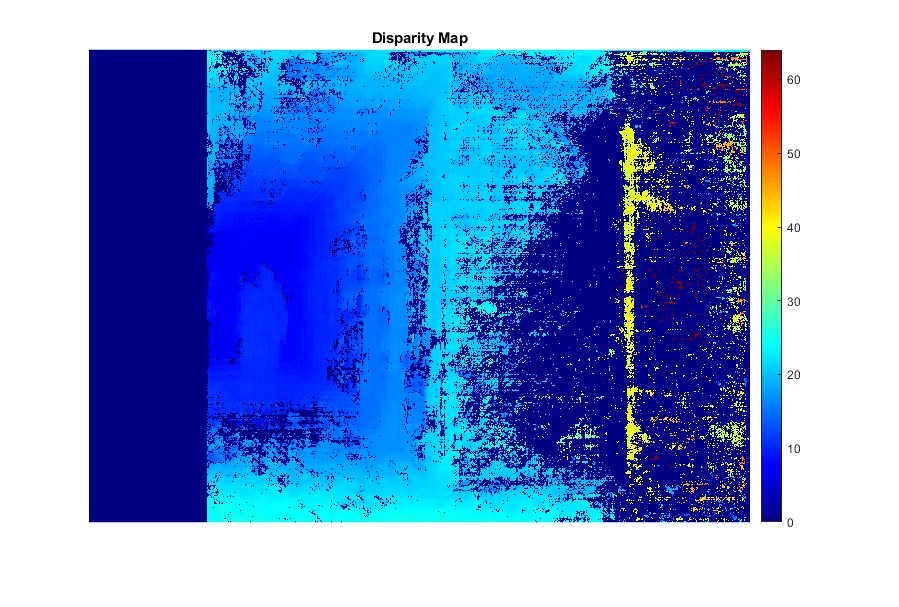

计算差异

在矫正后的立体图像中,任意一对对应的点都位于同一像素行上。对于左边图像中的每个像素计算到右边图像中相应像素的距离。这个距离称为视差,它与相应的世界点到相机的距离成正比。

frameLeftGray = rgb2gray (frameLeftRect);frameRightGray = rgb2gray (frameRightRect);disitymap = disityysgm (frameLeftGray, frameRightGray);图;, 64年imshow (disparityMap [0]);标题(“差距地图”);colormap飞机colorbar

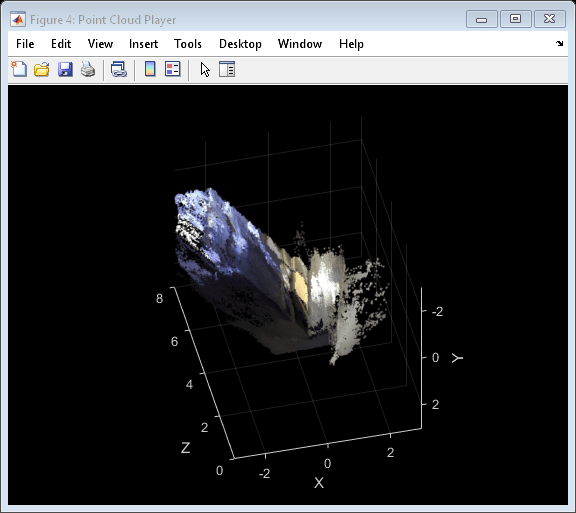

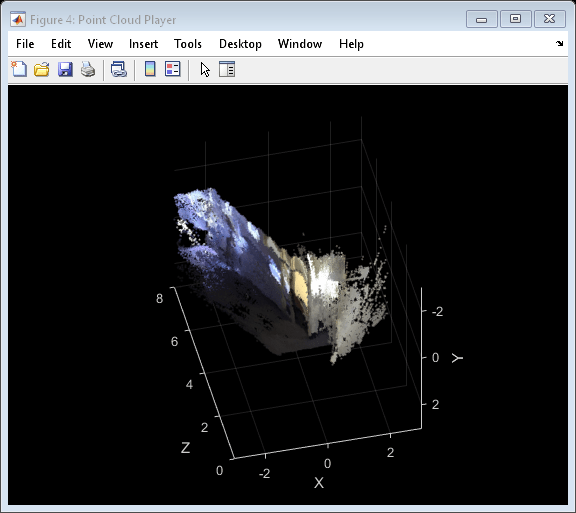

重建三维场景

从视差图中重建每个像素对应的点的三维世界坐标。

points3D = reconstructScene(disparityMap, stereoParams);%转换为米并创建一个pointCloud对象point3d = point3d ./ 1000;ptCloud = pointCloud (points3D,“颜色”, frameLeftRect);创建一个流点云查看器player3D = pcplayer([- 3,3], [- 3,3], [0,8],“VerticalAxis”,“y”,...“VerticalAxisDir”,“下来”);想象点云视图(player3D ptCloud);

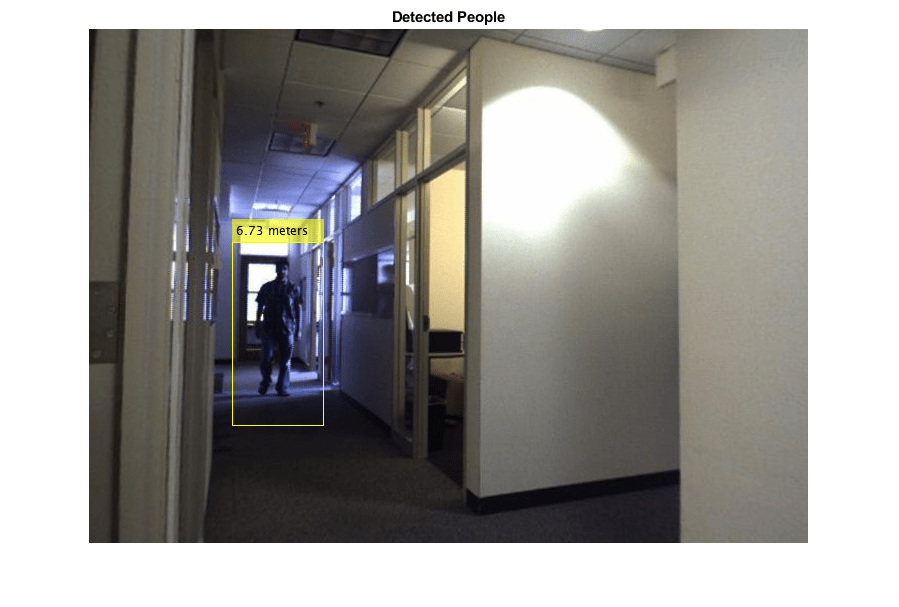

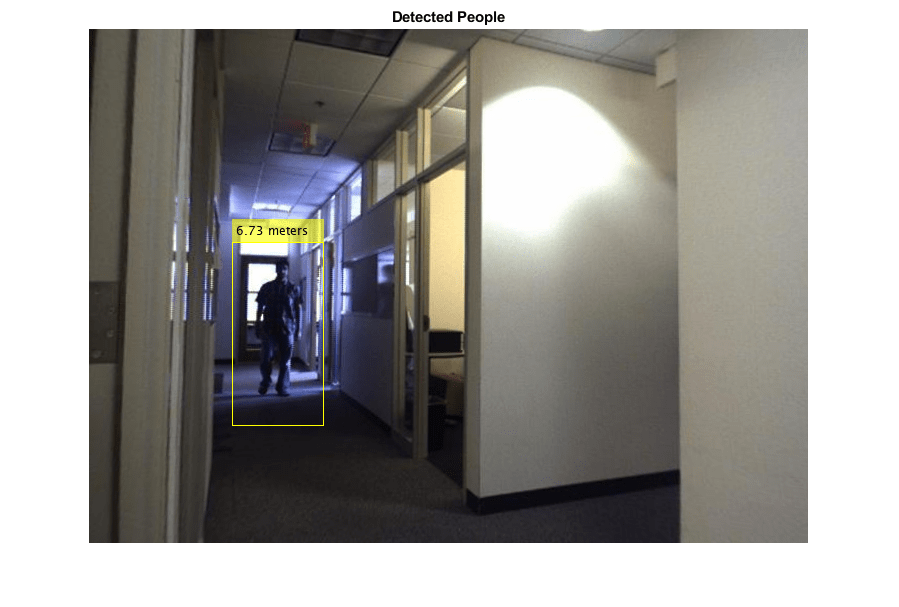

检测左侧图像中的人

使用愿景。PeopleDetector用于检测人的系统对象。

%创建人员检测器对象。限制对象的最小大小%的速度。peopleDetector =愿景。PeopleDetector (“MinSize”83年[166]);%检测人。bboxes = peopleDetector.step (frameLeftGray);

确定每个人到相机的距离

找到每个被检测人质心的三维世界坐标,并计算质心到摄像机的距离,单位为米。

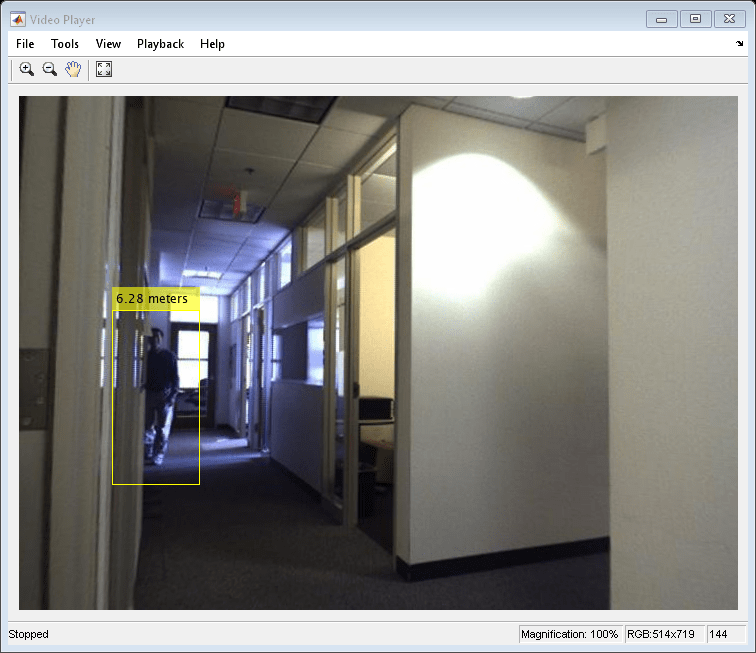

找到被检测到的人的质心。= [round(bboxes(:, 1) + bboxes(:, 3) / 2),...Round (bboxes(:, 2) + bboxes(:, 4) / 2)];找到质心的三维世界坐标。centroidsIdx = sub2ind(size(disparityMap), centroids(:, 2), centroids(:, 1));X = point3d (:,:, 1);Y = point3d (:,:, 2);Z = point3d (:,:, 3);centroids3D = [X (centroidsIdx) ';Y (centroidsIdx) ';Z (centroidsIdx)];求距离摄像机的距离,单位为米。* * * * * * * * * * * * * * * * * *显示检测到的人和他们的距离。标签= cell(1, numel(dists));为I = 1:numel(dists)标签{I} = sprintf(“% 0.2 f米”距离(我));结束图;imshow (insertObjectAnnotation (frameLeftRect,“矩形”、bboxes标签);标题(检测到人的);

处理剩下的视频

应用上述步骤来检测人物,并在视频的每一帧中测量他们与摄像机的距离。

而hasFrame (readerLeft) & & hasFrame (readerRight)%读取帧。frameLeft = readFrame (readerLeft);frameRight = readFrame (readerRight);%修复帧。[frameLeftRect, frameRightRect] =...rectifyStereoImages (frameLeft frameRight stereoParams);%转换为灰度。frameLeftGray = rgb2gray (frameLeftRect);frameRightGray = rgb2gray (frameRightRect);%计算差异。disitymap = disityysgm (frameLeftGray, frameRightGray);%重建三维场景。points3D = reconstructScene(disparityMap, stereoParams);point3d = point3d ./ 1000;ptCloud = pointCloud (points3D,“颜色”, frameLeftRect);视图(player3D ptCloud);%检测人。bboxes = peopleDetector.step (frameLeftGray);如果~ isempty (bboxes)找到被检测到的人的质心。= [round(bboxes(:, 1) + bboxes(:, 3) / 2),...Round (bboxes(:, 2) + bboxes(:, 4) / 2)];找到质心的三维世界坐标。centroidsIdx = sub2ind(size(disparityMap), centroids(:, 2), centroids(:, 1));X = point3d (:,:, 1);Y = point3d (:,:, 2);Z = point3d (:,:, 3);[X(centroidsIdx), Y(centroidsIdx), Z(centroidsIdx)];求距离摄像机的距离,单位为米。drawtext (sum(entroids3d .^ 2, 2));显示探测到的人和他们的距离。标签= cell(1, numel(dists));为I = 1:numel(dists)标签{I} = sprintf(“% 0.2 f米”距离(我));结束dispFrame = insertObjectAnnotation (frameLeftRect,“矩形”bboxes,...标签);其他的dispFrame = frameLeftRect;结束%显示帧。步骤(球员,dispFrame);结束

%清理释放(球员);

总结

这个例子展示了如何使用校准的立体相机在3-D中定位行人。

参考文献

G. Bradski和A. Kaehler,“学习OpenCV:使用OpenCV库的计算机视觉”,O'Reilly, Sebastopol, CA, 2008。

[2] Dalal, N.和Triggs, B.,面向人类检测的梯度直方图。CVPR 2005。