最佳控制是满足设计目标的动态系统的条件。通过按照定义的最优标准执行的控制定律,可以实现最佳控制。一些广泛使用的最佳控制技术是:

线性二次调节器(LQR)/线性二次高斯(LQG)控制

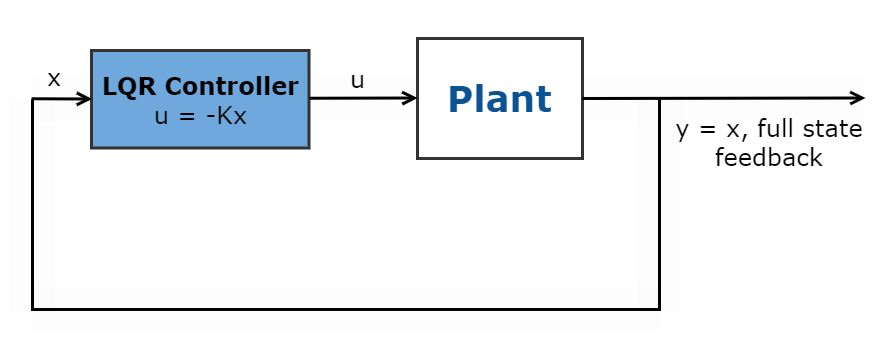

线性二次调节器(LQR)是一个完整的状态反馈最佳控制定律,\(u = -kx \),可最大程度地减少二次成本函数以调节控制系统。

此成本函数取决于系统状态\((x)\)和控制输入\((u)\),如下所示。

$$ j(u)= \ int_ {0}^{\ infty}(x^t qx+u^t ru+2x^t nu)dt $$

根据性能规范,为此最佳控制法定义了加权因素Q,R和N,以定义系统状态调节和控制成本驱动成本之间的适当平衡。

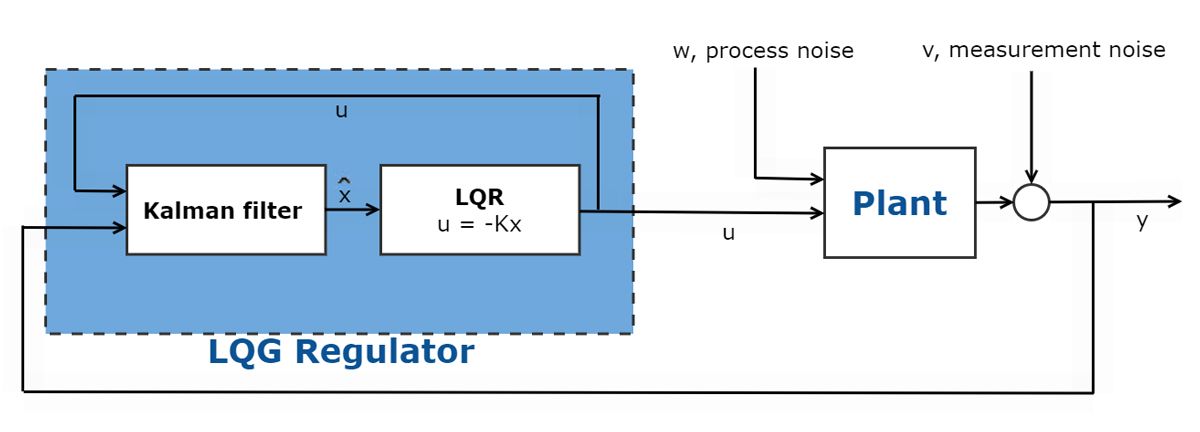

在许多最佳控制问题中,并非所有状态测量都可以访问。在这些情况下,必须使用观察者估算状态。这通常是使用观察者(例如Kalman滤镜)完成的。与LQR控制器结合使用的Kalman滤波器构成了线性二次高斯(LQG)控制器。

要了解更多信息,请检查一下MATLAB Tech Talk在LQR控制上。

模型预测控制

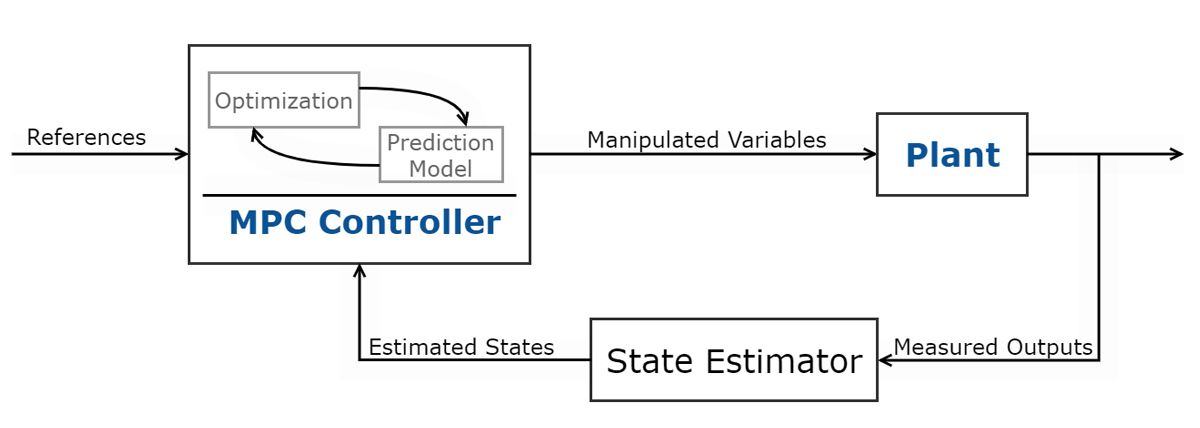

模型预测控制(MPC)用于最大程度地减少受输入和输出约束的多输入多输出(MIMO)系统中的成本函数。这种最佳控制技术使用系统模型来预测未来的植物产量。使用预测的工厂输出,控制器解决了一个在线优化问题,即二次程序,以确定对可操作变量的最佳调整,该变量将预测的输出驱动到参考。MPC变体包括自适应,增益式安排和非线性MPC控制器。所使用的MPC控制器的类型取决于预测模型(线性/非线性),约束(线性/非线性),成本函数(二次/非二次),吞吐量和样本时间。要了解更多信息,请查看这个Matlab技术演讲关于MPC变体。

微处理器技术和有效算法的进步增加了这种最佳控制方法在自动驾驶,航空航天应用中的最佳地形跟踪等应用中的采用等。

要了解更多信息,请查看这个Matlab技术谈话系列在模型预测控制上。

强化学习

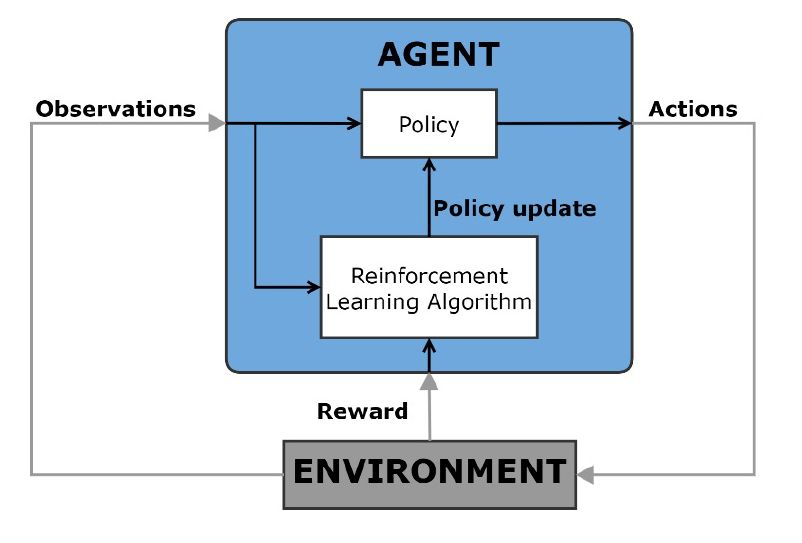

强化学习是一种机器学习技术,其中计算机代理通过反复与动态环境进行反复试验相互作用来学习最佳行为。代理商使用环境的观察来执行一系列动作,目的是最大程度地提高代理商对任务的累积奖励指标。这种学习是在没有人类干预和没有明确编程的情况下进行的。

这种最佳控制方法可用于决策问题,并作为使用常规控制方法(例如自动驾驶,机器人技术,调度问题和系统的动态校准)的应用程序的非线性控制替代方案。

要了解更多信息,请查看这个Matlab技术谈话系列关于加强学习。

超级寻求控制

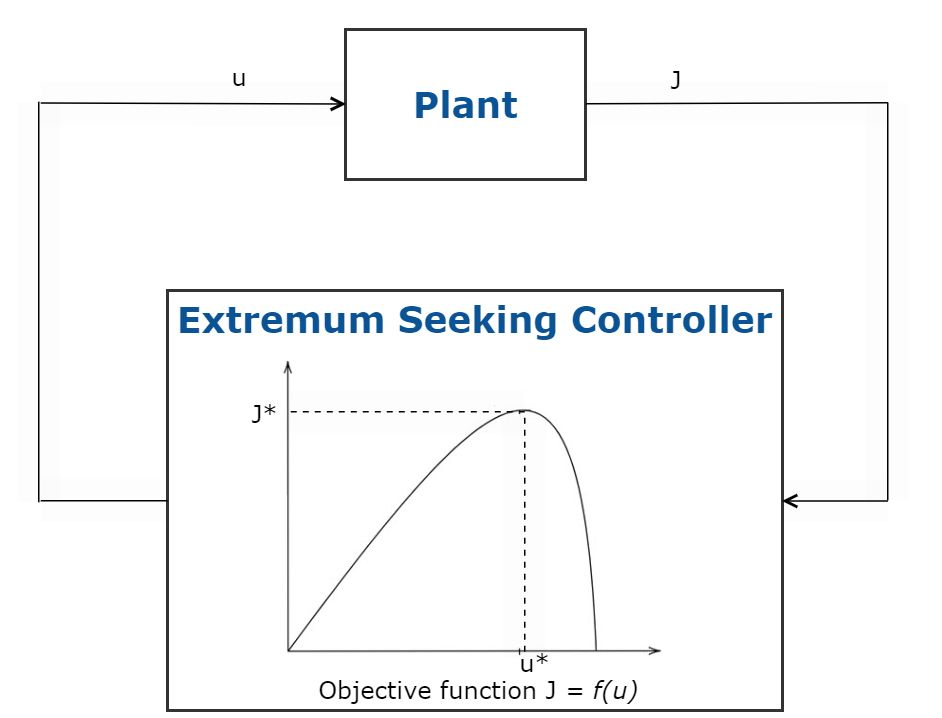

Extremum Seewing是一种最佳控制技术,它会自动调整控制系统参数,以使用无模型的实时优化最大化目标函数。此方法不需要系统模型,可以用于参数和干扰随时间变化的系统。这种最佳控制技术适用于可以忍受控制中噪声的稳定系统,并且只需要调整少量控制系统参数。

超级寻求控制的应用包括自适应巡航控制,太阳能阵列的最大功率跟踪(MPPT)和防抱死制动系统(ABS)。

图5.超级寻求控制的示意图。

h-侵点合成

H-侵点合成是一种用于设计单输入单输出(SISO)或MIMO反馈控制器的最佳控制工具/技术,以实现稳健的性能和稳定性。与经典的控制技术(例如使用Bode或PID调整)相比,H-含量更适合于需要在通道之间进行交叉耦合的多变量控制系统。

使用H-侵蚀性,控制目标是根据归一化闭环增益制定的。H-侵点合成会自动计算一个控制器,该控制器通过最大程度地减少该增益来优化性能。这很有用,因为许多控制目标可以用最小化的收益来表达。这包括诸如干扰拒绝,对噪声的敏感性,跟踪,循环塑造,循环解耦和稳定稳定性等目标。H-含量合成的变化可用于处理固定结构或全阶控制器。

要了解更多信息,请检查一下MATLAB Tech Talk关于H-侵点合成。

下表比较了上述最佳控制方法:

| 最佳控制方法 | 在运行时进行了优化吗?(是/否) | 优化过程如何在此最佳控制过程中起作用? | 它可以处理硬约束吗?*(是/否) | 它使用基于模型的技术吗?(是/否) | 什么是吞吐量?(前高后低) |

|---|---|---|---|---|---|

| LQR/LQG | 不 | 用途封闭式解决方案可与已知的线性时间不变系统一起使用 | 不 | 是的 | 高的 |

| 隐式MPC(是) | 用一个预测模型,解决一个在线优化问题计算最佳控制动作 | 是的 | 是的 | 低(非线性MPC),高(线性MPC) | |

| 显式MPC(否) | 解决方案优化问题用于计算最佳控制操作是脱机计算 | 是的 | 是的 | 高的 | |

| 强化学习 | 是的** | 学习任务的最佳行为最大化奖励指标 | 不*** | 取决于培训算法 | 低(带有训练),中高(推理期间) |

| 超级寻求控制 | 是的 | perturbs和适应控制参数最大化目标函数 | 不 | 不 | 高的 |

| h-侵点合成 | 不 | 自动计算一个控制器最小化标准化的闭环增益 | 不 | 是的 | 高的 |