主要内容

이페이지의최신내용은아직번역되지않았습니다。최신내용은영문으로볼수있습니다。

analyzeNetwork

딥러닝신경망아키텍처분석

설명

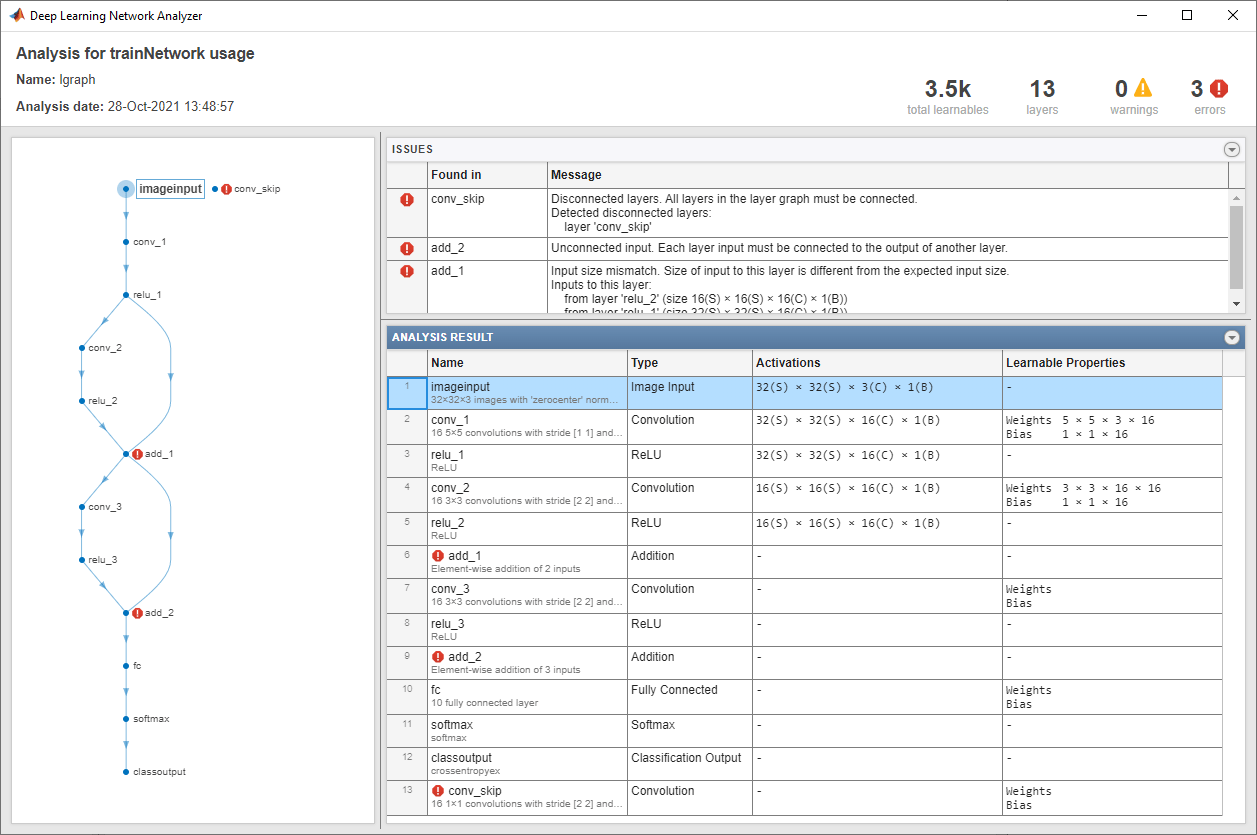

analyzeNetwork (는层)层로지정된딥러닝신경망아키텍처를분석합니다。analyzeNetwork함수는신경망아키텍처를대화형방식으로표시하고,신경망의오류와문제를검출하고,신경망계층에대한상세한정보를제공합니다。계층정보에는계층활성화의크기와학습가능한파라미터,학습가능한파라미터의총개수,순환계층의상태파라미터의크기가포함됩니다。

신경망분석기를사용해서신경망아키텍처를시각화하여이해하고,아키텍처를올바르게정의했는지확인하고,훈련전에문제를파악합니다。analyzeNetwork에서검출하는문제에는계층이누락되었거나연결이끊긴경우,계층입력크기가올바르지않은경우,계층입력개수가올바르지않은경우,그래프구조가유효하지않은경우등이포함됩니다。

예제

입력인수

R2018a에개발됨