主要内容

损失

查找支持向量机(SVM)分类器的分类错误金宝app

描述

L=损失(svmmodel.,TBL.,responsevarname.)svmmodel.)对表中的预测器数据进行分类TBL.与真正的课程标签相比tbl.responsevarname..

损失标准化类概率tbl.responsevarname.到之前的概率fitcsvm.用于培训,储存在事先的性质svmmodel..

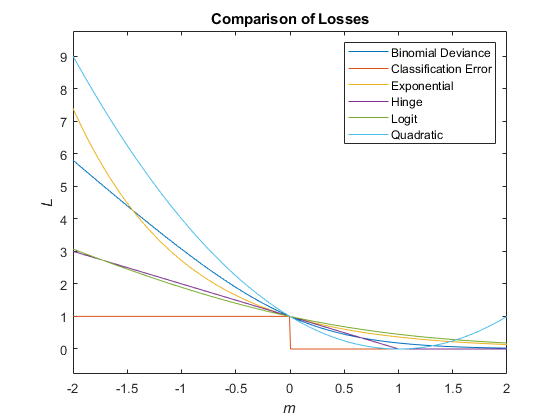

分类损失(L)是一种概括或重新替代的质量度量。其解释取决于损失函数和加权方案,但一般来说,更好的分类器产生更小的分类损失值。

例子

输入参数

更多关于

参考

[1] Hastie,T.,R. Tibshirani和J. Friedman。统计学习的要素,第二版。斯普林格,纽约,2008年。

扩展能力

在R2014A介绍