fsrnca

特征选择使用邻域成分分析回归

描述

例子

利用NCA进行回归,检测数据中的相关特征

生成玩具数据,其中响应变量依赖于第3、第9和第15个预测因子。

rng (0,“旋风”);重复性的%N = 100;X =兰德(N, 20);y = 1 + X(:, 3) * 5 +罪(X(: 9)。/ X (:, 15) + 0.25 * randn (N - 1));

拟合邻域成分分析模型进行回归。

mdl = fsrnca (X, y,'verbose',1,“λ”,0.5 / n);

o Solver = LBFGS, HessianHistorySize = 15,LineSearchMethod = weakwolfe |====================================================================================================| | ITER | |娱乐价值规范研究生| |规范一步曲线|γ|α|接受 | |====================================================================================================| | 0 e + 00 | 1.636932 | 3.688 e-01 |0.000 e + 00 | | 1.627 e + 0.000 e + 00 00 | |是| | 1 | 8.304833 e-01 e-01 | 1.083 | 2.449 e + 00 |好| 9.194 e + 4.000 e + 00 00 | |是| | 2 | 7.548105 e-01 e-02 | 1.341 | 1.164 e + 00 |好01 | 1.000 | 1.095 e + e + 00 |是| | 3 | 7.346997 e-01 e 03 | 9.752 | 6.383 e-01 |好01 | 1.000 | 2.979 e + e + 00 |是| | 4 | 7.053407 e-01 e-02 | 1.605 | 1.712 e + 00 5.809 e + 01 | | | OK1.000 e + 00 |是| | 5 | 6.970502 e-01 e 03 | 9.106 | 8.818 e-01 |好01 | 1.000 | 6.223 e + e + 00 |是| | 6 | 6.952347 e-01 e 03 | 5.522 | 6.382 e-01 |好01 | 1.000 | 3.280 e + e + 00 |是| | 7 | 6.946302 e-01 e-04 | 9.102 | 1.952 e-01 |好01 | 1.000 | 3.380 e + e + 00 |是| | 8 | 6.945037 e-01 e-04 | 6.557 | 9.942 e-02 |好01 | 1.000 | 8.490 e + e + 00 |是| | |e-04 e-01 6.943908 | 1.997 | 1.756 e-01 |好e + 02 | 1.124 | 1.000 e + 00 |是| | 10 | 6.943785 e-01 e-04 | 3.478 | 7.755 e-02 |好01 | 1.000 | 7.621 e + e + 00 |是| | 11 | 6.943728 e-01 e-04 | 1.428 | 3.416 e-02 |好01 | 1.000 | 3.649 e + e + 00 |是| | 12 | 6.943711 e-01 e-04 | 1.128 | 1.231 e-02 |好01 | 1.000 | 6.092 e + e + 00 |是| | 13 e-01 | 6.943688 | 1.066 e-04 |2。326e-02 | OK | 9.319e+01 | 1.000e+00 | YES | | 14 | 6.943655e-01 | 9.324e-05 | 4.399e-02 | OK | 1.810e+02 | 1.000e+00 | YES | | 15 | 6.943603e-01 | 1.206e-04 | 8.823e-02 | OK | 4.609e+02 | 1.000e+00 | YES | | 16 | 6.943582e-01 | 1.701e-04 | 6.669e-02 | OK | 8.425e+01 | 5.000e-01 | YES | | 17 | 6.943552e-01 | 5.160e-05 | 6.473e-02 | OK | 8.832e+01 | 1.000e+00 | YES | | 18 | 6.943546e-01 | 2.477e-05 | 1.215e-02 | OK | 7.925e+01 | 1.000e+00 | YES | | 19 | 6.943546e-01 | 1.077e-05 | 6.086e-03 | OK | 1.378e+02 | 1.000e+00 | YES | |====================================================================================================| | ITER | FUN VALUE | NORM GRAD | NORM STEP | CURV | GAMMA | ALPHA | ACCEPT | |====================================================================================================| | 20 | 6.943545e-01 | 2.260e-05 | 4.071e-03 | OK | 5.856e+01 | 1.000e+00 | YES | | 21 | 6.943545e-01 | 4.250e-06 | 1.109e-03 | OK | 2.964e+01 | 1.000e+00 | YES | | 22 | 6.943545e-01 | 1.916e-06 | 8.356e-04 | OK | 8.649e+01 | 1.000e+00 | YES | | 23 | 6.943545e-01 | 1.083e-06 | 5.270e-04 | OK | 1.168e+02 | 1.000e+00 | YES | | 24 | 6.943545e-01 | 1.791e-06 | 2.673e-04 | OK | 4.016e+01 | 1.000e+00 | YES | | 25 | 6.943545e-01 | 2.596e-07 | 1.111e-04 | OK | 3.154e+01 | 1.000e+00 | YES | Infinity norm of the final gradient = 2.596e-07 Two norm of the final step = 1.111e-04, TolX = 1.000e-06 Relative infinity norm of the final gradient = 2.596e-07, TolFun = 1.000e-06 EXIT: Local minimum found.

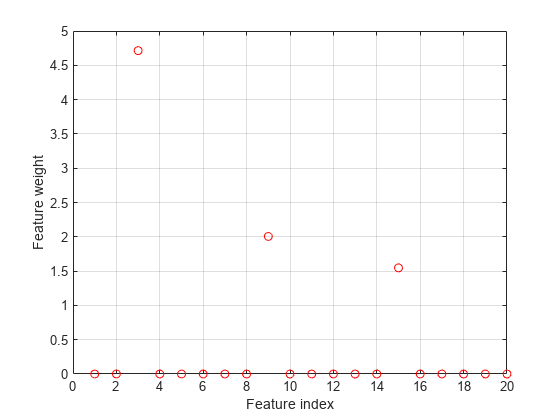

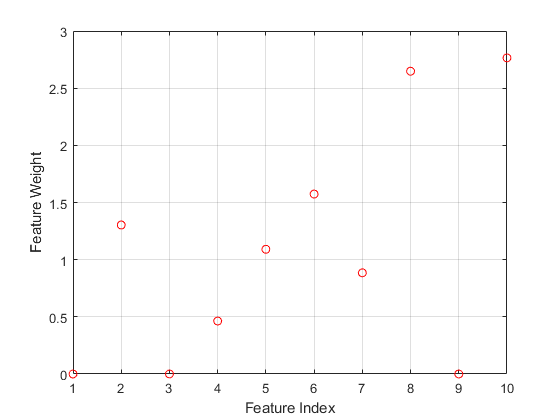

绘制选定的特征。不相关特征的权值应该接近于零。

图()图(mdl。FeatureWeights,“罗”) 网格在Xlabel(“功能指数”) ylabel (“功能重量”)

fsrnca正确检测此响应的相关预测器。

调整正则化参数的NCA回归

加载示例数据。

负载robotarm.mat

的robotarm(pumadyn32nm)数据集是使用一个机器人手臂模拟器创建的,具有7168个训练观测和1024个测试观测,具有32个特征[1][2]。这是原始数据集的预处理版本。数据经过减去线性回归拟合的预处理,然后将所有特征归一化到单位方差。

使用默认值进行邻域成分分析(NCA)特征选择 (正则化参数)的价值。

nca = fsrnca (Xtrain ytrain,“FitMethod”,“准确”,...“规划求解”,“lbfgs”);

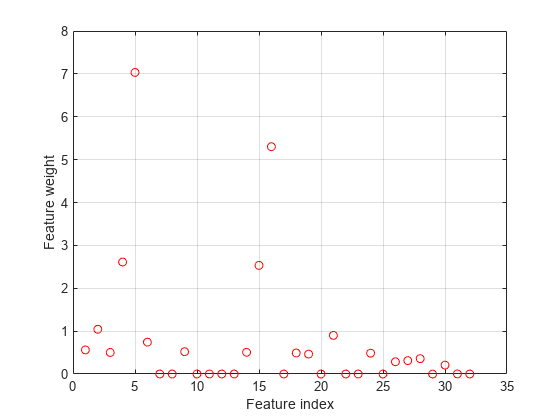

绘制选定的值。

图(nca阴谋。FeatureWeights,“罗”)包含(“功能指数”) ylabel (“功能重量”) 网格在

超过一半的特征权重是非零。使用所选功能使用测试设置计算丢失作为性能的度量。

L =损失(nca, Xtest欧美)

L = 0.0837

试着提高你的表现。调整正则化参数 使用五倍交叉验证进行特征选择。调优 意味着找到 产生最小回归损失的值。调优 使用交叉验证:

1.将数据分成5个部分。对于每一个褶皱,cvpartition指定4/5的数据作为训练集,1/5的数据作为测试集。

rng (1)重复性的%n =长度(ytrain);本量利= cvpartition(长度(ytrain),“kfold”5);numvalidsets = cvp.numtestsets;

分配

值的搜索。将响应值乘以一个常数使损失函数项增加常数的一个因子。因此,包括性病(ytrain)因素

值余额违约丢失功能('疯狂的',平均绝对偏差)项和目标函数中的正则化项。在这个例子中性病(ytrain)Factor是1,因为加载的样本数据是原始数据集的预处理版本。

lambdavals = linspace(0, 50岁,20)*性病(ytrain) / n;

创建一个数组来存储损失值。

lossvals = 0(长度(lambdavals), numvalidsets);

2.训练每个人的NCA模型 值,使用每个折叠中的训练集。

3.使用NCA模型计算折叠中相应测试集的回归损失。记录损失值。

4.对每一个重复此步骤 价值和每一折。

为i = 1:长度(lambdavals)为k = 1:numvalidsets X = Xtrain(cvp.training(k),:);y = ytrain (cvp.training (k):);Xvalid = Xtrain (cvp.test (k):);yvalid = ytrain (cvp.test (k):);nca = fsrnca (X, y,“FitMethod”,“准确”,...“规划求解”,“minibatch-lbfgs”,“λ”lambdavals(我),...“GradientTolerance”1的军医,“IterationLimit”, 30);lossvals (i (k) =损失(nca, Xvalid yvalid,“LossFunction”,'妈妈');结束结束

计算从每个折叠中获得的平均损失 价值。

meanloss =意味着(lossvals, 2);

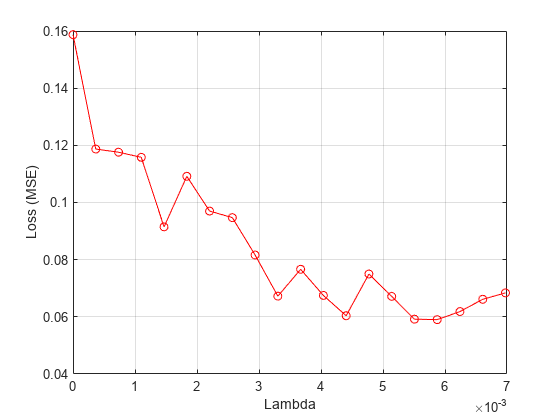

画出平均损失和 值。

图绘图(Lambdavals,Meanloss,'ro-')包含(“λ”) ylabel (“损失(MSE)”) 网格在

找到 给出最小损失值的值。

[~, idx] = min (meanloss)

Idx = 17.

bestlambda = lambdavals (idx)

bestlambda = 0.0059

bestloss = meanloss (idx)

bestloss = 0.0590

拟合NCA特征选择模型进行回归使用最佳 价值。

nca = fsrnca (Xtrain ytrain,“FitMethod”,“准确”,...“规划求解”,“lbfgs”,“λ”, bestlambda);

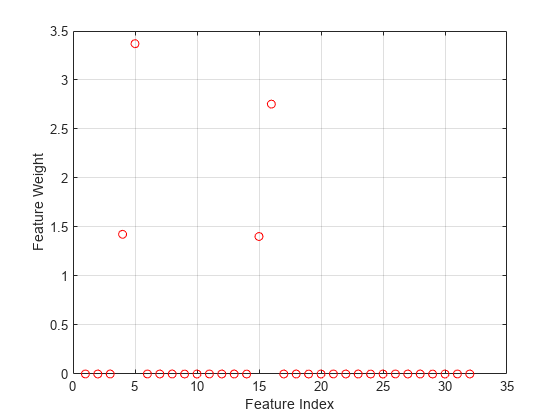

绘制选定的特征。

图(nca阴谋。FeatureWeights,“罗”)包含(“功能指数”) ylabel (“功能重量”) 网格在

大多数特征权重为零。fsrnca确定四个最相关的特征。

计算测试集的损失。

L =损失(nca, Xtest欧美)

L = 0.0571

调整正则化参数, ,消除了更多不相关的特性,提高了性能。

比较NCA和ARD特征选择

本例使用了鲍鱼数据[3][4]来自UCI机器学习知识库[5].下载数据并将其保存在当前文件夹中'abalone.data'.

将数据存储到表中。显示前7行。

台= readtable ('abalone.data',“文件类型”,“文本”,“ReadVariableNames”、假);tbl.Properties.VariableNames = {“性”,“长度”,'直径',“高度”,...“WWeight”,“SWeight”,“VWeight”,“ShWeight”,“NoShellRings”};台(1:7,:)

ans =.7×9表性长度直径高度WWeight SWeight VWeight ShWeight NoShellRings _____ ______ ________ ______ _______ _______ _______ ________ ____________ {' M} 0.455 0.365 0.095 0.514 0.2245 0.101 0.15 15{“M”}0.35 0.265 0.09 0.2255 0.0995 0.0485 0.07 7 {' F '} 0.53 0.42 0.135 0.677 0.2565 0.1415 0.21 9{“M”}0.44 0.365 0.125 0.516 0.2155 0.114 0.155十{' i '} 0.33 0.255 0.08 0.205 0.0895 0.0395 0.055 7 {' i '} 0.425 0.3 0.095 0.3515 0.141 0.0775 0.12 8 {' f '} 0.53 0.415 0.15 0.7775 0.237 0.1415 0.33 20

数据集有4177个观察。目标是从八个物理测量预测鲍鱼的年龄。最后变量,shell环的数量,显示了鲍鱼的年龄。第一预测器是一个分类变量。表中的最后一个变量是响应变量。

准备预测器和反应变量fsrnca.最后一栏资源描述包含shell rings的数量,即响应变量。第一个预测变量,性别是分类的。您必须创建虚拟变量。

y = table2array(资源描述(:,结束));X (:, 1:3) = dummyvar(分类(tbl.Sex));X = [X, table2array(资源描述(:,2:end-1)));

使用四倍交叉验证来调整NCA模型中的正则化参数。首先将数据分成4个部分。

rng (“默认”)重复性的%n =长度(y);本量利= cvpartition (n,“kfold”4);numtestsets = cvp.NumTestSets;

cvpartition将数据分成四个分区(折叠)。在每个折叠中,大约四分之三的数据被分配为训练集,四分之一被分配为测试集。

产生各种各样 (正则化参数)用于拟合模型以确定最佳的值 价值。创建一个向量以从每个拟合中收集损耗值。

lambdavals = linspace(0,25,20)* std(y)/ n;损失vals = zeros(长度(lambdavals),numtestsets);

的行lossvals对应于

值和列对应于折叠。

拟合NCA模型进行回归使用fsrnca从每个折叠中提取数据

价值。使用来自每个折叠的测试数据计算每个模型的丢失。

为i = 1:长度(lambdavals)为Xtrain = X(cvp.training(k),:);ytrain = y (cvp.training (k):);Xtest = X (cvp.test (k):);欧美= y (cvp.test (k):);nca = fsrnca (Xtrain ytrain,“FitMethod”,“准确”,...“规划求解”,“lbfgs”,“λ”lambdavals(我),'标准化',真正的);lossvals (i (k) =损失(nca, Xtest,欧美,“LossFunction”,'妈妈');结束结束

计算折叠的平均损失,即,计算第二维度的平均值lossvals.

meanloss =意味着(lossvals, 2);

绘图 值与四倍的平均损失。

图绘图(Lambdavals,Meanloss,'ro-')包含(“λ”) ylabel (“损失(MSE)”) 网格在

找到 使平均损失最小化的值。

[~, idx] = min (meanloss);bestlambda = lambdavals (idx)

bestlambda = 0.0071

计算最佳损失值。

bestloss = meanloss (idx)

bestloss = 4.7799

将NCA模型最好地贴合到所有数据上 价值。

nca = fsrnca (X, y,“FitMethod”,“准确”,“规划求解”,“lbfgs”,...'verbose',1,“λ”,bestlambda,'标准化',真正的);

o Solver = LBFGS, HessianHistorySize = 15,LineSearchMethod = weakwolfe |====================================================================================================| | ITER | |娱乐价值规范研究生| |规范一步曲线|γ|α|接受 | |====================================================================================================| | 0 e + 00 | 2.469168 | 1.266 e-01 |0.000 e + 00 | | 4.741 e + 0.000 e + 00 00 | |是| | 1 | 2.375166 e + 00 e-02 | 8.265 | 7.268 e-01 |好01 | 1.000 | 1.054 e + e + 00 |是| | 2 | 2.293528 e + 00 e-02 | 2.067 | 2.034 e + 00 |好01 | 1.000 | 1.569 e + e + 00 |是| | 3 | 2.286703 e + 00 e-02 | 1.031 | 3.158 e-01 |好01 | 1.000 | 2.213 e + e + 00 |是| | 4 | 2.279928 e + 00 e-02 | 2.023 | 9.374 e-01 | | 1.953 e + 01 |1.000 e + 00 |是| | 5 | 2.276258 e + e 03 00 | 6.884 | 2.497 e-01 |好01 | 1.000 | 1.439 e + e + 00 |是| | 6 | 2.274358 e + e 03 00 | 1.792 | 4.010 e-01 |好01 | 1.000 | 3.109 e + e + 00 |是| | 7 | 2.274105 e + e 03 00 | 2.412 | 2.399 e-01 |好01 | 1.000 | 3.557 e + e + 00 |是| | 8 | 2.274073 e + e 03 00 | 1.459 | 7.684 e-02 |好01 | 1.000 | 1.356 e + e + 00 |是| | |e-04 2.274050 e + 00 | 3.733 | 3.797 e-02 |好01 | 1.000 | 1.725 e + e + 00 |是| | 10 | 2.274043 e + 00 e-04 | 2.750 | 1.379 e-02 |好01 | 1.000 | 2.445 e + e + 00 |是| | 11 | 2.274027 e + 00 e-04 | 2.682 | 5.701 e-02 |好01 | 1.000 | 7.386 e + e + 00 |是| | 12 | 2.274020 e + 00 e-04 | 1.712 | 4.107 e-02 |好01 | 1.000 | 9.461 e + e + 00 |是| | 13 e + 00 | 2.274014 | 2.633 e-04 |6.720e-02 | OK | 7.469e+01 | 1.000e+00 | YES | | 14 | 2.274012e+00 | 9.818e-05 | 2.263e-02 | OK | 3.275e+01 | 1.000e+00 | YES | | 15 | 2.274012e+00 | 4.220e-05 | 6.188e-03 | OK | 2.799e+01 | 1.000e+00 | YES | | 16 | 2.274012e+00 | 2.859e-05 | 4.979e-03 | OK | 6.628e+01 | 1.000e+00 | YES | | 17 | 2.274011e+00 | 1.582e-05 | 6.767e-03 | OK | 1.439e+02 | 1.000e+00 | YES | | 18 | 2.274011e+00 | 7.623e-06 | 4.311e-03 | OK | 1.211e+02 | 1.000e+00 | YES | | 19 | 2.274011e+00 | 3.038e-06 | 2.528e-04 | OK | 1.798e+01 | 5.000e-01 | YES | |====================================================================================================| | ITER | FUN VALUE | NORM GRAD | NORM STEP | CURV | GAMMA | ALPHA | ACCEPT | |====================================================================================================| | 20 | 2.274011e+00 | 6.710e-07 | 2.325e-04 | OK | 2.721e+01 | 1.000e+00 | YES | Infinity norm of the final gradient = 6.710e-07 Two norm of the final step = 2.325e-04, TolX = 1.000e-06 Relative infinity norm of the final gradient = 6.710e-07, TolFun = 1.000e-06 EXIT: Local minimum found.

绘制选定的特征。

图(nca阴谋。FeatureWeights,“罗”)包含(“功能指数”) ylabel (“功能重量”) 网格在

无关的特征具有零重量。根据该图,未选择特征1,3和9。

采用回归子子集法进行参数估计,完全独立条件法进行预测,拟合高斯过程回归(GPR)模型。使用ARD平方指数核函数,它为每个预测者分配一个单独的权重。规范预测。

gprMdl = fitrgp(资源描述,“NoShellRings”,“KernelFunction”,'ardsquaredexponential',...“FitMethod”,“老”,“PredictMethod”,膜集成电路的,'标准化',真正的)

gprmdl = regressiongp predictornames:{'性'长度'直径''height'''wweight''sweight''vweight''shweight''shweight'} resportename:'noshellrings'pationoricalpricictors:1 respontefransform:'none'numobservations:4177 kernelfunction:'ARDSQUAREDExponential'内核信息:[1×1结构]基本功能:'常数'β:11.4959西格玛:2.0282预测:[10×1双]预测:[10×1双] alpha:[1000×1双] ActiveSetVectors:[1000×10 Double]预测:'FIC'Activesetsize:1000 FitMethod:'SR'ActiveSetMethod:'随机'isactiveSetVector:[4177×1逻辑] loglikelihie:-9.0019e + 03 ActiveSetory:[1×1 struct] Bcdinformation:[]属性,方法

计算培训模型的培训数据(重新扣除损失)上的回归损失。

l = RERUBLOS(GPRMDL)

L = 4.0306

最小的交叉验证损耗使用fsrnca与使用带有ARD核的探地雷达模型得到的损失相当。

输入参数

X- - - - - -预测变量值

n-经过-p矩阵

预测变量值,指定为n-经过-p矩阵,n观察的次数是多少p是预测变量的数量。

数据类型:单|双倍的

Y- - - - - -响应值

数字实际矢量长度n

响应值,指定为长度的数字实向量n, 在哪里n是观察人数。

数据类型:单|双倍的

名称-值对的观点

指定可选的逗号分隔的对名称,值论点。的名字参数名和价值为对应值。的名字必须出现在引号内。可以以任意顺序指定多个名称和值对参数Name1, Value1,…,的家.

'求解','sgd','重量',w,'lambda',0.0003指定求解器为随机梯度下降,观测权值为向量中的值W,并将正则化参数设置为0.0003。

“FitMethod”- - - - - -模型拟合方法

“准确”(默认)|“没有”|“平均”

模型拟合方法,指定为逗号分隔对组成“FitMethod”以及以下其中之一:

“准确”-使用所有数据进行拟合。“没有”——不合适。使用这个选项,使用调用fsrnca时提供的初始特征权值来评估NCA模型的泛化误差。“平均”—将数据划分为多个分区(子集),使用精确的方法,并返回特征权重的平均值。属性指定分区的数目NumPartitions名称-值对的论点。

例子:“FitMethod”、“没有”

'numpartitions'- - - - - -分区数量

马克斯(2分钟(10,n))(默认)|2和之间的整数n

用于分割数据的分区数目“FitMethod”、“平均”选项,指定为逗号分隔的配对组成'numpartitions'和2到之间的整数值n, 在哪里n是观察人数。

例子:“NumPartitions”,15

数据类型:双倍的|单

“λ”- - - - - -正则化参数

1/n(默认)|负的标量

正则化参数防止过拟合,指定为逗号分隔对组成“λ”一个非负标量。

作为观察的次数n增加,过拟合的机会减少,所需的正则化量也减少。看到调整正则化参数的NCA回归学习如何调优正则化参数。

例子:“λ”,0.002

数据类型:双倍的|单

“LengthScale”- - - - - -核宽

1(默认)|积极的真正标量

内核的宽度,指定为由逗号分隔的对组成“LengthScale”一个正的实标量。

当所有预测器在同一尺度上时,长度尺度值为1是合理的。如果预测因子在X具有非常不同的大小,然后考虑使用标准化预测值值“标准化”,真的和设置“LengthScale”,1.

例子:“LengthScale”,1.5

数据类型:双倍的|单

'InitialFeaturewuights'- - - - - -初始特征权重

(p,1)(默认)|p实正量的- × 1向量

初始特征权重,指定为逗号分隔对,由'InitialFeaturewuights'和一个p实正量的- × 1向量p为训练数据中预测器的个数。

优化特征权重的正则化目标函数是非凸的。因此,使用不同的初始特征权重可以得到不同的结果。将所有初始功能权重设置为1通常很有效,但在某些情况下,随机初始化使用兰特(p, 1)可以提供更好的质量解决方案。金宝搏官方网站

数据类型:双倍的|单

“重量”- - - - - -观察权重

n1s的-乘1向量(默认)|n实正量的- × 1向量

观察权值,指定为逗号分隔的对,由'观察重量'和一个n实正量的- × 1向量。使用观测权值来指定某些观测值比其他观测值更重要。默认权重对所有的观测值都赋予同等的重要性。

数据类型:双倍的|单

'标准化'- - - - - -用于标准化预测数据的指标

假(默认)|真正的

'verbose'- - - - - -冗长的水平指示器

0(默认)|1|> 1

用于显示收敛摘要的详细程度指示器,指定为逗号分隔对组成'verbose'以及以下其中之一:

0 -没有收敛总结

1 -收敛总结,包括梯度范数和目标函数值

> 1 -更多的收敛信息,取决于拟合算法

当使用

“minibatch-lbfgs”求解器和冗长级别> 1,收敛信息包括迭代来自中间微型批量LBFGS的日志。

例子:“详细”,1

数据类型:双倍的|单

“规划求解”- - - - - -解算器类型

“lbfgs”|“sgd”|“minibatch-lbfgs”

用于估计特征权重的求解器类型,指定为由逗号分隔的对组成“规划求解”以及以下其中之一:

“lbfgs”-有限内存Broyden-Fletcher-Goldfarb-Shanno (LBFGS)算法“sgd”-随机梯度下降(SGD)算法“minibatch-lbfgs”-随机梯度下降与LBFGS算法应用于小批量

默认是“lbfgs”为n≤1000,“sgd”为n> 1000。

例子:“规划求解”、“minibatch-lbfgs”

“LossFunction”- - - - - -损失功能

'疯狂的'(默认)|'妈妈'|“epsiloninsensitive”|函数处理

损失函数,指定为逗号分隔对组成“LossFunction”以及以下其中之一:

'疯狂的'-平均绝对偏差'妈妈'-均方误差“epsiloninsensitive”- ε不敏感损耗函数这种损失函数对异常值的鲁棒性比均方误差或平均绝对偏差更强。

@-自定义丢失功能处理。损失函数是这样的形式。lossfun函数L = lossfun (Yu青年志愿)%计算损失...

yu.是一个u1向量和yv.是一个v1的向量。l是一个u-经过-v损失值矩阵L (i, j)损失值是多少俞(i)和青年志愿(j).

最小化的目标函数包括损耗功能l(y我,yj)如下:

在哪里w是特征权重矢量,n是观察的次数,和p是预测变量的数量。pij是xj参考点是什么x我.有关详细信息,请参阅回归的NCA特征选择.

例子:LossFunction, @lossfun

‘ε’- - - - - -ε值

差(Y) / 13.49(默认)|非负实数

值“LossFunction”、“epsiloninsensitive”选项,指定为逗号分隔的配对组成“LossFunction”和一个非负真正的标量。默认值是使用响应变量的四分位数范围的示例标准偏差的估计。

例子:‘ε’,0.1

数据类型:双倍的|单

“CacheSize”- - - - - -内存大小

1000 mb(默认)|整数

用于目标函数和梯度计算的内存大小,以MB为单位,指定为逗号分隔对组成“CacheSize”和一个整数。

例子:“CacheSize”,1500 mb

数据类型:双倍的|单

“HessianHistorySize”- - - - - -用于Hessian近似的历史缓冲区的大小

15(默认)|正整数

历史缓冲区的大小为Hessian近似“lbfgs”求解器,指定为逗号分隔的对组成“HessianHistorySize”一个正整数。在每次迭代中,函数使用最新的Hessianhistorysize.迭代来建立逆Hessian的近似。

例子:“HessianHistorySize”,20

数据类型:双倍的|单

“InitialStepSize”- - - - - -初始步长

“汽车”(默认)|积极的真正标量

的初始步长“lbfgs”求解器,指定为逗号分隔的对组成“InitialStepSize”一个正的实标量。默认情况下,该函数自动确定初始步长。

数据类型:双倍的|单

“LineSearchMethod”- - - - - -线搜索方法

“weakwolfe”(默认)|“strongwolfe”|“回溯”

行搜索方法,指定为逗号分隔对组成“LineSearchMethod”以及以下其中之一:

“weakwolfe”-弱沃尔夫线搜索“strongwolfe”-强沃尔夫线搜索“回溯”-回溯线搜索

例子:“LineSearchMethod”、“回溯”

“MaxLineSearchIterations”- - - - - -最大行搜索迭代次数

20.(默认)|正整数

最大行搜索迭代次数,指定为逗号分隔对组成“MaxLineSearchIterations”一个正整数。

例子:“MaxLineSearchIterations”,25岁

数据类型:双倍的|单

“GradientTolerance”- - - - - -相对收敛耐受性

1 e-6(默认)|积极的真正标量

求解器梯度范数的相对收敛容限lbfgs,指定为逗号分隔的对,由“GradientTolerance”一个正的实标量。

例子:'gradienttolerance',0.000002

数据类型:双倍的|单

“InitialLearningRate”- - - - - -初始学习率“sgd”解算器

“汽车”(默认)|积极的真正标量

初始学习率“sgd”求解器,指定为逗号分隔的对组成“InitialLearningRate”一个正的实标量。

使用求解器类型时“sgd”,学习速率衰减在指定的值开始的迭代上“InitialLearningRate”.

默认的“汽车”意味着初始学习率是通过对小数据子集进行实验来确定的。使用NumTuningIterations参数的名称-值对指定自动调优初始学习率的迭代次数。使用TuningSubsetSize名称-值对参数,指定用于自动调优初始学习率的观察数。

解算器类型“minibatch-lbfgs”,您可以设置“InitialLearningRate”一个非常高的值。在这种情况下,该函数将LBFGS分别应用于每个小批,并使用前一个小批的初始特征权重。

为了确保所选的初始学习率随着每次迭代而降低目标值,绘制迭代兑客观的保存在mdl.fitinfo.财产。

你可以使用改装方法'InitialFeaturewuights'等于mdl。FeatureWeights从当前解决方案开始并运行其他迭代

例子:“InitialLearningRate”,0.9

数据类型:双倍的|单

“MiniBatchSize”- - - - - -每个批量使用的观察数“sgd”解算器

分钟(10,n)(默认)|正整数,取值范围为1 ~n

每个批量使用的观察数“sgd”求解器,指定为逗号分隔的对组成“MiniBatchSize”一个正整数,从1到n.

例子:“MiniBatchSize”,25岁

数据类型:双倍的|单

“PassLimit”- - - - - -求解器的最大通道数“sgd”

5(默认)|正整数

全部全部通过的最大次数n观察对解算器“sgd”,指定为逗号分隔的对,由“PassLimit”一个正整数。所有数据的每一遍被称为epoch。

例子:“PassLimit”,10

数据类型:双倍的|单

'numprint'- - - - - -显示聚合摘要的批次频率

10(默认)|正整数的值

显示聚合摘要的批次的频率“sgd”解算器,指定为逗号分隔的对,由'numprint'一个正整数。这个论点适用于'verbose'值大于0。NumPrint对命令行显示的收敛摘要的每一行进行mini-batch处理。

例子:“NumPrint”,5

数据类型:双倍的|单

“NumTuningIterations”- - - - - -优化迭代次数

20.(默认)|正整数

的调优迭代次数“sgd”求解器,指定为逗号分隔的对组成“NumTuningIterations”一个正整数。此选项仅对“InitialLearningRate”、“汽车”.

例子:“NumTuningIterations”,15

数据类型:双倍的|单

'调整aubsetsize'- - - - - -用于调整初始学习率的观察数

分钟(100n)(默认)|正整数,取值范围为1 ~n

用于调优初始学习率的观察数,指定为逗号分隔对组成'调整aubsetsize'以及1到1的正整数值n.此选项仅对“InitialLearningRate”、“汽车”.

例子:“TuningSubsetSize”,25岁

数据类型:双倍的|单

“IterationLimit”- - - - - -最大迭代次数

正整数

最大迭代次数,由逗号分隔对组成“IterationLimit”一个正整数。缺省情况下,SGD为10000,LBFGS和mini-batch LBFGS为1000。

每次批处理都是一次迭代。所有数据的每一次传递都是一个纪元。如果将数据分成k迷你批次,那么每一个时代都相当于k迭代。

例子:“IterationLimit”,250年

数据类型:双倍的|单

“StepTolerance”- - - - - -步长收敛公差

1 e-6(默认)|积极的真正标量

步骤大小的融合公差,指定为逗号分隔对组成“StepTolerance”一个正的实标量。的“lbfgs”求解器使用绝对步长公差,并且“sgd”求解器使用相对步长公差。

例子:“StepTolerance”,0.000005

数据类型:双倍的|单

“MiniBatchLBFGSIterations”- - - - - -每个小批LBFGS步骤的最大迭代次数

10(默认)|正整数

每个小批LBFGS步骤的最大迭代次数,指定为逗号分隔对组成“MiniBatchLBFGSIterations”一个正整数。

例子:“MiniBatchLBFGSIterations”,15

小批LBFGS算法是SGD和LBFGS算法的结合。因此,适用于SGD和LBFGS求解器的所有名称-值对参数也适用于迷你批处理LBFGS算法。

数据类型:双倍的|单

输出参数

mdl-邻域成分分析模型的回归

PeazereSentionncarebortion对象

邻域成分分析模型进行回归,返回为PeazereSentionncarebortion对象。

参考文献

Rasmussen, c.e., R. M. Neal, G. E. Hinton, D. van Campand, M. Revow, Z. Ghahramani, R. Kustra, R. Tibshirani。《DELVE手册》,1996,http://mlg.eng.cam.ac.uk/pub/pdf/RasNeaHinetal96.pdf。

[2]计算机科学部多伦多大学。delve datasets。http://www.cs.toronto.edu/~delve/data/datasets.html。

纳什、w.j.、t.l.塞勒斯、s.r.塔尔博特、a.j.考索恩和w.b.福特。鲍鱼的种群生物学(石决明物种)的塔斯马尼亚岛。I.黑唇鲍鱼(h . rubra)从北海岸和巴斯海峡群岛。”海洋渔业司,技术报告第48号,1994年。

[4]沃,S。串级相关的扩展和基准:前馈监督人工神经网络的串级相关体系结构和基准的扩展。塔斯马尼亚大学计算机科学系毕业论文, 1995年。

[5] Lichman, m.l UCI机器学习知识库。加州欧文:加州大学信息与计算机科学学院,2013。http://archive.ics.uci.edu/ml。

matlab命令

你点击一个链接对应于这个MATLAB命令:

通过在MATLAB命令窗口中输入命令来运行命令。Web浏览器不支持MATLAB命令。金宝app

你也可以从以下列表中选择一个网站:

如何获得最佳的网站性能

选择中国网站(中文或英文)以获得最佳网站性能。其他MathWorks国家站点没有针对您所在位置的访问进行优化。