trainYOLOv2ObjectDetector

火车yolo v2对象探测器

语法

描述

火车一个检测器

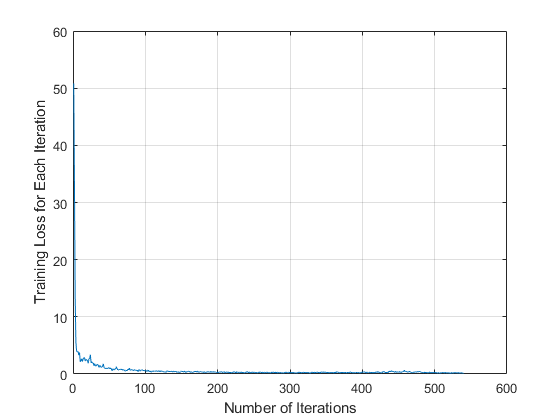

探测器= trainyolov2objectdetector(trainingData,LGRAPH.,选项)LGRAPH.这个选项输入指定检测网络的训练参数。

恢复训练探测器

探测器= trainyolov2objectdetector(trainingData,检查站,选项)

你可以使用这个语法:

添加更多的训练数据并继续训练。

提高通过增加迭代的最大数量的训练精度。

微调检测器

探测器= trainyolov2objectdetector(trainingData,探测器,选项)

例子

输入参数

输出参数

更多关于

提示

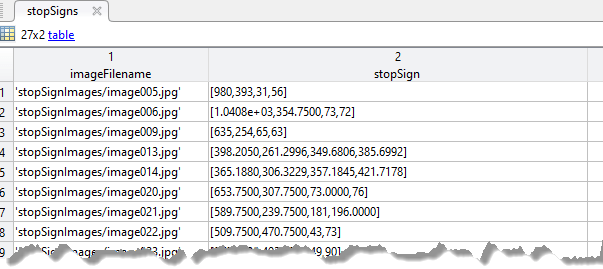

要生成地面真相,请使用图片标志或者贴标签机视频应用程序。若要从产生地面实况训练数据表,使用

objectDetectorTrainingData函数。为了提高预测精度,,

增加可以用于训练网络的图像数量。您可以通过数据增强来扩展训练数据集。有关如何将数据增强应用于预处理的信息,请参见深度学习的图像预处理(深学习工具箱).

进行多尺度训练

trainYOLOv2ObjectDetector函数。要做到这一点,指定'TeacherivageSize.'的论点trainYOLOv2ObjectDetector培训网络的功能。选择适合于数据集的锚框以培训网络。你可以使用

extimateanchorboxes.函数直接从训练数据计算锚盒。

工具书类

[1]约瑟。R, S. K. Divvala, R. B. Girshick和F. Ali。“你只看一次:统一的、实时的物体检测。”在在IEEE会议计算机视觉与模式识别(CVPR)论文集,第779-788页。内华达州拉斯维加斯:CVPR,2016年。

[2]约瑟。R和f。“YOLO 9000:更好、更快、更强。”在在IEEE会议计算机视觉与模式识别(CVPR)论文集, 6517 - 6525页。檀香山,HI: CVPR, 2017。

另请参阅

应用

功能

objectDetectorTrainingData|trainFasterRCNNObjectDetector|trainFastRCNNObjectDetector|trainrcnnobjectdetector|yolov2Layers|培训选项(深学习工具箱)