基于深度学习的HRTF模型优化

空间音频速成班

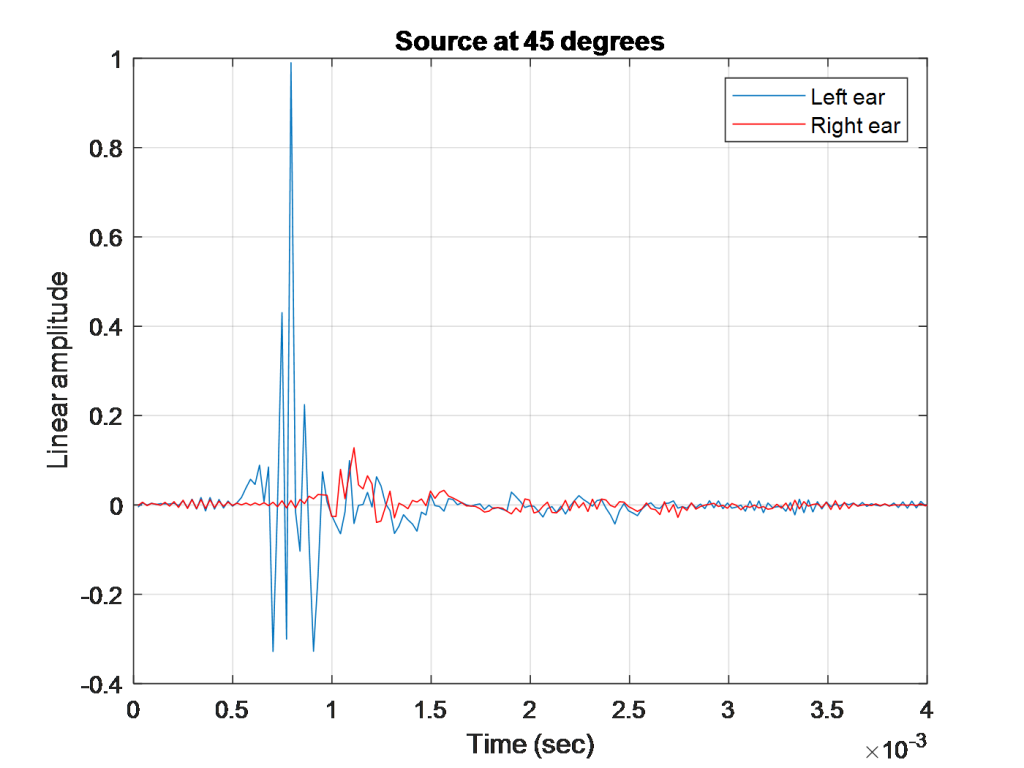

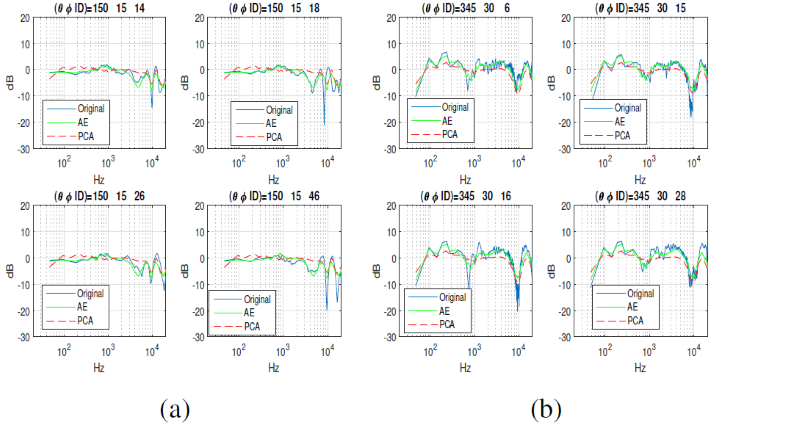

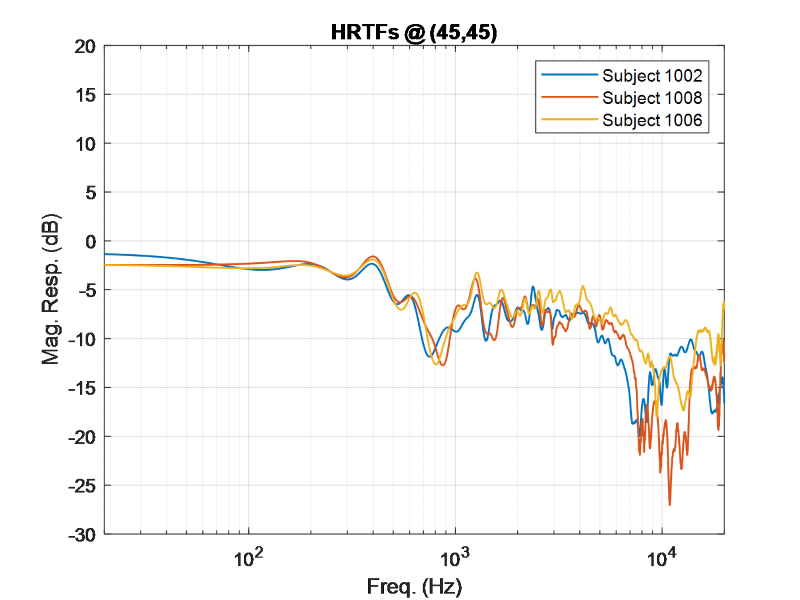

这项研究的一个重要方面是声音的定位。这在音频应用中得到了广泛的研究,与我们人类如何听到和理解声音的来源有关。这因人而异,但通常与每只耳朵(低于~ 800hz)的延迟和频率大于~ 800hz时每只耳朵的频谱细节有关。这些主要是我们在日常工作中用来定位声音的线索鸡尾酒会效应).下图显示的是头部相关冲动反应在人类受试者的双耳道入口的消声室中测量(左图),以及傅里叶域表示,即头部相关传递函数(右图),它显示了人在可听到频率的特定位置(例如,向左和正面45度,仰角0度)的双耳是如何听到声音的。 |

|

- 人类非常善于发现声音中的差异,这些差异看起来是假的,会给用户带来不真实的体验。

- 头部相关的传递函数在各个角度上对不同的人是不同的。

- 每个HRTF都是方向相关的,对任何特定的人来说,每个角度都会有所不同。

目前的技术水平和我们的新方法

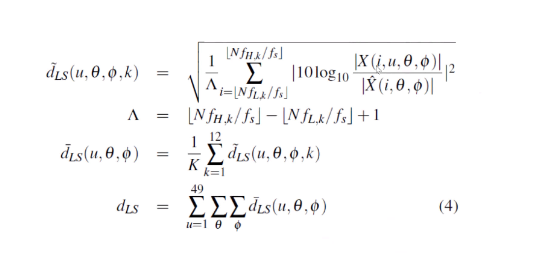

你可能会问“如果每个人都不一样,为什么不取所有图的平均值,然后创建一个平均HRTF呢?”对此,我说“如果你取平均值,你只会得到一个平均的结果。”深度学习能帮助我们提高平均水平吗?在我们的研究之前,执行该分析的主要方法是对一组人进行HRTF建模的主成分分析。在过去,研究人员已经发现5或6个组件被用于大约20个主题的小型测试集([1][2][3]),但我们希望在更大的数据集和更多的角度上进行泛化。我们将展示一种使用深度学习的新方法。我们将把它应用到使用非线性函数学习hrtf的低维表示(潜在表示)的自编码器方法中,然后使用另一个网络(在这种情况下是广义回归神经网络)将角度映射到潜在表示。我们从1个隐藏层的自编码器开始,然后通过使用验证度量(对数谱失真度量)进行贝叶斯优化,优化隐藏层的数量和高斯RBF在GRNN中的扩散。下一节将详细介绍这种新方法。新方法

对于我们的方法,我们使用的是IRCAM数据集,该数据集由49个主题组成,每个主题有115个声音方向。我们将使用一个自编码器模型,并将其与主成分分析模型(这是一个以PC数量为条件的线性最优解)进行比较,我们将使用对数光谱失真度量进行客观比较来比较性能。数据设置

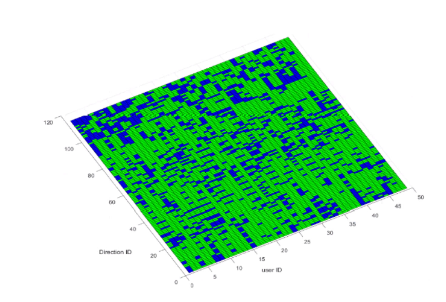

正如我提到的,数据集有49个主题,115个角度,每个HRTF是通过计算1024个频率箱的FFT创建的。问题陈述:我们能否为每个角度找到一个HRTF表示,使该角度与所有主题的拟合最大化?我们本质上是在寻找最好的概化,对于所有的主题,对于115个角度中的每一个。- 我们还对深度学习模型使用了超参数调优(bayesopt)。

- 我们使用整个HRTF数据集(1024X5635)并训练自动编码器。隐藏层的输出为您提供了输入数据的紧凑表示。我们使用自编码器,我们提取它的表示然后用广义RNN将它映射回角度。我们还为每个角度和每个主题添加抖动或噪音。这将有助于网络泛化而不是过度拟合,因为我们并不是在寻找完美的答案(这是不存在的!),而是最适合所有测试对象的泛化。

- 贝叶斯优化用于:

- 自编码器网络的大小(层数)

- 添加到每个角度的抖动/噪声方差

- RBF扩展为GRNN

结果

我们优化了对数谱失真来确定结果:

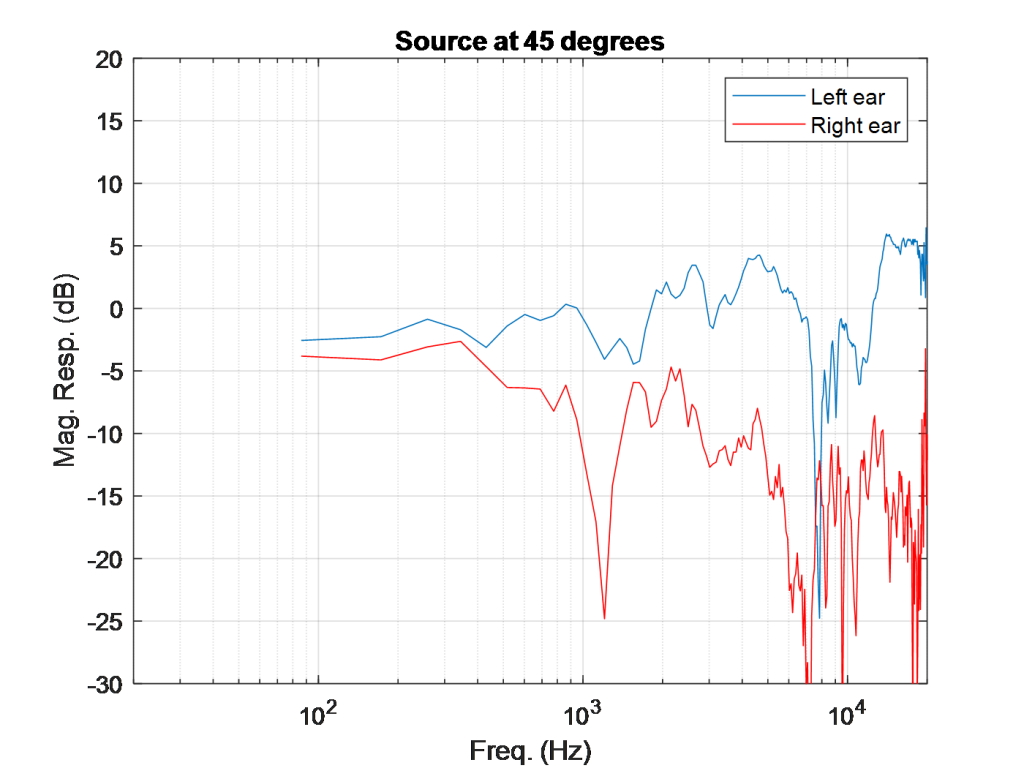

pca顺序的选择(横坐标:no。(a)左耳(b)右耳)

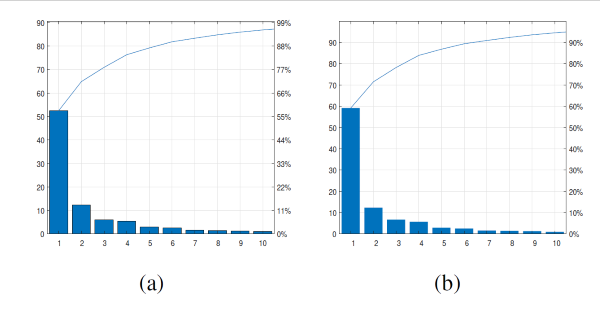

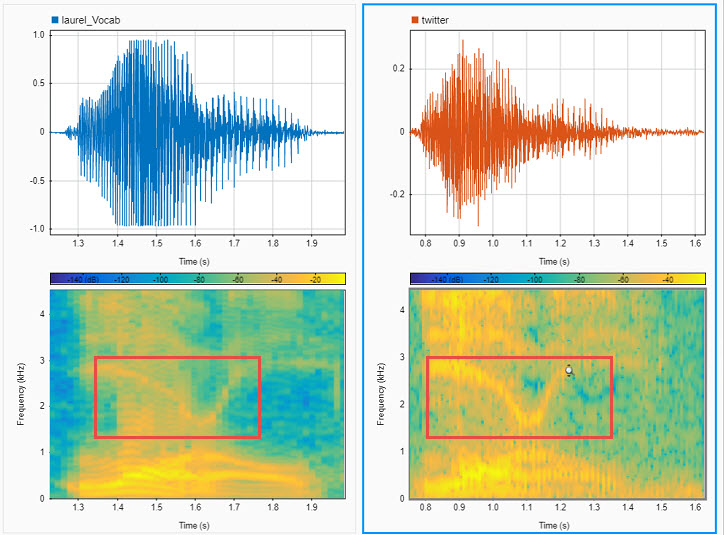

使用ae模型(绿色)与真实HRTF(蓝色)进行左耳HRTF重建比较的例子。PCA模型用作锚点,显示为红色。

参考文献

[1] D. Kistler和F. Wightman,“基于主成分分析和最小相位重建的头部相关传递函数模型”,J. Acoust。Soc。阿米尔。,vol. 91(3), 1992, pp. 1637-1647.[2]马滕斯,“光谱线索的主成分分析与感知方向的再合成”,中国科学技术大学学报(自然科学版)。广告样稿,亩。Conf. 1987, pp. 274-281。[3] J. Sodnik, A. Umek, R. Susnik, G. Bobojevic和S. Tomazic,“头部相关传递函数的主成分分析表示”,声学,2004年11月。- カテゴリ:

- 深度学习

克利夫角:克利夫莫勒的数学和计算

克利夫角:克利夫莫勒的数学和计算 罗兰谈MATLAB的艺术

罗兰谈MATLAB的艺术 用MATLAB进行图像处理

用MATLAB进行图像处理 Simulin金宝appk上的Guy

Simulin金宝appk上的Guy 深度学习

深度学习 开发区域

开发区域 Stuart的MATLAB视频

Stuart的MATLAB视频 头条新闻背后

头条新闻背后 本周文件交换选择

本周文件交换选择 汉斯谈物联网

汉斯谈物联网 学生休息室

学生休息室 创业公司、加速器和企业家

创业公司、加速器和企业家 MATLAB社区

MATLAB社区 Matlabユザコミュニティ

Matlabユザコミュニティ

コメント

コメントを残すには,ここをクリックしてMathWorksアカウントにサインインするか新しいMathWorksアカウントを作成します。