主要内容

小公子

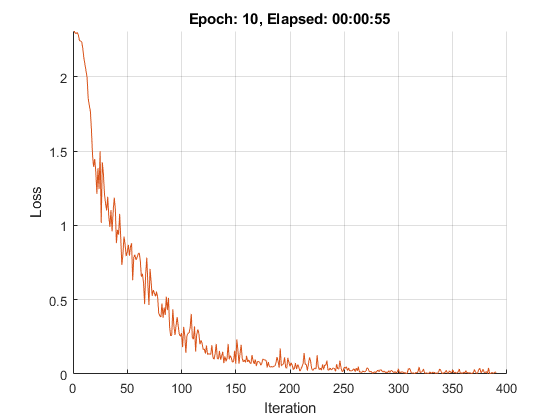

为深度学习创建小批量

描述

使用小公子用于创建,预处理和管理Mini-Batch的数据以进行培训,用于使用自定义培训循环进行培训。

一个小公子对象在数据存储上迭代,以使用自定义训练循环以适当的格式提供用于训练的数据。对象准备一个按需预处理的小批量队列。使用小公子对象来自动将数据转换为dlarray.要么GPUArray.,将数据转换为其他精度,或应用自定义函数预处理数据。您可以在后台并行准备数据。

在培训期间,您可以使用该数据管理您的数据小公子对象。可以在每个训练时期开始时使用洗牌函数,并为每个训练迭代从队列中收集数据下一个功能。您可以使用hasdata功能,重置它是空的队列。

创建

描述

MBQ.= minibatchqueue(ds,numoutput.)小公子来自输入数据存储的对象ds并设置每个迷你批处理中的变量数。使用时使用此语法MiniBatchFcn指定一个小批量预处理函数,该函数的输出数与输入数据存储的变量数不同ds.

MBQ.= minibatchqueue(___,名称,值)Minibatchqueue(DS,“Minibatchsize”,64,“PartialMinibatches”,“丢弃”)将返回的小批量的大小设置为64,并丢弃任何小于64个观察值的小批量。

输入参数

特性

对象的功能

例子

另请参阅

介绍了R2020b