主要内容

rlDQNAgent

深度q -网络强化学习代理

描述

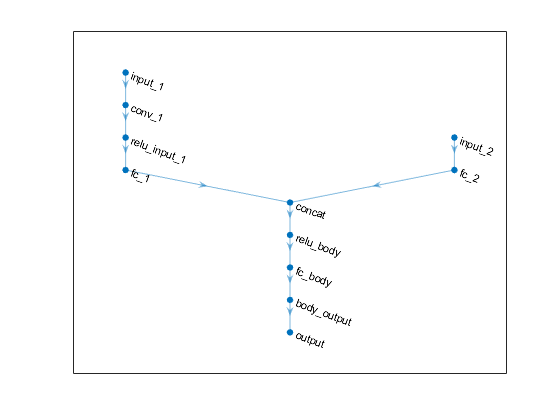

Deep Q-Network(DQN)算法是一种无模型,在线,禁止策略强化学习方法。DQN代理是一个基于价值的强化学习代理,可以训练批准批评奖励或未来奖励。DQN是Q-Learning的变体,它仅在离散动作空间内运行。

有关更多信息,深度Q-Network代理商.有关不同类型的强化学习代理商的更多信息,请参阅强化学习代理.

创建

语法

描述

从观察和行动规范创建代理

代理= rlDQNAgent (observationInfo,actionInfo)observationInfo以及动作规范actionInfo.

代理= rlDQNAgent (observationInfo,actionInfo,初学者)初学者对象。有关初始化选项的更多信息,请参见rlAgentInitializationOptions.

从评论家表示创建代理

代理= rlDQNAgent (评论家)

输入参数

特性

对象的功能

例子

介绍了R2019a