TreeBagger

班级:TreeBagger

创建决策树包

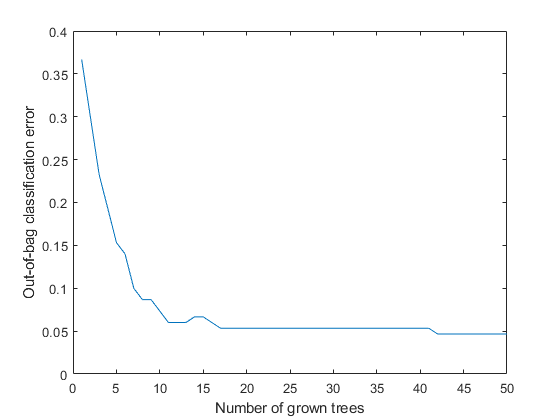

单个决策树倾向于过度拟合。Bootstrap-aggregated (袋装)决策树结合大量的决策树,从而降低过度拟合的效果,提高了泛化的结果。TreeBagger使用数据的引导样本在集成中生长决策树。同时,TreeBagger选择预测器的随机子集在每个决定分割使用如随机森林算法[1].

默认情况下,TreeBagger包分类树。要打包回归树,请指定“方法”,“回归”.

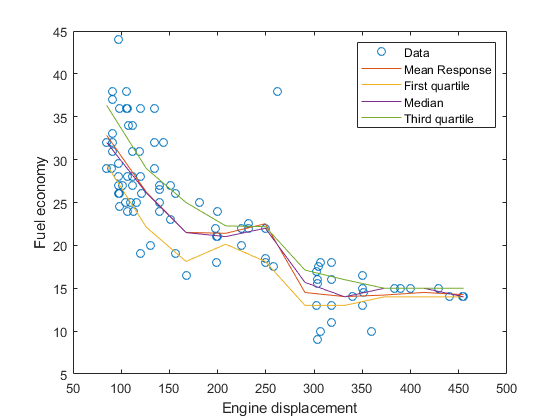

对于回归问题,TreeBagger金宝app支持均值和大分回归(即定量回归森林[5])。

句法

ResponseVarName Mdl = TreeBagger (NumTrees(资源)

Mdl = TreeBagger (NumTrees、资源描述、公式)

mdl = treebagger(numtrees,tbl,y)

B = TreeBagger (NumTrees, X, Y)

B = TreeBagger (NumTrees, X, Y,名称,值)

描述

Mdl= TreeBagger (NumTrees,TBL.,responsevarname.)NumTrees使用表中样本数据训练的袋装分类树TBL..responsevarname.是在响应变量的名称TBL..

Mdl= TreeBagger (NumTrees,TBL.,公式)TBL..公式是否有一个反应的解释模型和一个预测变量子集TBL.适合使用Mdl.指定公式使用Wilkinson表示法。有关更多信息,请参见Wilkinson表示法.

Mdl= TreeBagger (NumTrees,TBL.,Y)TBL.和类别标签在矢量Y.

Y是响应数据数组。的元素Y对应于的行TBL..分类,Y是一组真正的类标签。标签可以是任何分组变量,即数字或逻辑向量、字符矩阵、字符串数组、字符向量单元格数组或分类向量。TreeBagger标签转换为字符向量的单元阵列。对于回归,Y是一个数字向量。要生成回归树,必须指定名称-值对“方法”,“回归”.

B= TreeBagger (NumTrees,X,Y)B的NumTrees用于预测响应的决策树Y作为预测的在训练数据的数字矩阵的函数,X.在每一行X表示一个观察结果,每一列表示一个预测器或特征。

B = TreeBagger (NumTrees, X, Y,名称,值)指定可选参数名称-值对:

“InBagFraction” |

输入数据的分数与从用于生长每个新树中的输入数据的替换样品。默认值是1。 |

'成本' |

方阵 或者,

默认值为 如果 |

“SampleWithReplacement” |

“上”取样用替换或'离开'无需更换采样。如果您品尝无需更换,需要设置“InBagFraction”小于1的值。默认是“上”. |

“OOBPrediction” |

“上”存储的信息是什么观测袋每个树出来。这个信息可以通过使用oobPrediction来计算预测的类概率在合奏每个树。默认是'离开'. |

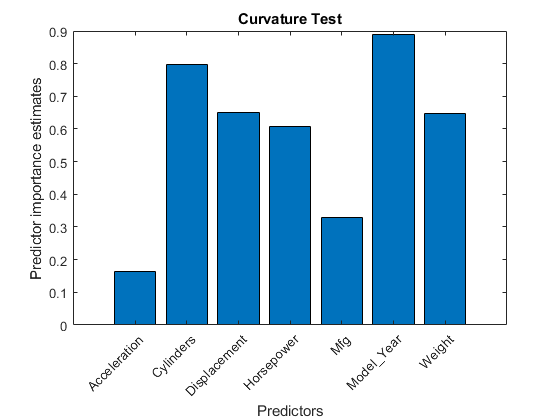

'Oobpredictorimportance' |

“上”存储在整体功能的重要性了球袋估计。默认是'离开'.指定“上”还设置了“OOBPrediction”价值“上”.如果预测器的重要性分析是您的目标,那么也要指定'PredictorSelection', '弯曲'或“PredictorSelection”,“相互作用曲率”.有关更多详细信息,请参阅fitctree或fitrtree. |

“方法” |

任何一个'分类'或'回归'.回归需要一个数字Y. |

“NumPredictorsToSample” |

对于每个决策拆分,随机选择的变量数。默认是分类的变量数的平方根,以及回归数量的三分之一。有效值是'全部'或者一个正整数。将此参数设置为任何有效值,但是'全部'调用Breiman的随机森林算法[1]. |

“NumPrint” |

培训周期数(成年树)之后,TreeBagger显示诊断消息,显示培训进度。默认值是没有诊断消息。 |

'minleafsize' |

每片树叶的最低观察次数。默认值是1表示分类,5表示回归。 |

'选项' |

一种结构,它指定在增长决策树集合时控制计算的选项。一个选项要求在多个引导复制上的决策树计算使用多个处理器,如果并行计算工具箱™可用的话。两个选项指定在选择引导复制时使用的随机数流。可以通过调用来创建此参数

|

'事先的' |

每个班级的先前概率。指定为以下之一:

如果您为两者设置值 如果 |

“PredictorNames” |

预测器变量名,指定为逗号分隔的一对组成的

|

“CategoricalPredictors” |

分类预测列表中,指定为逗号分隔的一对组成的

|

ChunkSize的 |

块大小,指定为逗号分隔对,由 笔记 此选项仅适用于使用时 |

除了上面的可选参数,TreeBagger接受这些可选fitctree和fitrtree论点。

金宝app支持fitctree争论 |

金宝app支持fitrtree争论 |

|---|---|

AlgorithmForCategorical |

MaxNumSplits |

MaxNumCategories |

MergeLeaves |

MaxNumSplits |

预测互联 |

MergeLeaves |

修剪 |

预测互联 |

PruneCriterion |

修剪 |

QuadraticErrorTolerance |

PruneCriterion |

SplitCriterion |

SplitCriterion |

代理 |

代理 |

权重 |

“重量” |

例子

提示

通过设置更平衡的误分类代价矩阵或更少扭曲的先验概率向量,避免估计出的较大的包外误差方差。

的

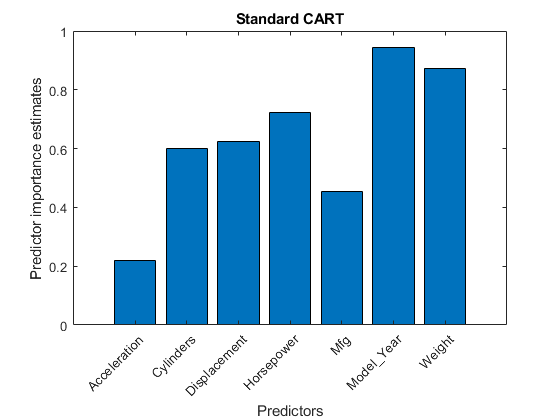

树木财产B存储的单元阵列B.NumTreesCompactClassificationTree或CompactRegressionTree模型对象。用于树的文本或图形显示t在单元格数组中,输入视图(B.Trees {t})标准CART倾向于选择包含在含有几个不同的值,例如,分类变量那些许多不同的值,例如,连续的变量,分裂的预测[4].如果下列任意一个为真,考虑指定曲率或交互测试:

如果存在具有比其他预测相对较少不同的值,例如,如果预测的数据集是异质的预测因子。

如果对预测的重要性分析是您的目标。

TreeBagger商店预测的重要性估计OobpermutedPredictordeltaError财产Mdl.

算法

另类功能

Statistics and Machine Learning Toolbox™提供了三种对象用于套袋和随机森林:

TreeBagger由...制作TreeBagger用于分类和回归

有关之间差异的详细信息TreeBagger和袋装合奏(ClassificationBaggedensemble.和RegressionBaggedEnsemble),看套袋式和套袋式的比较.

参考

[1] Breiman, L。随机森林。机器学习45,pp. 5-32, 2001。

[2] Breiman, L., J. Friedman, R. Olshen, C. Stone。分类与回归树.佛罗里达州Boca Raton:CRC出版社,1984年。

[3] LOH,W.Y.“具有无偏的变量选择和相互作用检测的回归树。”STATISTICA SINICA.,卷。12,2002年,第361-386。

[4]蕙,W.Y.和Y.S.施。“拆分选择方法对于分类树”。STATISTICA SINICA., 1997年第7卷,第815-840页。

[5] Meinshausen,N“位数回归森林”。杂志的机器学习研究的,卷。7,2006年,第983-999。