机器人通过强化学习快速学会走路

来自南加州大学的研究人员团队valero实验室建造了一个相对简单的机器人肢体,完成了惊人的东西:3斯托,2个联合机器人腿教授如何移动。是的,通过试验和错误自主学习。

该团队由Francisco Valero-Cuevas教授和博士生Ali Marjaninejad领导。他们的研究被刊登在3月号的封面上自然机器智能.

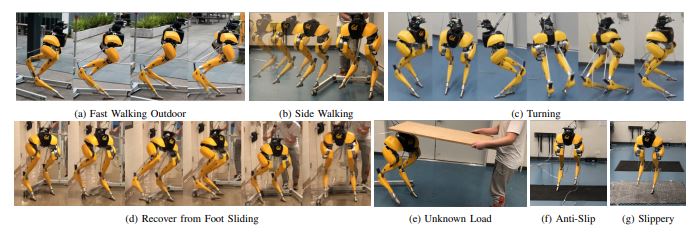

机器人的肢体不是为特定的任务而编程的。它首先通过模拟自己的动态特性进行自主学习,然后使用一种被称为强化学习的人工智能(AI)。这种机器腿可以在几分钟内学会自己移动,而不是花上几周的时间编写代码。

灵感来自大自然

长期以来,机器人专家一直受到大自然的启发,因为,让我们面对现实吧,大自然母亲花了很长时间来完善她的设计。今天,我们看到机器人走路像蜘蛛和水下机器人灵感来自海蛇.

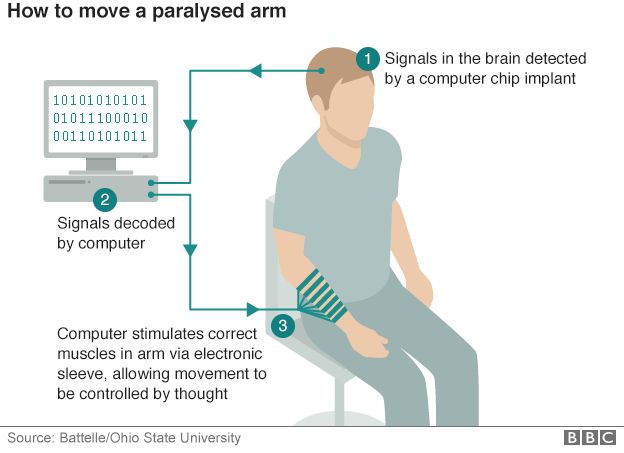

生物悬浮液也会影响机器人“思考”的方式,感谢您对生物体的神经系统流程信息进行了模仿的AI。例如,人工神经网络(ANNS)已经过去复制昆虫的脑结构提高手写数字的计算机识别。

对于这个项目,该设计从大自然中提出了它的提示,两者都是为了腿部的物理设计和帮助腿部“学习”走路的AI。对于物理设计,这种机器人腿使用肌腱架构,就像肌肉和肌腱结构一样,能够动力动物的运动。AI也从自然中汲取灵感,使用ANN帮助机器人学习如何控制其动作。然后,强化学习利用了对动态的理解来实现走在跑步机上的目标。

强化学习和“摩托车”

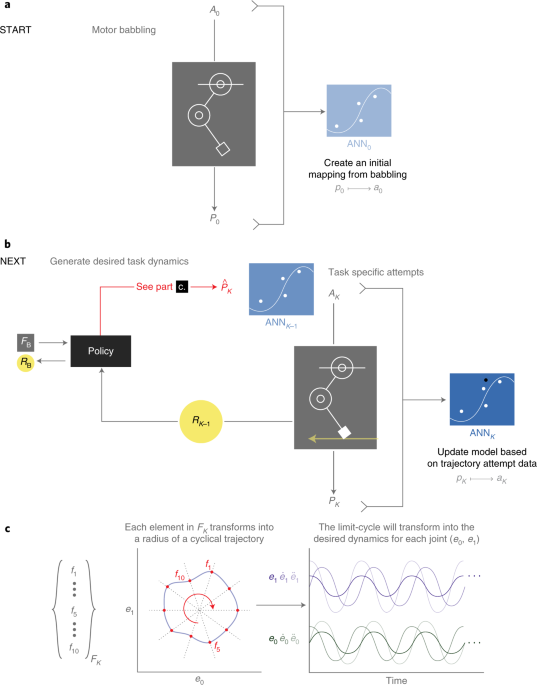

通过将运动胡言乱语与强化学习相结合,系统尝试随机运动,并通过运动结果学习系统的特性。在这项研究中,研究小组首先让系统随机播放,或让它的运动咿呀学语,以了解肢体的属性和动态。

在A.采访个人电脑杂志,Marjaninejad陈述了“然后,我们每次涉及到一个特定任务的良好表现时都会获得奖励。在这种情况下,向前移动跑步机。这被称为加强学习,因为它类似于动物对积极加强的方式。“

得到的算法称为G2P,(常规到特定)。它通过从肌腱移动肢体时的运动来控制肢体时,复制生物神经系统面部的“一般”问题。接下来的是加强(奖励)“特别”的行为。在这种情况下,任务成功地移动了跑步机。该系统通过Motor Babbly创建了“一般”了解其动态,然后通过从各种经验或G2P学习来掌握所需的“特定”任务。

结果令人印象深刻。G2P算法可以在5分钟的无结构游戏后自行学习一项新的步行任务,然后在不需要任何额外编程的情况下适应其他任务。

人工神经网络使用来自电机的结果来创建输入(运动运动学)和输出(电机激活)之间的逆映射。人工神经网络根据强化学习阶段的每一次尝试更新模型,以磨练期望的结果。它每次都记住最好的结果,如果新的输入创建了更好的结果,它就用新的设置覆盖模型。

使用MATLAB和ANNS的生成和培训进行深度学习工具箱.MATLAB代码可在团队的GitHub..还写入了加强学习算法马铃薯.下面是机器人腿和训练结果的视频。

克利夫角:克利夫·莫尔谈数学和计算机

克利夫角:克利夫·莫尔谈数学和计算机 Loren在Matlab的艺术上

Loren在Matlab的艺术上 史蒂夫在图像处理与matlab

史蒂夫在图像处理与matlab 人在仿真软件金宝app

人在仿真软件金宝app 深度学习

深度学习 开发区域

开发区域 Stuart的Matlab视频

Stuart的Matlab视频 在头条线后面

在头条线后面 本周的文件交换选择

本周的文件交换选择 汉斯在物联网

汉斯在物联网 学生休息室

学生休息室 初创企业、加速器和企业家

初创企业、加速器和企业家 MATLAB社区

MATLAB社区 MATLABユーザーコミュニティー

MATLABユーザーコミュニティー

评论

要发表评论,请点击在这里登录您的MathWorks帐户或创建新的。