主要内容

rlDDPGAgent

深度确定性策略梯度强化学习agent

描述

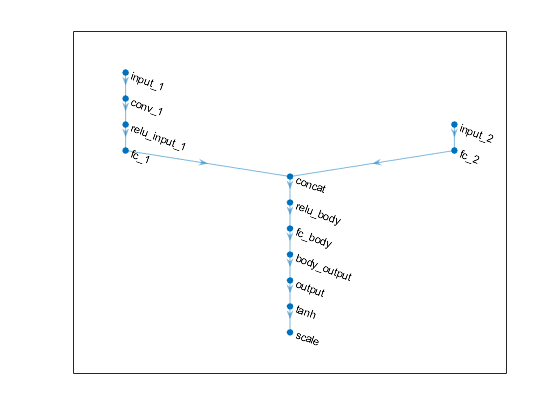

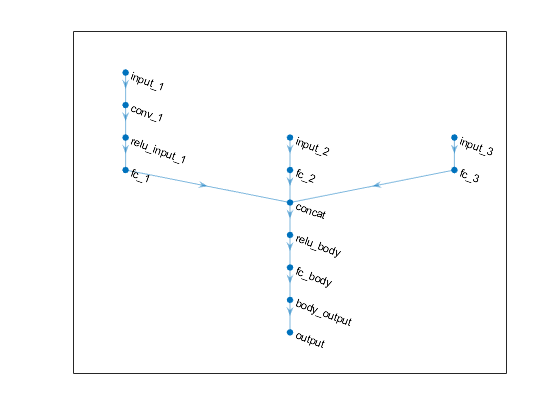

深度确定性策略梯度(deep deterministic policy gradient, DDPG)算法是一种无模型的、在线的、离线的强化学习方法,它计算出一个使长期回报最大化的最优策略。动作空间只能是连续的。

有关更多信息,请参见深度确定性政策梯度代理.有关不同类型的强化学习代理的更多信息,请参见强化学习代理.

创建

语法

描述

根据观察和动作规范创建Agent

代理= rlDDPGAgent (observationInfo,actionInfo)observationInfo还有动作规范actionInfo.

代理= rlDDPGAgent (observationInfo,actionInfo,initOpts)initOpts对象。有关初始化选项的更多信息,请参见rlAgentInitializationOptions.

指定代理选项

代理= rlDDPGAgent (___,agentOptions)AgentOptions财产agentOptions输入参数。在前面语法中的任何输入参数之后使用此语法。

输入参数

属性

对象的功能

例子

另请参阅

深层网络设计师|rlAgentInitializationOptions|rlDDPGAgentOptions|rlDeterministicActorRepresentation|rlQValueRepresentation

介绍了R2019a