SAE 2级自动化感知系统原型

今天的客座帖子是大卫·巴恩斯.大卫是MathWorks的研究生实习生,他还担任阿拉巴马大学(UA) EcoCAR机动挑战团队.UA团队完成了3个理查德·道金斯北美的12所大学中第一年比赛在乔治亚州的亚特兰大举行。David描述了EcoCAR Mobility Challenge团队是如何通过UA的设计实例为他们的自动化功能创建基础的。可以找到许多示例的代码在MATLAB中央文件交换中.

- - - - - -

通过基于模型的设计接近汽车系统

公元1年EcoCAR流动性的挑战竞赛展示了各车队为适应新兴的移动即服务(MaaS)市场而重新设计2019款雪佛兰Blazer的工作。查看更多关于四年的比赛这篇博客.环保汽车小组正在追击SAE级别2自动功能,能够通过自适应巡航控制(ACC)对车辆进行纵向和有限横向控制。ecoar团队正在研究互联和自动驾驶汽车(CAV)技术和车辆到一切(V2X)通信系统对能源消耗的影响。

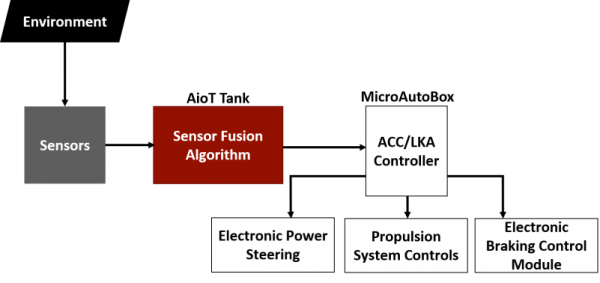

EcoCAR团队使用基于模型的设计有效迭代和改进CAV系统设计。第一年的CAV活动集中于车辆纵向控制所需的初始子系统。这些系统包括ACC、传感器硬件和传感器融合算法,其系统级交互如下所示:

图:UA CAV系统概述

可视化和模拟传感器,最大限度地检测

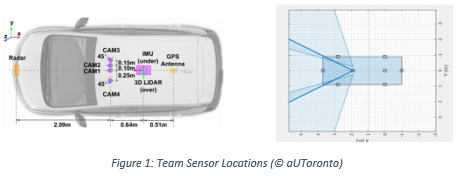

使用驾驶场景设计师在美国,EcoCAR团队基于组件规格表在模拟环境中创建传感器,团队使用鸟眼图(BEP)可视化传感器覆盖。EcoCAR移动挑战赛是由英特尔赞助的Mobileye 6系列系统给每个队。Mobileye使用了一个车载处理器,允许视觉系统识别行人、自行车、车辆、路标和车道标志。在白天,该系统可以探测到距离自我车辆(被控制车辆)150米以内的目标车辆(感兴趣的车辆)38°水平视野(FOV)。Mobileye的全部限制如下图所示:

博世,另一个ecoar机动挑战赞助商,提供了两种类型的雷达单元中档雷达(MRR)传感器阵容。这些是双静态,多模态雷达,通过改变水平视场角度为不同的探测距离扫描目标。MRR雷达视场从20°变化到12°,以探测在ego车辆前方160米范围内的目标车辆。MRR雷达上的一个仰角天线可以确定在ego车辆前面36米以内的物体的高度。另一种雷达选择,MRR后雷达,在最大距离70米和近距离,估计是12米,水平视场为150°。以下使用bep描述了这两种雷达的全部极限。

图:Bosch MRR雷达和MRR后雷达视场

尽管使用驾驶场景设计器(Driving Scenario Designer)在2D中显示检测结果,但这些传感器在垂直视场下操作时,是在3D中模拟的。垂直视场协助探测自我车辆在山上上下,目标车辆可能被扔下或天桥可能被识别为自我车辆路径中的静止物体。

小组调查了不同的传感器布局使用MATLAB脚本快速生成如下图所示的潜在配置的bep:

图:潜在的传感器布局

的传感器布局准尺寸雪佛兰外套然后在模拟路径中进行测试,在环境中添加道路和额外的车辆。这些模拟允许团队评估传感器布局的有效性,UA团队使用误差百分比公式评估布局的模拟:

UA小组创造了几个场景,从发现目标车辆进入ego车辆的车道开始。其他的模拟测试了感知系统在检测在弯道和盲道中的目标车辆时的极限。这些仿真结果的一个例子可以看到下面的GIF:

图:倾斜转弯模拟结果

理解感知系统的局限性

在分析了不同的潜在布局后,UA选择了下图中带有红色盲点的布局:

图:带有盲点的UA传感器布局

UA的布局在汽车挡风玻璃内部使用了Mobileye,在前筋膜中间安装了一个MRR雷达。四台MRR后雷达将被安置在车辆的四个角落,面向外45°。在这种布局中,对紧跟在Blazer后面的车辆的检测限制在ego车辆后面30米以内。

UA计划让Blazer根据驾驶员的要求改变车道,因此CAV系统必须确认两侧盲点没有物体。UA调查了两种边缘案例,一种是摩托车,另一种是电流最小的生产车辆精灵.如下图所示,Smart Fortwo(黄色)总是可以检测到,但摩托车(紫色)可能不会被检测到:

图:摩托车和Smart Fortwo在侧盲点

传感器融合通过多个传感器输入,为自我汽车周围的环境创建一个有凝聚力的画面。传感器融合可以跟踪物体,比如摩托车,即使物体处于自我车辆的盲点。这些重要的信息可以帮助缓解潜在的问题,并帮助决定允许ACC控制器满足驾驶员的变道请求。

传感器融合算法可以在MATLAB仿真软件金宝app,许多物体都可以使用卡尔曼滤波器在一个全局最近邻算法.这个数据流如下图所示:

图:数据流过CAV系统

使用驾驶场景设计器,UA团队使用来自模拟场景的数据实现算法。下面的GIF展示了一个简单的传感器融合仿真,跟踪一辆摩托车通过侧盲点:

图:使用传感器融合跟踪摩托车通过侧盲点

使用骡车验证模拟的测试组件

EcoCAR团队收到了英特尔和博世提供的硬件,用于在台式测试和骡车(用于测试的车辆)中实现传感器。UA使用了之前AVTC的2016款雪佛兰Camaro EcoCAR3作为CAV骡子车。Mobileye安装在挡风玻璃上,雷达通过吸力安装在前筋膜的外部,如下图所示。

图:UA的骡车传感器安装

Mobileye需要车辆信息来执行车载图像处理,通过OBDII端口提供给Mobileye。Mobileye只提供数据流,不传输视频,因此UA安装了英特尔捐赠的RealSense摄像机捕捉视频片段的数据验证和可视化。

图:Mobileye和RealSense相机安装

UA骡子车在阿拉巴马州的塔斯卡卢萨附近行驶,收集数据用于分析向量的硬件他是环保汽车移动挑战赛的赞助商。UA使用独木舟来记录移动眼的数据。原始数据被导出为。mat文件,并使用MATLAB函数显示在一个BEP上plotDetection.Mobileye的数据并不完美,如下图所示,与RealSense相机的视频传输相比,存在一些多余的检测:

图:从收集的数据中可视化测试结果

UA团队使用骡车,从收集到的Mobileye数据中测试了传感器融合算法。该测试车辆跟踪在传感器融合算法使用单一传感器。下面的GIF显示了当自我车辆接近停止的目标车辆时的原始检测数据:

图:从Mobileye收集的数据

下图为经过传感器融合处理后的目标车辆跟踪图,滤波后的跟踪历史和方向向量直观可见:

图:单传感器车辆跟踪

未来的工作

UA的感知系统将通过增加多个传感器来开发卡尔曼滤波器提高了多传感器的精度通过一个传感器系统。开发的传感器融合算法将在仿真环境中使用,并利用收集的数据跟踪传感器视场和盲点中的目标。UA团队将使用英特尔坦克AIoT部署传感器融合算法处理数据流使用ROS节点来自MATLAB/Simulink的机器人系统工具箱金宝app.处理后的数据将被开发团队使用ACC控制器向推进系统和转向系统发出正确的指令。

结论

EcoCAR团队测试了传感器布局和传感器融合算法,既有单独测试,也有集成测试。利用基于数据的决策,EcoCAR团队将继续向SAE 2级自动化功能迈进,并通过道路测试进行进一步的模拟和验证。

现在轮到你了!

你如何使用MATLAB和Simulink来开发自动化系统?金宝app您是否成功地使用多传感器感知系统来控制车辆、机器人或其他系统?

联系任何一个12大学如果您有兴趣参与这个项目或赞助团队关于移动的未来的工作!此外,您可以在社交媒体上关注生态汽车出行挑战:脸谱网,推特,Instagram,YouTube,LinkedIn

克利夫角:克利夫·莫尔谈数学和计算机

克利夫角:克利夫·莫尔谈数学和计算机 罗兰关于MATLAB的艺术

罗兰关于MATLAB的艺术 用MATLAB进行图像处理

用MATLAB进行图像处理 人在仿真软件金宝app

人在仿真软件金宝app 深度学习

深度学习 开发区域

开发区域 斯图尔特的MATLAB视频

斯图尔特的MATLAB视频 在标题后面

在标题后面 本周文件交换精选

本周文件交换精选 汉斯在物联网

汉斯在物联网 学生休息室

学生休息室 初创企业、加速器和企业家

初创企业、加速器和企业家 MATLAB社区

MATLAB社区 MATLABユーザーコミュニティー

MATLABユーザーコミュニティー

评论

要留下评论,请点击在这里登录到您的MathWorks帐户或创建一个新帐户。