深度学习自定义训练循环

定制深度学习训练循环和损失函数

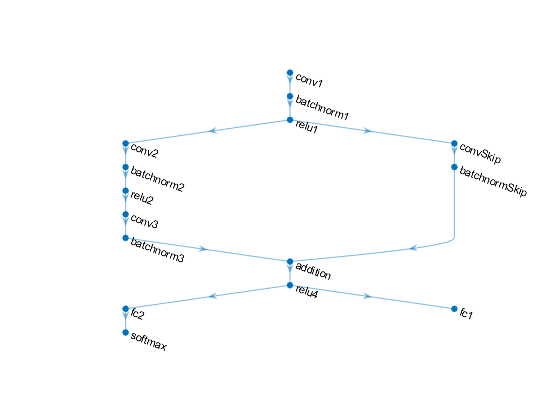

如果trainingOptions函数不提供任务所需的训练选项,或自定义输出层不支持所需的损失函数,则可以定义自定义训练循环。金宝app对于不能使用层图创建的网络,可以将自定义网络定义为函数。要了解更多信息,请参见定义自定义训练循环、损失函数和网络.

功能

主题

自定义训练循环

- 用MATLAB训练深度学习模型

学习如何在MATLAB中训练深度学习模型®. - 定义自定义训练循环、损失函数和网络

学习如何使用自动区分定义和定制深度学习训练循环、损失函数和网络。 - 使用自定义训练循环训练网络

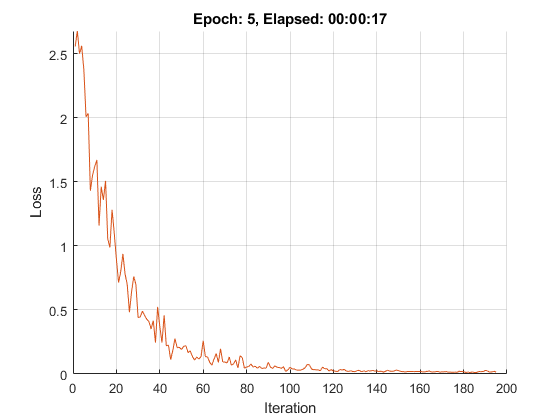

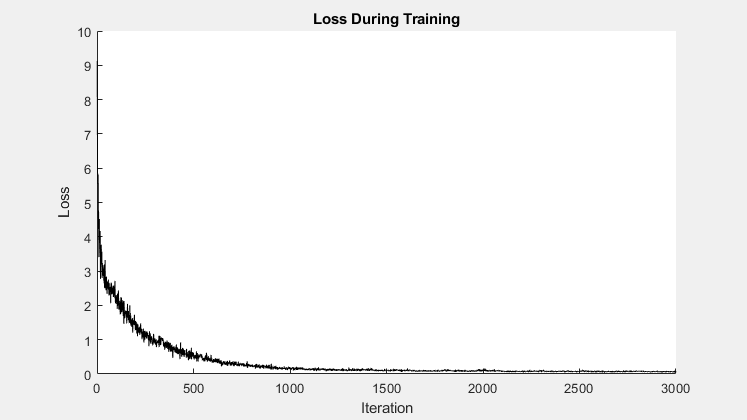

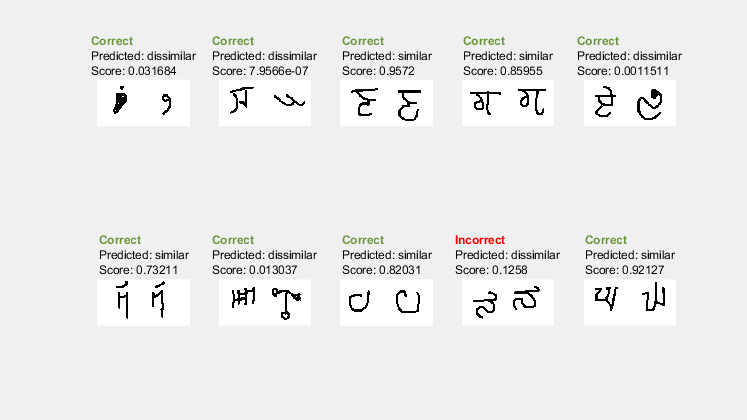

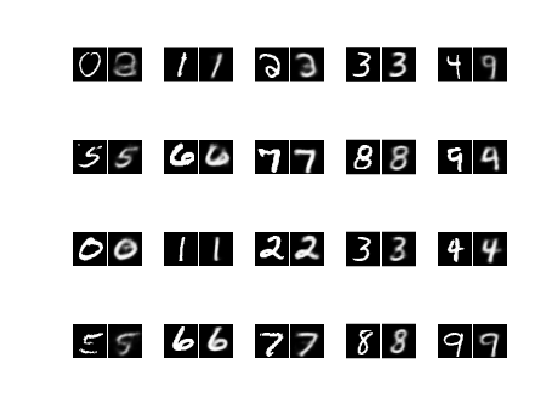

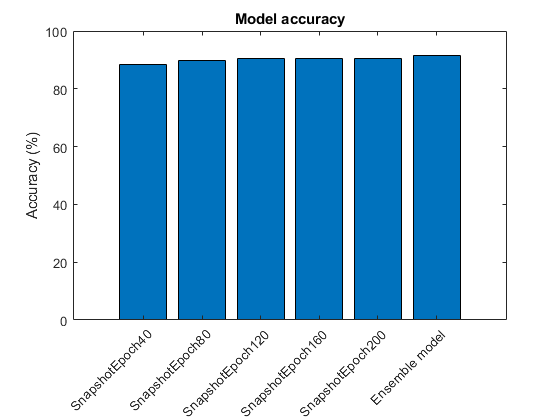

这个例子展示了如何训练一个使用自定义学习率计划分类手写数字的网络。 - 在自定义培训循环中指定培训选项

了解如何在自定义训练循环中指定常见训练选项。 - 定义自定义训练循环的模型损失函数

了解如何为自定义训练循环定义模型损失函数。 - 在自定义训练循环中更新批归一化统计数据

这个例子展示了如何在自定义训练循环中更新网络状态。 - 使用dlnetwork对象进行预测

这个例子展示了如何使用dlnetwork对象通过将数据分割为小批量。 - 监控定制培训循环进度

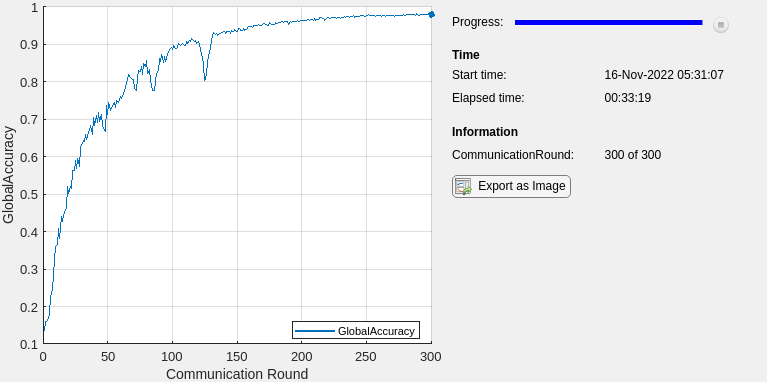

跟踪并绘制自定义训练循环进度。 - 训练多输出网络

这个例子展示了如何训练一个具有多个输出的深度学习网络,这些输出预测手写数字的标签和旋转角度。 - 使用自定义训练循环的深度学习分类视频

这个例子展示了如何通过结合预先训练的图像分类模型和序列分类网络来创建视频分类网络。 - 训练图像分类网络对对抗实例鲁棒性

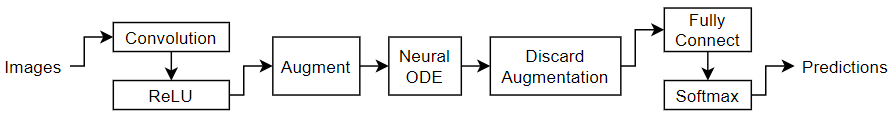

这个例子展示了如何使用快速梯度符号方法(FGSM)对抗训练训练一个对对抗例子鲁棒的神经网络。 - 训练神经ODE网络

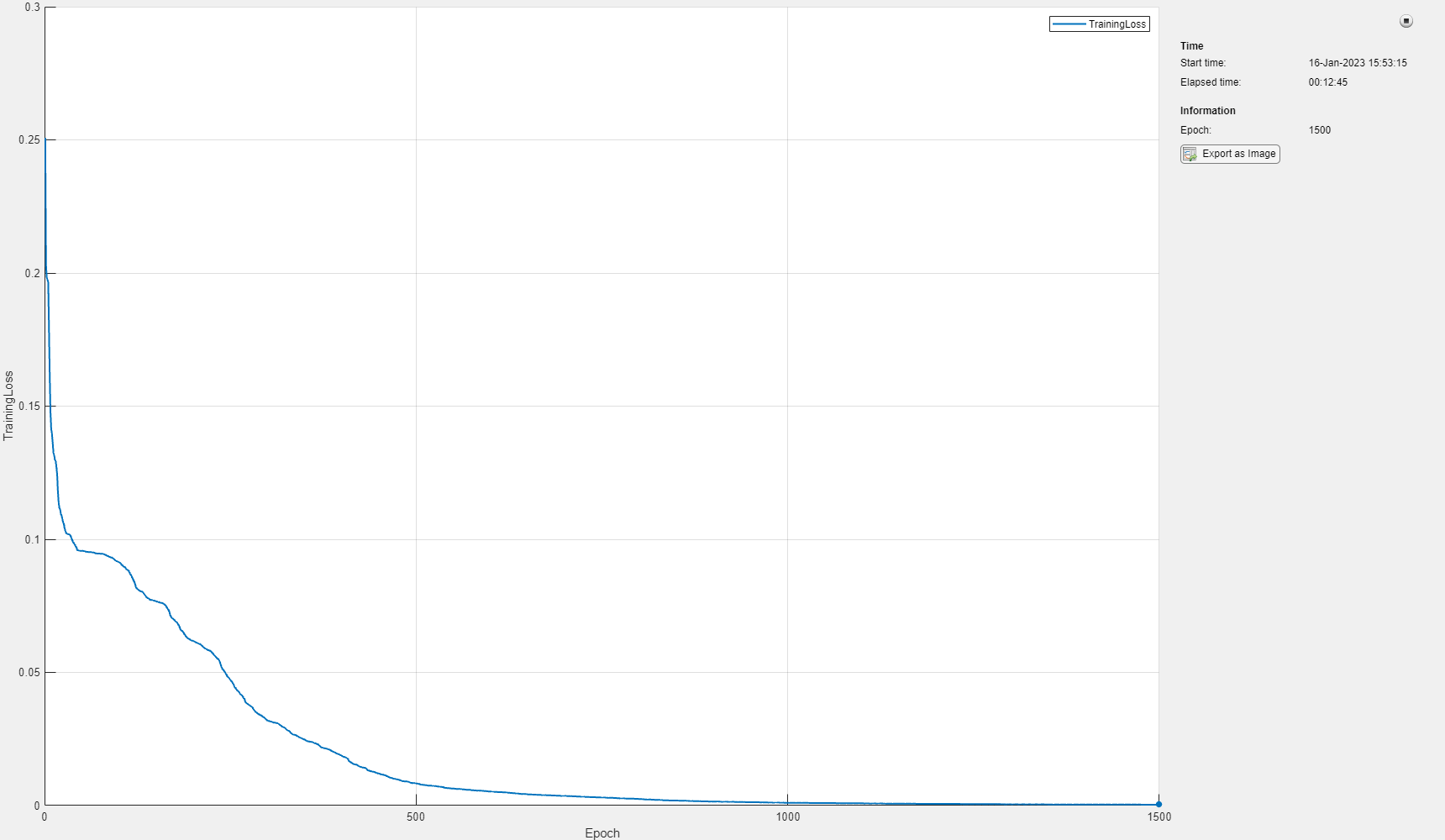

这个例子展示了如何训练增广神经常微分方程(ODE)网络。 - 用雅可比正则化训练鲁棒深度学习网络

这个例子展示了如何使用雅可比正则化方案[1]训练一个对对抗例子鲁棒的神经网络。 - 用神经网络求解常微分方程

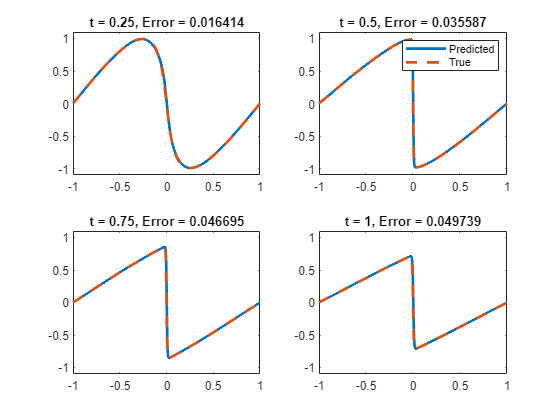

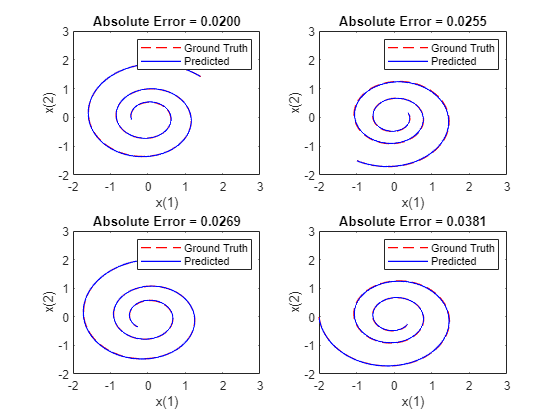

这个例子展示了如何用神经网络求解常微分方程(ODE)。 - 组合多输出网络进行预测

这个例子展示了如何组装一个用于预测的多输出网络。 - 在GPU上并行运行自定义训练循环

通过在GPU上运行、并行使用多个GPU或在集群上运行来加速自定义训练循环。

模型函数

- 利用模型函数训练网络

这个例子展示了如何通过使用函数而不是层图或函数来创建和训练深度学习网络dlnetwork. - 使用模型函数更新批归一化统计信息

此示例显示如何更新定义为函数的网络中的网络状态。 - 使用模型函数进行预测

这个例子展示了如何通过将数据分割成小批量来使用模型函数进行预测。 - 初始化模型函数的可学习参数

了解如何使用模型函数初始化自定义训练循环的可学习参数。 - 用不规则采样时间序列数据训练潜在ODE网络

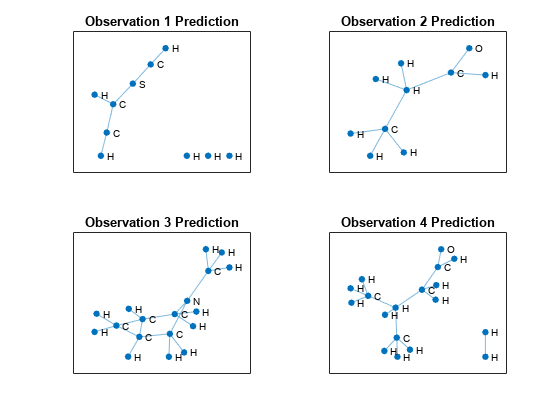

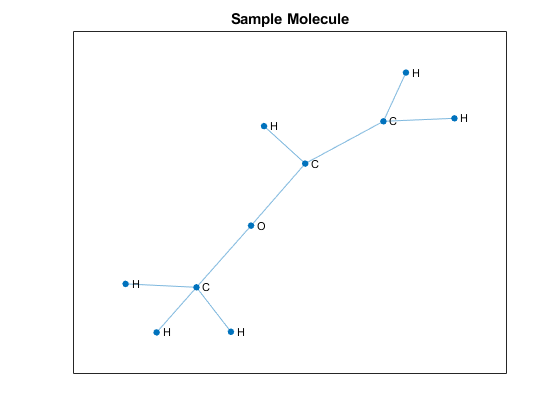

这个例子展示了如何用不规则时间间隔采样的时间序列数据训练潜在常微分方程(ODE)自编码器。 - 基于图神经网络的多变量时间序列异常检测

这个例子展示了如何使用图神经网络(GNN)检测多元时间序列数据中的异常。

自动分化

- 支持dlarray的函数列表金宝app

查看支持的函数列表金宝appdlarray对象。 - 自动判别背景

学习自动微分是如何工作的。 - 在深度学习工具箱中使用自动区分

如何在深度学习中使用自动微分。

深度学习函数加速

- 自定义训练循环的深度学习函数加速

通过缓存和重用跟踪,加速自定义训练循环的模型函数和模型损失函数。 - 加速自定义训练循环函数

这个例子展示了如何加速深度学习自定义训练循环和预测函数。 - 检查加速深度学习函数输出

这个例子展示了如何检查加速函数的输出是否与底层函数的输出匹配。 - 评估加速深度学习函数的性能

这个例子展示了如何评估使用加速函数的性能增益。