在Simulink中利用合成雷达和视觉数据进行传感器融合金宝app

这个例子展示了如何在Simulink®中使用自动驾驶工具箱™实现跟踪和传感器融合的合成数据仿真。金宝app它紧随着基于合成雷达和视觉数据的传感器融合MATLAB®示例。

介绍

模拟合成雷达和视觉检测提供了制造罕见和潜在危险事件的能力,并使用它们测试车辆算法。这个例子涵盖了Simulink中的整个合成数据工作流。金宝app

模型的设置和概述

在运行此示例之前驾驶场景设计器应用程序用于创建中定义的相同场景基于合成雷达和视觉数据的传感器融合。然后将此场景中的道路和参与者保存到场景文件中OpenLoop.mat.

的场景的读者block从保存的文件中读取演员姿势数据。block将演员姿势从场景的世界坐标转换为ego车辆坐标。演员姿势通过block生成的总线传输。

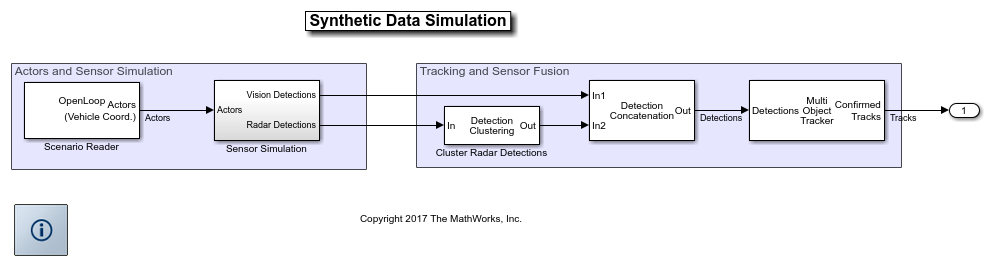

动作位姿由传感器仿真子系统使用,生成合成雷达和视觉检测。仿真检测连接在多目标跟踪器块的输入端,其输出是已确认的轨迹列表。最后,鸟瞰镜将演员、视觉和雷达探测、确认的轨迹和道路边界可视化。下面的部分描述了这个模型的主要部分。

模拟传感器检测

在这个例子中,您模拟一个ego车辆,它有6个雷达传感器和2个视觉传感器,覆盖360度视野。传感器存在一定的重叠和覆盖间隙。ego车辆在前部和后部都配备了远程雷达传感器和视觉传感器。车辆的每一侧都有两个近程雷达传感器,每个覆盖90度。两侧各有一个传感器,覆盖车辆的中部到尾部。两侧的另一个传感器从车辆的中间向前覆盖。

当您打开传感器模拟子系统时,您可以看到视觉检测发电机块,配置为从自我车辆的前面和后面产生检测。视觉检测发生器的输出连接到检测级联接下来,子系统包含六个雷达检测发电机块,配置如前一段所述。雷达探测发生器的输出被连接起来,然后使用检测聚类块进行聚类。

跟踪与传感器融合

来自视觉和雷达传感器的检测必须首先连接起来,形成一个单一的输入多目标跟踪块。Concatenation使用一个额外的Detection Concatenation块完成。

多目标跟踪器模块负责融合来自所有检测的数据,并跟踪自我车辆周围的目标。多目标跟踪器的参数配置与相应的MATLAB例子中使用的相同,基于合成雷达和视觉数据的传感器融合.多目标跟踪器块的输出是一个确认轨道的列表。

创建和传播总线

本例中各个模块的输入和输出均为金宝app仿真软件。公共汽车(金宝app模型)“汽车”,总线将自动创建,并将其名称传播到使用此总线作为输入的块。当设置为“属性”,您可以定义输出总线的名称。下图显示了检测总线、单个检测总线、轨道总线和单个轨道总线。

显示

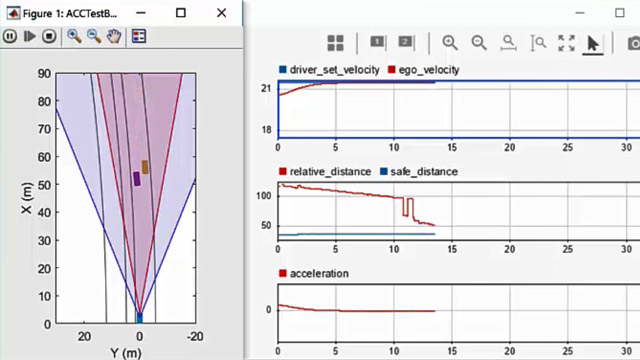

的鸟瞰的范围是一个可以从Simulink工具条打开的模型级可视化工具。金宝app在模拟选项卡,在审查结果点击鸟瞰的范围.打开作用域后,单击寻找信号来设置信号。然后运行模拟以显示角色、视觉和雷达探测、轨迹和道路边界。下面的图片显示了这个例子的鸟瞰图。